Linux (fr)

-

L’heure du test — fork 1 — Void (Linux)

(Dépêches LinuxFR)

Voici un tour d’horizon d’une distribution peu connue mais néanmoins intéressante : Void (Linux) !

Void est une distribution indépendante, créée de zéro (from scratch, pas une divergence de Debian ou autres). Elle est développée par une communauté de volontaires et vous pouvez facilement y contribuer via ses dépôts sur GitHub. C’est une distribution avec mise à jour en continu (rolling‐release), tournée vers les ordinateurs de bureau et qui se veut légère et performante.NdM. : Cette dépêche est inspirée par L’heure du test — épisode 1 — NixOS postée par gusterhack. Si vous aussi vous voulez parler de votre distribution ou logiciel libre préféré, n’hésitez pas.

- lien n°1 : The Void (Linux) distribution

- lien n°2 : L’étiquette « test » sur LinuxFr.org

- lien n°3 : La catégorie « Distribution » sur LinuxFr.org

- lien n°4 : L’heure du test — épisode 1 — NixOS

- lien n°5 : Wikipédia : Void Linux

Sommaire

- La distribution Void

- Installation et configuration

- Le système d’initialisation runit

- Le gestionnaire de paquets xbps

- Écrire et soumettre des paquets

- Conclusion

La distribution Void

L’aventure Void Linux a commencé en 2008 lorsque Juan Romero Pardines, un ancien mainteneur de NetBSD voulait tester son gestionnaire de paquets xbps. Depuis, elle a grandi pour avoir tout ce qu’il faut. Le système de base est totalement libre, dépourvu de blobs binaires venus des constructeurs. Les utilisateurs disposent cependant du dépôt non‐free pour installer des bouts de code propriétaires.

D’un point de vue utilisateur

Void est une distribution avec mise à jour en continu (rolling‐release), orientée bureau et qui se veut légère et performante. Elle se destine principalement à des utilisateurs de niveau intermédiaire ou avancé et peut être conseillée si vous voulez :

- avoir des logiciels toujours à jour ;

- ressusciter une vieille machine ;

- développer en utilisant plein de bibliothèques récentes ;

- utiliser une distribution avec une approche moderne (gestion des paquets, système d’initialisation…).

En revanche, Void n’est pas à conseiller si vous cherchez :

- une distribution ultra simple à installer et à configurer ;

- une logithèque ultra fournie ;

- une distribution ultra stable qui doit tourner sans redémarrage pendant dix ans.

D’un point de vue technique

Void est une distribution indépendante, créée « from scratch » (pas une divergence de Debian ou autres). Elle est développée par une communauté de volontaires et vous pouvez facilement y contribuer via ses dépôts sur GitHub.

Void est disponible pour les architectures x86 et ARM, ainsi que compilé avec glibc (la bibliothèque C de GNU) ou avec musl-libc (une alternative plus légère à glibc).

Void est une rolling‐release, c’est‐à‐dire que le système et les paquets sont mis à jour en continu ; il n’y a pas de « version » de la distribution. Void utilise son propre gestionnaire de paquets, xbps, qui est très similaire aux classiques apt, dnf, pacman et autres. Il y a un dépôt officiel ainsi qu’un dépôt « non‐free » et il est relativement facile de faire ses propres paquets.

Enfin, Void utilise par défaut LibreSSL (l’alternative à OpenSSL développée suite à la faille de sécurité Heartbleed) ainsi que le système d’initialisation runit (alternative à systemd).

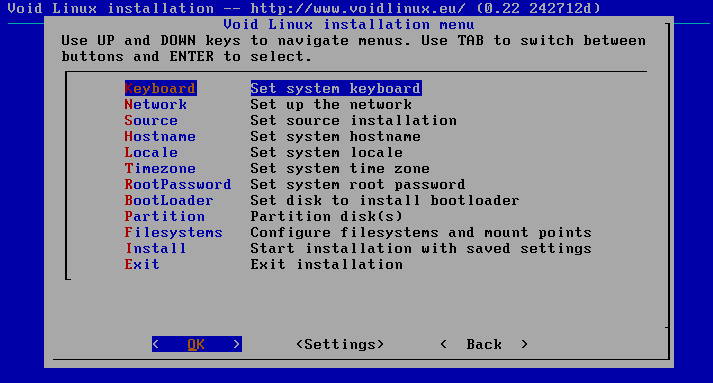

Installation et configuration

L’installation de Void est très classique et bien décrite dans la page Installation du Wiki :

- on télécharge une image ;

- on amorce le système sur l’image et l’on arrive sur un shell ;

- on se connecte en root (mot de passe : « voidlinux ») ;

- on peut passer le clavier en français avec

loadkeys fret voir la doc avecAlt+F8; - on lance l’installeur avec

void-installer; - on règle les classiques configurations et partitionnement, puis on lance l’installation ;

- on redémarre sur le système installé et l’on termine la configuration comme décrit dans la page Post‐installation du Wiki.

Le système d’initialisation runit

Void utilise runit pour initialiser le système et gérer les services, ce qui en fait l’une des rares distributions actuelles à ne pas utiliser systemd (sans entrer dans le débat pro ou anti systemd). À l’usage basique de tous les jours, runit se révèle vraiment facile et rapide ; voir la doc runit dans le Wiki.

Activer ou désactiver des services

Les services disponibles sont dans

/etc/sv/. Pour activer un service, il suffit d’ajouter un lien symbolique dans/var/service/. Par exemple, pour activer sshd :# ln -s /etc/sv/sshd /var/service/Pour désactiver un service, il suffit de supprimer le lien symbolique correspondant, dans

/var/service/. Par exemple, pour désactiver sshd :# rm -r /var/service/sshdGérer des services

L’utilitaire

svpermet de démarrer (start), d’arrêter (stop) ou d’interroger (status) un service. Par exemple, pour interroger sshd :# sv status sshd run: sshd: (pid 775) 17011sLe gestionnaire de paquets xbps

La gestion des paquets est expliquée en détails dans la page xbps du Wiki. À l’usage, xbps est vraiment rapide (en même temps, ça vaut mieux car le système est en rolling‐release et il y a des mises à jour tous les jours).

Fonctionnalités de base

Installer un paquet (par exemple le client IRC hexchat) :

# xbps-install hexchatChercher un paquet parmi les paquets disponibles dans les dépôts :

$ xbps-query -Rs hexchat [*] hexchat-2.12.4_2 A GTK+ based IRC client successor of Xchat [-] hexchat-lua-2.12.4_2 A GTK+ based IRC client successor of Xchat - lua plugin [-] hexchat-perl-2.12.4_2 A GTK+ based IRC client successor of Xchat - perl plugin [-] hexchat-python-2.12.4_2 A GTK+ based IRC client successor of Xchat - python pluginAfficher les informations d’un paquet installé :

$ xbps-query hexchat architecture: x86_64 build-date: 2017-04-12 08:50 CEST ... short_desc: A GTK+ based IRC client successor of Xchat source-revisions: hexchat:66e4fa9536 state: installedMettre à jour le système :

# xbps-install -SuSupprimer un paquet :

# xbps-remove hexchatSupprimer tous les paquets obsolètes :

# xbps-remove -OoAfficher les autres noyaux disponibles sur la machine :

$ vkpurge list 4.10.10_1 4.9.11_1Supprimer un noyau :

# vkpurge rm 4.9.11_1La politique de paquets de Void

Malgré quelques manques (notamment KDE 5), la logithèque de Void est assez fournie, au moins 8 000 paquets. Ce nombre peut paraître faible en comparaison des 43 000 paquets proposés par Debian, mais ce n’est pas tout à fait le cas, car Void réutilise les gestionnaires de paquets proposés par les différents langages et outils. Ainsi, là où Debian propose de nombreux paquets pour les bibliothèques Haskell, les packages LaTex et les greffons Vim, Void préfère généralement passer par les gestionnaires respectifs (cabal / stack, tlmgr, vundle), ce qui n’est pas comptabilisé dans les paquets de la distribution.

Écrire et soumettre des paquets

Void permet bien entendu de compiler et d’installer des logiciels « à la main ». Cependant, si vous voulez faire une installation propre, vous pouvez créer un paquet et l’installer via le gestionnaire xbps (voir la page xbps-src dans le Wiki). Et si votre paquet fonctionne bien, vous pourrez même facilement le proposer aux mainteneurs de Void pour qu’il soit intégré dans le dépôt officiel.

Initialisation d’un dépôt de paquets

Pour créer des paquets Void, le plus simple est de cloner le dépôt officiel de Void, puis d’en diverger en y créant ses paquets.

Le dépôt de paquets contient un programme

xbps-srcpour compiler des paquets. Pour pouvoir l’utiliser, il faut d’abord initialiser un environnement de compilation :$ ./xbps-src binary-bootstrapCréer un paquet

Imaginons, par exemple, que vous voulez empaqueter le programme GNU-hello. Commencez par créer une branche « hello » dans le dépôt de paquets :

$ git checkout -b helloInitialisez un nouveau paquet hello :

$ xnew helloCeci crée un fichier

srcpkgs/hello/templatequi contiendra la description du paquet et les instructions de compilation. Éditez ce fichier pour votre paquet :# Template file for 'hello' pkgname="hello" version="2.10" revision=1 build_style=gnu-configure distfiles="https://ftp.gnu.org/gnu/hello/${pkgname}-${version}.tar.gz" checksum="31e066137a962676e89f69d1b65382de95a7ef7d914b8cb956f41ea72e0f516b" short_desc="Produces a familiar, friendly greeting" homepage="https://www.gnu.org/software/hello/" license="GPL"Vous pouvez déterminer la somme de contrôle avec la commande :

$ xgensum -f srcpkgs/hello/templateUne fois le fichier de configuration écrit, lancez la compilation et la création du paquet :

$ ./xbps-src pkg helloSi tout s’est bien passé, vous pouvez alors installer votre paquet sur votre machine :

# xbps-install --repository=hostdir/binpkgs/hello/ helloSoumettre un paquet

Si votre paquet fonctionne correctement, vous pouvez le proposer à la communauté pour qu’il soit intégré dans les paquets Void officiels. Tout d’abord, comme Void est disponible pour plusieurs architectures et libc, il faut commencer par tester si le paquet peut se compiler correctement sur d’autres architectures, par exemple pour ARM7, avec musl-libc :

$ ./xbps-src -a armv7l-musl pkg helloCréez ensuite un commit décrivant votre contribution et envoyez‐le dans une branche spécifique sur le serveur :

$ git add srcpkgs/hello/template $ git commit -am "New package: hello-2.10" $ git push -u origin helloIl ne vous reste plus qu’à vous connecter sur GitHub et à créer une demande d’intégration _— pull request — de votre commit dans le dépôt officiel. Si des modifications vous sont demandées, pensez à travailler toujours sur le même commit et la même branche distante :

$ git commit -a --amend $ git push -fConclusion

Void (Linux) est une distribution peu connue mais dont les choix techniques originaux sont plutôt appréciables à l’usage. Elle est légère, rapide, très à jour et facile à configurer « dans l’esprit UNIX ». En revanche, elle n’est pas destinée à des débutants et n’a pas la logithèque la plus complète qui soit.

Personnellement, j’utilise Void tous les jours pour des usages classiques de bureautique, Web, multimédia, ainsi que pour développer en C++ et en Python avec toutes sortes de bibliothèques. En un an d’utilisation, je n’ai pas réussi à la casser ni à avoir de conflits majeurs. En deux occasions, la mise à jour du système ne fonctionnait pas, mais à chaque fois il a suffit d’attendre un jour ou deux pour que les mainteneurs corrigent le problème et que les mises à jour fonctionnent à nouveau.

-

Espionnage: la FSF deconseille le cloud public, recommande les clouds privés basés sur le libre

(Journaux LinuxFR)

Le journal The Guardian a révélé que la NSA (Agence de Sécurité Nationale des États-Unis) a un accès direct aux systèmes de Google, Facebook, Apple et autres géants de l'Internet, pour espionner les communications qui passent par les États-Unis. John Sullivan, directeur de la Free Software Foundation, conseille d'utiliser des logiciels libres (en cloud privé) plutôt que le cloud public:

Des intrusions de la vie privée de cette ampleur sont à craindre quand les gens abandonnent leurs données et logiciels locaux pour migrer vers le stockage et les applications en ligne. Les géants come Microsoft, Facebook et Google sont vulnérables aux requêtes du gouvernement exigeant les données des utilisateurs. Pour contrer ce problème, il y a de meilleurs moyens, plus sûrs, de partager des informations en ligne. Les logiciels libres comme GNU MediaGoblin, StatusNet, Diaspora, pump.io, Tahoe-LAFS, FreedomBox et SparkleShare travaillent d'arrache-pied pour créer un monde moins centralisé, un monde dans lequel les utilisateurs maintiennent le contrôle sur leurs données et sur les logiciels qui accèdent à ces données, mais un monde qui est tout aussi pratique et social que son équivalent centralisé.

MediaGoblin: Publication de media. Similaire à Flickr, YouTube, SoundCloud.

StatusNet: Micro-blogging. Similaire à Twitter.

Diaspora, pump.io, Freedombox: Réseau social décentralisé. Similaire à Facebook.

Tahoe-LAFS, SparkleShare, CmisSync: Synchronisation de fichiers. Similaire à Dropbox.

Zimbra: Email. Similaire à Gmail/Calendar. -

Prince: bronsorisé :(

(Journaux LinuxFR)

Il était tout à la fois Marvin Gaye, Sly Stone, James Brown, Georges Clinton et Jimi Hendrix.

le Frank Zappa de la musique noire, fantasque, exigeant mais surtout génial.

R.I.P -

Votre Service Client "La Fibre"

(Journaux LinuxFR)

Chère cliente, cher client,

Chaque année plus d’1 million d’impacts de foudre ont lieu en France

(blabla)C'est pourquoi, en cas d'absence prolongée ou en période d'orages, nous vous recommandons >de protéger votre Livebox en la débranchant de la prise téléphonique puis de >l'alimentation électrique.

(blabla)Votre service clients La Fibre

fear

j'espère ne jamais avoir à faire avec eux, s'ils pensent qu'une LiveBox Fibre Optique se débranche de la Prise Téléphonique. -

PROXMOX VE a 10 ans

(Dépêches LinuxFR)

Cette semaine marque le dixième anniversaire du projet libre Proxmox Virtual Environment (VE), développé et maintenu par Proxmox Server Solutions, basé en Autriche.

Proxmox VE 0.9, la plate‐forme libre de virtualisation, a été annoncée dans une première version publique il y a dix ans le 15 avril 2008 et la solution a permis de gérer KVM et OpenVZ sur une seule interface de gestion. Depuis lors, cinq versions majeures et de nombreuses mineures ont été produites.

- lien n°1 : Plus sur l’histoire du projet Proxmox VE

- lien n°2 : Feuille de route

- lien n°3 : Annonce sur le forum

Aujourd’hui, la version actuelle de Proxmox VE 5.1 permet aux administrateurs de contrôler l’ensemble de leur environnement informatique virtualisé avec un seul outil de gestion. Proxmox VE prend en charge deux technologies de virtualisation (KVM et LXC – qui a remplacé OpenVZ avec la version 4.0) et offre une API REST, un réseau flexible, des fonctionnalités pour offrir une grappe de serveurs (cluster) à haute disponibilité, un stockage défini par logiciel, des fonctionnalités de sauvegarde et restauration, un pare‐feu, et beaucoup d’autres outils prêts à l’emploi et de technologies libres intégrées. Depuis la version 5.1 Proxmox VE aussi intègre Ceph storage 12.2.x Luminous LTS, pour l’implémentation d’infrastructures hyper‐convergentes.

Il y a dix ans, les développeurs de Proxmox ont été les premiers à relier les deux technologies de virtualisation KVM et conteneurs (initialement OpenVZ) sur une seule plate‐forme et à les rendre facilement gérables via une interface Web. Lors du lancement du développement de Proxmox VE en 2007, les deux fondateurs de Proxmox, Dietmar Maurer (CTO) et Martin Maurer (CEO), l’ont conçu comme un CD d’installation « bare‐metal » contenant une version très modifiée de Debian GNU/Linux optimisée pour un serveur de virtualisation. Ils ont utilisé un noyau Linux modifié qui comprenait tout le nécessaire pour KVM et OpenVZ. Peu de temps après le lancement de la 0.9, la première version stable de Proxmox VE 1.0 était disponible, en 2008, avec de nouvelles fonctionnalités. Il devenait alors possible pour les utilisateurs de virtualiser des applications GNU/Linux et Windows exigeantes, d’appliquer la migration en direct et de sauvegarder leurs données via vzdump depuis l’interface graphique.

« Il est difficile de croire que Proxmox VE a dix ans aujourd’hui, et c’est formidable de voir à quel point il est devenu populaire » dit Martin Maurer, CEO de Proxmox. « Lors de la première publication de Proxmox VE, il n’existait aucune interface de gestion sur le marché permettant de gérer facilement KVM ou OpenVZ. Nous étions, pour autant que je sache, l’un des premiers projets à intégrer la prise en charge des machines virtuelles et des conteneurs sur une interface graphique centrale. Proxmox VE a été conçu pour répondre à ce besoin. Au fil des années, il a ajouté de nombreuses fonctionnalités et a été dimensionné pour répondre aux exigences des entreprises et des utilisateurs souhaitant disposer d’une plate‐forme libre pour gérer facilement la virtualisation, le réseau et le stockage. »

Aujourd’hui, Proxmox VE est traduit en 19 langues et compte environ 200 000 hôtes installés dans plus de 142 pays. La société Proxmox Server Solutions offre un accès par abonnement au support technique et aux paquets du référentiel stable. Plus de 11 000 clients allant des moyennes entreprises aux grandes entreprises, aux organismes sans but lucratif et aux particuliers ont un abonnement actif. Les forfaits varient entre 75 et 800 euros par processeur et par an, et permettent d’accéder au support technique et au référentiel d’entreprise stable qui fournit des paquets fortement testés et validés.

Proxmox VE, un projet libre de dix ans, sous licence libre GNU Affero GPL v3, offre des versions régulières et continues, et est devenu l’alternative libre aux solutions propriétaires pour la virtualisation de centre de données (datacenters) ou pour des solutions complexes de gestion d’informatique en nuage (cloud).

« Proxmox VE est devenue une puissante plate‐forme de gestion de virtualisation d’entreprise qui permet à nos utilisateurs de gérer facilement toute leur infrastructure virtualisée », explique Martin Maurer. « Nous avons parcouru un long chemin maintenant et nous ne serions pas là sans nos clients, nos utilisateurs et nos partenaires qui nous soutiennent et nous poussent constamment avec des commentaires et de nouvelles demandes de fonctionnalités. Plus important encore, nous sommes reconnaissants de tout le travail intense et des toutes les contributions de notre fantastique équipe. La conception architecturale de notre plate‐forme et le modèle de développement open-source nous permettent de nous adapter constamment aux dernières technologies et d’adapter Proxmox VE aux demandes informatiques croissantes de notre communauté. Pour notre prochaine version, Proxmox VE 5.2, nous avons par exemple Cloudinit sur la feuille de route qui, nous l’espérons, fera le bonheur de beaucoup de nos utilisateurs. »

Commentaires : voir le flux atom ouvrir dans le navigateur

-

PyConFR 2018, du 4 au 7 octobre à Lille : appel à contributions

(Dépêches LinuxFR)

La PyConFR, c’est le rassemblement annuel francophone de passionnés et curieux du langage Python. Cette année, on invite la communauté à se retrouver à Lille du 4 au 7 octobre.

Pour ceux qui ne connaissent pas la formule, les deux premiers jours (jeudi et vendredi) sont dédiés à des sprints (hackathons), et le week‐end sera rempli de conférences et d’ateliers découverte.

Contribuez à cette édition et aidez‐nous à la rendre mémorable en proposant du contenu : conférences, ateliers, sprints !

Quelques idées de sujets : enseignement du langage, montée en charge (scaling), sécurité, science des données, apprentissage automatique (machine learning), retour d’expérience, empaquetage, présentation d’une bibliothèque, Internet des objets (IoT), asynchrone, communauté, diversité, pyre-check, 2to3, PyPy, Python vs Go, intégration et livraison continues (CI/CD), stockage de données, agents conversationnels (chatbots), Python magic, Ansible vs SaltStack et tellement d’autres…

- lien n°1 : PyConFR 2018

- lien n°2 : AFPy

- lien n°3 : L’appel à proposition

- lien n°4 : Soumettre une proposition

- lien n°5 : Suivez‐nous sur Twitter

- lien n°6 : Meetup Python Lille

- lien n°7 : Martine découvre Python

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Tour d'horizon des éditeurs de texte pour le terminal

(Journaux LinuxFR)

Sommaire

Le nombre d'éditeurs de texte disponible sur nos systèmes d'exploitation est très important, même en se limitant à ceux s'exécutant dans un terminal.

La sélection suivante est donc forcement partielle. Dans la suite je parlerais des principaux éditeurs, de leurs clones, des anciens moins connu et enfin des plus récents.

La famille vi

La particularité de cette famille est d'être modale, les touches ont une action différente selon le mode dans lequel on est. De plus vi est dans la norme POSIX, donc tous les OS de type POSIX embarque un clone de vi.

Voir l'histoire de vi : wikipedia - Vi History

elvis

Elvis est un des premiers clone de vi (avec Stevie)

- url: elvis.the-little-red-haired-girl.org

- filiation: vi

wikipedia: wikipedia - Elvis

code source : github.com/mbert/elvis

début du développement: ~ 1990

langage : C

utf-8: ko

debian: tracker.debian.org/pkg/elvis

nvi

Nvi est une réécriture du vi des BSD 4.4 à partir du code d'Elvis.

- url: sites.google.com/a/bostic.com/keithbostic/vi

- filiation: vi

wikipedia : wikipedia.org - Nvi

code source : repo.or.cz/w/nvi.git

début du développement: 1986

langage : C

utf-8: ok

debian: tracker.debian.org/pkg/nvi

vim

Vim est certainement le clone de vi le plus utilisé aujourd'hui. Il est disponible sur de nombreuses plateformes et une vie entière ne suffit pas a faire le tour de ses fonctions.

- url: www.vim.org

- filiation: vi, Stevie

wikipedia: wikipedia - Vim

code source : code.google.com/p/vim

début du développement: ~ 1990

langage : C + VimL

utf-8: ok

debian: tracker.debian.org/pkg/vim

neovim

Neovim est un fork de vim.

Voir la dépêche sur le sujet, neovim une refonte de vim pour le 21e siecle

- url: neovim.org

filiation: vim wikipedia:

code source: github.com/neovim/neovim

début du développement: 2014

langage: C + Lua

utf-8: ok

debian:

kakoune

Éditeur qui s'inspire de vim mais a sa propre philosophie (voir le

répertoire doc/)- url: github.com/mawww/kakoune

- filiation: vim

wikipedia:

code source: github.com/mawww/kakoune

début du développement: 2011

langage : C++11

utf-8: ok

debian:

La famille emacs

M-x editeur

wikipedia - Liste des implémentations d'Emacs

emacs

On ne le présente plus, le plus difficile étant de trouver quelque chose qu'on ne peut pas faire dans emacs.

- url: www.gnu.org/software/emacs

- filiation: TECO wikipedia - TECO

wikipedia: wikipedia - Emacs

code source: git.savannah.gnu.org/cgit/emacs.git

début du développement: 1976, GNU emacs 1984

langage : C + elisp

utf-8: ok

debian: tracker.debian.org/pkg/emacs24

note: se lance en ligne de commande avec l'option

-nwpour--no-window-systemuemacs

Version légère et portable d'emacs.

- url: www.aquest.com/emacs.htm

- filiation: emacs

- wikipedia: wikipedia - MicroEMACS

Linus Torvalds maintient une ancienne version de uemacs et l'a fait

depuis évoluer.- code source: git.kernel.org/cgit/editors/uemacs/uemacs.git

- langage : C

- utf-8: ok (La version de Torvalds)

mg

Version très portable de uemacs nommé initialement Micro GNU/emacs.

- url: homepage.boetes.org/software/mg

filiation: uemacs

wikipedia: wikipedia - Mgcode source: bxr.su/OpenBSD/usr.bin/mg

début du développement: 1986

langage : C

utf-8: ko

debian: tracker.debian.org/pkg/mg

zile

zile est une implémentation d'emacs plus limité et plus légère.

- url: www.gnu.org/software/zile

- filiation: uemacs

wikipedia: wikipedia - Zile

utf-8: ko

debian: tracker.debian.org/pkg/zile

La famille à menu

Les éditeurs de cette famille ont comme point commun, d'être plus

abordable pour le novice en fournissant un menu permettant l'auto-découverte.nano

Nano est la version GNU de Pico (Pine Composer), l'éditeur de texte du client mail Pine.

- url: www.nano-editor.org

- filiation: pico

wikipedia: wikipedia - GNU nano et wikipedia.org - Pico

langage : C

début du développement: 1999

utf-8: ok

debian: tracker.debian.org/pkg/nano

Note: Pico est aussi disponible dans Debian,

packages.debian.org/jessie/alpine-picoJed

Jed associe les fonctionnalités d'un éditeur très extensible pour développeur à une interface facile basé sur un menu.

- url: www.jedsoft.org/jed

- filiation:

wikipedia: wikipedia - JED

code source: git://git.jedsoft.org/git/jed.git

début du développement: 2006 ?

langage : C + S-Lang

utf-8: ok

debian: tracker.debian.org/pkg/jed

ne

ne, le nice editor semble être un bon compromis entre richesse des

fonctions et simplicité. Cet éditeur possède un jeu de fonctions

(commandes) qui peuvent être lié a une séquence de touche ou à une

entrée de menu.- url: ne.di.unimi.it

- filiation: TurboText ; www.monkeyhouse.eclipse.co.uk/amiga/turbotext

wikipedia: wikipedia - Ne

début du développement: 1993

langage : C

utf-8: ok

debian: tracker.debian.org/pkg/ne

mcedit

mc (mindnight commander) propose un éditeur très complet, mcedit.

- url: www.midnight-commander.org

- filiation:

wikipedia:

code source: www.midnight-commander.org/browser

début du développement: 1994

langage : C

utf-8: ok

debian: tracker.debian.org/pkg/mc

kaa

Encore un éditeur avec un menu, celui-ci extensible en Python.

- url: kaaedit.github.io

- filiation:

wikipedia:

code source: github.com/kaaedit/kaa

début du développement: 2013

langage : Python 3 + C

utf-8: ok

debian:

Les autres

Des éditeurs qui ne rentrent pas dans les précédentes catégories ou qui peuvent les imiter toutes.

Joe

Un des plus ancien challenger.

- url: joe-editor.sourceforge.net

- filiation: WordStar, Emacs

wikipedia: wikipedia - Joe Own Editor

code source: sourceforge.net/p/joe-editor/mercurial/ci/default/tree

début du développement: 1988

langage : C

utf-8: ok

debian: tracker.debian.org/pkg/joe

Diakonos

L'objectif principal de Diakonos est de proposer un éditeur en console avec les raccourcis clavier classique d'une application graphique tel un navigateur ou un traitement de texte.

- url: diakonos.pist0s.ca

- filiation:

wikipedia: wikipedia - Diakonos

code source: github.com/Pistos/diakonos

langage : Ruby

début du développement: 2004

utf-8: ok

debian: tracker.debian.org/pkg/diakonos

Yi

Yi est un éditeur de texte écrit et extensible en Haskell.

- url: www.haskell.org/haskellwiki/Yi

- filiation:

wikipedia: wikipedia - Yi

code source: github.com/yi-editor/yi

langage : Haskell

début du développement: 2004

utf-8: ok

debian: tracker.debian.org/pkg/yi

Textadept

Textadept est un éditeur graphique qui propose aussi une interface

curse. Celui-ci est extensible en Lua. L'auteur utilisant le composant Scintilla pour la version graphique, celui-ci a développé une version pour curse scinterm- url: foicica.com/textadept

- filiation:

wikipedia: wikipedia - Textadept

code source: foicica.com/hg/textadept

début du développement: 2007

langage : C + Lua

utf-8:

Spacemacs

Spacemacs n'est pas un éditeur, mais une (énorme) configuration pour

emacs. Leur baseline "The best editor is neither Emacs nor Vim, it's

Emacs and Vim!" et leur originalité un <leader> configuré sur espace qui ouvre un Menu permettant de découvrir les fonctions disponibles.- code source: github.com/syl20bnr/spacemacs

- début du développement: 2012

Conclusion ?

Pas de conclusion, si vous voulez en découvrir encore d'autre, voici deux listes :

Mais attention de ne pas vous perdre par ici texteditors.org !

-

Lug : Mardi 3 décembre à Grenoble : conférence "Avoir une vie privée sur Internet"

(Dépêches LinuxFR)

La Guilde (Guilde des utilisateurs d'informatique libre du Dauphiné) organise une conférence sur la vie privée sur Internet le mardi 3 décembre 2013 !

La conférence sera animée par Antoine Duparay, contributeur Mozilla, et s'organisera autour des questions suivantes :

Quelles traces laissons-nous en utilisant le Web ? Quelles en sont les implications ? Que pouvons-nous faire pour nous protéger ? Observons le phénomène grâce au greffon LightBeam (ex Collusion) pour Firefox et découvrons les réglages applicables pour se protéger. En ces temps de PRISM et de Cloud Computing, il est temps de réfléchir à la place que nous donnons réellement à nos données.

La conférence se tiendra à l'amphithéâtre E1 de l'ENSIMAG, sur le campus de Saint Martin d'Hères, le mardi 3 décembre 2013 à partir de 19h.

Toutes les informations détaillées sont disponibles sur le site de la Guilde.

- lien n°1 : Site de la guilde

- lien n°2 : Lieux de la rencontre

- lien n°3 : Lightbeam

-

Neatmail: un client mail minimaliste

(Journaux LinuxFR)

Sommaire

- Ali Gholami Rudi

- Ce que Neatmail ne fait pas

- Ce que Neatmail fait

- Le commande ex de neatmail

- Un script shell comme interface

- Conclusion

J’utilise depuis quelque temps un tout petit client mail, qui ne fait vraiment que le minimum, mais a une interface si particulière, qu’il me semble intéressant de vous le présenter. Il s’agit de Neatmail écrit par Ali Gholami Rudi.

Ali Gholami Rudi

Je connais Ali Gholami Rudi pour une implémentation de Troff à la fois pertinente en termes de fonctionnalités et dont le code source est très propre. Il a aussi écrit un compilateur (neatcc), une libc (neatlibc), et une implémentation de vi. C’est un développeur qui, plutôt qu’une éthique, semble défendre une certaine esthétique du logiciel, que je qualifierai de minimaliste: code source compréhensible par une personne seule, logiciel qui fait peu de choses, mais le fait bien, etc.

Neatmail le client mail qu'il s'est programmé, et celui‐ci met en scène toute l’esthétique de son auteur.

Ce que Neatmail ne fait pas

Neatmail ne fait que gérer un fichier mbox (une concaténation de mails). Ainsi, il ne sait ni rapatrier, ni envoyer les mails, il ne sait ni extraire, ni ajouter de pièce jointes, etc.

Mais en vérité, il n’a pas besoin de faire tout cela, car d’autres logiciels le font. Ali Gholami Rudi propose ainsi un pop3 pour rapatrier les mails depuis un serveur pop3, et smtp pour envoyer ses mails à un serveur smtp. Et il existe dans certaines distributions un ripmime pour extraire les pièces jointes d’un fichier mime.

Ce que Neatmail fait

Neatmail se contente donc d’effectuer des actions sur un fichier mbox. Les actions de bases sont:

‐ mk Génère une liste des mails contenus dans la mbox.

‐ ns Génère une liste des nouveaux mails présents dans la mbox.

‐ pg Affiche un des mails contenu dans la mbox.On peut donc l’utiliser ainsi:

# Obtient les mails pop3 # liste les mails, triés par fil de discussion neatmail mk ‐r ‐st ‐0 18from:48~subject: mbox # affiche le 3e mail neatmail pg mbox 3 # prépare une réponse neatmail pg ‐r mbox 3 > draft.eml vi draft.eml # envoie la réponse tail ‐n+2 draft.eml | smtp # garde une copie de la réponse cat draft.eml >> sent rm draft.emlMais en outre, neatmail peut interpréter les commandes ex contenues dans la liste des mails. Autrement dit, l’utilisateur est invité à ajouter des commandes à cette liste de mails, et donner le tout à neatmail qui se chargera de l’exécution:

neatmail mk ‐r ‐0 18from:48~subject > list.nm vi list.nm neatmail ex < list.nmLe commande ex de neatmail

La commande ex de neatmail prend en entrée une liste de commandes, et les exécute sur un fichier mbox. Elle ignore toutes les lignes hormis celles commençant par deux points (commande ex) ou une lettre majuscule (un mail dans la liste). Les lignes commençant par une lettre majuscule de la forme "R100..", modifient le statut du message dont le nombre suit la lettre (ici, 100). Une telle ligne définit aussi le message actuel, celui sur lequel les commandes sont exécutées. Les commandes ex sont les suivantes:

‐ rm supprime le message courant.

‐ cp copie le message courant dans une mbox donnée.

‐ mv déplace le message courant dans une mbox donnée.

‐ hd modifie l’entête donnée du message courant.

‐ ft passe le message courant à une commande donnée.

‐ w écrit les modifications dans la mbox.

‐ tj joint les fils de discussion en modifiant l’entête "Reply‐To".

‐ ch coupe le message à l’offset indiqué.Par défaut, ces commandes agissent sur le message courant, mais il est aussi possible d’utiliser des adresses du type

2,5rmpour effacer les messages 2 à 5. Il est aussi possible d’utiliser des expressions régulières du type/regex/rm, oùregexest recherché dans le sujet des messages. D’autres champs peuvent être spécifiés en utilisant l’expression^field:value.Un script shell comme interface

Vous allez certainement penser que l’interface est un peu rude… À vrai dire, Ali Gholami Rudi n’utilise pas neatmail directement: un script shell (m) lui sert d’interface. Et c’est là que le logiciel brille: pour peu que l’on ait un peu l’habitude du shell, on peut se créer une interface sur mesure. On peut par exemple imiter l’interface de mh (un autre client mail non interactif un peu oublié). On pourrait créer une interface interactive. Bref, on peut faire ce qu’on veut.

J’utilise par exemple l’interface suivante:

m box inbox # liste les messages contenus dans la mbox inbox. m vi 3 # affiche le message 3 m next # affiche le message 4 m repl # ouvre mon éditeur sur une réponse préformatée au message 4 m add f.pdf # joint f.pdf à ma réponse m send # envoie ma réponse. m R # marque le message 4 comme lu. m com # enregistre les changements dans la mbox (ici, change l’entête du message 4)Conclusion

Au jour le jour, je suis plutôt satisfait de l’ensemble. Le fait de travailler sur les mails en local est plutôt agréable: c’est fluide, offre une grande liberté d’organisation, s’associe bien à un système de sauvegarde ou de gestion de version, etc. Le fait que le client ne soit pas interactif apporte un certain confort d’usage: le shell est sous la main si besoin, je retrouve ma session de travail dans l’état où je l’ai laissée d’un jour à l’autre, il est facile d’implémenter des solutions pour revenir en arrière (cp…). Le fait de coupler le tout avec le shell offre une grande liberté dans la création de l’interface utilisateur.

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Tutoriel 3D - 2D découpe au laser, le retour du tux

(Journaux LinuxFR)

Sommaire

- Tranche de pingouin

- Au début était le cube

- Il est gros vot manchot ?

- Et si on l’écartelait ?

- Mais quand est-ce qu’on coupe ?

- Et si on l’empalait ?

- On l’empale plus ?

- Parlons peu, parlons kerf

- C’est la lutte finale

- Le petit oiseau va sortir

- TuxOlaser

- Déboitage du tux et montage

- Tadaaaa

- A propos de licences

- Les fichiers

Tranche de pingouin

Chose promise, cause perdue. Voici comment transformer un modèle 3D en tranches de bois pour découpe laser. Et en bonus, mon essai initial de découpe en création originale.

Les outils que j’ai utilisé sont blender et inkscape, et ce juste parce que je les connaissais et donc plus facile pour expérimenter.Note aux amateurs de freecad, j’ai commencé à regarder comment ça marche, au cas où ce serait plus simple avec, si jamais je trouve une idée et le courage de refaire un tuto, ça me fera un zeugma.

Au début était le cube

Ouvrir un nouveau fichier dans blender et mettre la scène en métrique, car sinon les mesures ne sont pas fixées par taille réelle. Notez que à chaque étape du tuto on aura des soucis de conversion de dimensions, donc en fait… mais bon faut pas en profiter pour être négligent.

Retirer le cube et ajouter le Tux à la scène. Vous pouvez le trouver ainsi que toutes les licences à Tuuuuuuux

- Faire face au tux (1 au pavé num)

- Mettre la vue iso (5 au pavé num)

- sélectionner le tux

- passer en editor mode (tab)

- Sélectionner le dessous des pattes (B) qui est rond

- Niveler (SZ0)

- sélectionner les deux centres des pattes, (S) Snap cursor to selected

- rebasculer en object mode (tab) , transform origine to 3d cursor (object/transform)

Maintenant, le tux est calé pour avoir le plancher des pattes en comme origine, à la verticale du pseudo centre de gravité que nous venons de choisir.

mettre la bête en Z 0.

Il est gros vot manchot ?

Il nous faut choisir une taille, suffisamment grosse pour que ce soit cool, et pas trop gros pour limiter le prix. Comme l’objet c’est aussi tester une bonne quantité d’épaisseurs pour voir comment ajuster la taille théorique d’une planche par rapport à sa taille réelle (il reste du vide, la colle ça épaissit, les planches sont pas forcément pile à la taille).

Une planche 2mm chez sculpteo (chez qui je teste la découpe laser) fait 94cm*59cm, il faut aussi essayer de rester dans une seule planche avec tous les morceaux. Le tux est presque aussi large que haut, du coup on cherche une approximation de cube découpé en tranches et étalé fait la même surface en gardant un peu de marge. ça fait 55 tranches, donc une hauteur de 116.875mm

Et si on l’écartelait ?

Il nous faut séparer les pattes du corps du tux (ce sont des objets distincts dans le modèle de base en fait et elles s’interconnectent :

Il faut les réunir par booléen union au corps pour avoir un seul objet avec un intérieur/extérieur propre.

On peut maintenant appliquer une subdivision sur le tux CTRL+3, parce que le tux aime la douceur, et pas que celle angevine.

Lui sculpter des yeux plus sympa, parce que même si tout le monde ne veut pas l’avouer, pour avoir l’air cool faut quand même avoir un peu l’air con.

Mais quand est-ce qu’on coupe ?

Patience, il faut regarder un peu avant de couper. Placer un plan plus grand que le tux au sol, genre 20cmx20cm et lui appliquer un booléen d’intersection avec le tux. Et regarder en bougeant le plan sur Z comment seront les tranches.

On voit deux endroits à problème, les ailes et la queue qui auront des tranches avec plus que un morceau, ce qui est plus complexe à coller.

par ex les ailes :

Ce sera lourd à coller ensuite, on peut mais pourquoi…

autant relier les ailes au tronc le plus légèrement possible, avec un lien de 1mm de large.

idem au niveau de la queue :

J’ajoute un bloc en union au niveau de la queue, le plus ajusté possible par un booléen union.

Cela vous permettra de facilement coller, il sera toujours possible de le limer après collage.

Il faut bien nettoyer le résultat de l’union à l’intérieur du tux, ne pas laisser de cloisons internes, c’est à dire éviter d’avoir des plan à l’intérieur des plans :

Finir de nettoyer en retirant les doublons de vertices, boucher les trous, assurer les normales pour que ce soit clair ce qui est à l’intérieur et à l’extérieur.

Et si on l’empalait ?

Pensons au support central qui va nous permettre de facilement positionner et coller les tranches de tux, il va être en trapèze et ressembler à ça au niveau d’une tranche :

Le choix de la découpe sera donc toujours du côté le plus grand, en bas. Donc notre référence pour le positionnement des plans de découpe doit être la face basse de chaque tranche.

Replaçons le plan à 0.01mm en Z (pour éviter le chevauchement parfait des surface avec les pattes Z=0), pensez à remettre tous les éléments avec scale=1 (Ctrl+A scale and rotation) pour la suite.

Faire une array de 50 plans en Z espacés de 2.125mm, faire le booléen intersection avec le tux. Lors de la réalisation de mon bureau réel avec des tux, j’ai constaté que l’empilage de x tranches de 2mm n’a pas un résultat de x*2mm, mais avec l’air restant et la colle environ 2.125. Je vais affiner avec ce tux cette estimation mais déjà on part de 2.125mm par tranche.

On voit les tranches et on voit des petits problèmes

Une tranche qui manque en haut et le cul qui a une mini tranche en bas.

Diminuer le overlap thresold du booléen pour que le problème du haut disparaisse :

Remonter le point du bas du tux pour supprimer le second problème et non, ce n'est pas lui mettre un doigt dans le cul car ça ne doit pas rentrer :

Nickel !

Simulons une épaisseur des tranches pour avoir un aperçu du résultat réel, ajoutons au plan un modifier solidify 2mm avec l’offfet à +1 (vers le haut) pour suivre le plan d’avoir la face basse comme référence :

Le résultat est conforme, retirez le solidify, il ne doit pas interférer avec l’étape de création du lien central.

On l’empale plus ?

Mais si, mais si. En fait ce n’est pas obligatoire, mais ça facilite le positionnement des étages, et on peut aussi le garde sans le coller. Le lien central doit avoir une forme de trapèze et être parfaitement vertical, car pour l’instant sculpteo ne fait pas de découpe oblique.

Il doit faire une épaisseur égale à celle du bois. Pour mon exemple je suis resté sur mon approximation (2.125mm) mais normalement il faut prendre 2mm et ajuster avec l’épaisseur du kerf qui est la taille du laser laissant un vide de découpe autour du trait de coupe. En pratique lors de mon premier essai j’ai eu des soucis d’épaisseur et j’ai du poncer mon trapèze. Du coup comme ce n’est pas nécessaire d’ajuster. Je surestime cette fois-ci la taille du trapèze.

Il faut ajuster sa position pour qu’il traverse tout le tux, coup de chance c’est possible sur ce modèle en plaçant la traverse au centre de la dernière tranche du tux. Mais sinon on l’aurait simplement fait avec deux trapèzes sur deux hauteurs.

Ajustez la taille en X et la hauteur de la partie haute pour faire joli, elle va dépasser un peu et même arrondir sa tête (note postérieure en pratique le trapèze sera toujours trop court, il faut juger les tranches encore un peu plus grand que 2.125mm).

En dessous ajuster aussi la taille en X pour donner un beau trapèze

On voit que c’est moche au niveau du pied

On va donc remodeler un peu le trapèze pour qu’il soit plus joli à cet endroit.

Parlons peu, parlons kerf

Le kerf c’est la partie du bois éliminée par le laser, en pratique la découpe est plus petite que le plan car le laser à une taille non ponctuelle. la découpe de la traverse dans les tranches sera donc un peu plus grande que prévu, et la traverse découpée plus court aussi que prévu.

Dans ce modèle, on peut ignorer le kerf et accepter les différences, elles seront minimes et les pièces collées seront bien ajustées.

appliquons donc le booléen différence entre le plan des tranches et la traverse

Le résultat est difficile à voir mais en vue fil de fer c’est visible

C’est la lutte finale

On peut passer à la phase finale, on réalise les “modifier” sur les planches, puis on aplati le trapèze en retirant les vertices d’un côté.

En mode éditeur, on sépare toutes les tranches (P+loose parts en mode édition) et on les étale dans le bon ordre en vue du dessus. Attention, les numéros générés lors de la réalisation de l’array ne sont pas forcément dans l’ordre de Z…

Pour ne pas me planter, je me met dans une vue adaptée et je bouge une par une les tranches avec des gx0.1 … Je vérifie bien que tout est dans l’ordre puis je met tout le monde à plat (sélectionner tout A puis SZ0)Nous allons avoir des soucis de conversion de taille entre blender puis Inkscape puis sculpteo… on commence par poser un étalon dans blender, un plan au sol de 1cm sur 90cm

Le petit oiseau va sortir

Enfin presque, il faut encore à faire la photo !

Il existe une option de rendering qui génère du svg.

Mettons la caméra au dessus en mode orthographique, d’abord une résolution 100% sur un ratio approximatif de mon rectangle incluant tout.

puis placer la caméra assez bien au dessus de la scène et changez les paramètres :

L’échelle orthographique est ce qui correspond au zoom, ajustez la valeur pour que tout rentre au plus juste

Tout doit rentrer dans la fenêtre de rendering :

Maintenant depuis les user pref, activez le svg freestyle exporter :

Et activez les deux options freestyle et svg export depuis les options rendering

Pressez F12, une image svg sera générée dans le répertoire indiqué dans output nommé 0001.svg,Ouvrez le dans Inkscape, dégroupez et sélectionnez l’étalon. mettez lui une épaisseur de contour à 0 pour ne pas fausser la taille et regardez sa taille. Dans mon cas je tombe sur 35.719cm.

Je vais donc changer la résolution de l’image pour ajuster la taille d’un facteur de 90/35.719=2.52

Je change dans blender le render pour :

Re F12 et vérification.

Mon étalon fait maintenant 1cm sur 90.01cm.

aller, on essaie avec un pixel de moins en Y :), on tombe sur 89.987. C’est moins bon, retour en arrière.Maintenant que l’on a les bonnes tailles dans Inkscape, il faut nettoyer. Parce que le freestyle a introduit des pixels de temps en temps.

Je prends donc chaque découpe pour la repositionner au mieux et aussi supprimer les traces.

Pour m’aider et aussi servir d’étalon entre Inkscape et sculpteo je place un cadre dans une autre couleur qui délimite ma sélection, 53.5cm de large sur 75cm de haut.

Et je fais tout rentrer dedans.

Je vérifie chaque pièce pour assurer qu’il n’y a pas de défaut, et j’assure les contours à 1px et mon cadre avec une couleur différente

C’est prêt.

Pour ceux qui sont plus observateurs que moi, vous verrez que j’ai oublié de grouper une fente dans une tranche. Moi je vais le voir au montage plus tard…TuxOlaser

J’upload chez sculpteo.

Deux couleurs sont détectées, l"une correspond au noir et l’autre au rouge du cadre. Les mesures n’ont pas été conservées, je ne sais pas pourquoi… mais mon cadre me permet de choisir un ajustement de taille à 26.5% qui me redonne les bonnes dimensions.Je peux alors désactiver le cadre rouge dans sculpteo (style 2 sur aucun et voila !

prêt à couper.Livraison comprise il vous en coûtera 53.33€.

Pour info, les tux du bureau ont coûté moins cher, ils étaient en une seule livraison et un peu plus petits, 72€ les 3.Déboitage du tux et montage

Je hais les video de unboxing, et me voilà moi même à déboiter…

Bon, puisqu’il faut :

la boite est bien protégée

et la planche dans la mousse

Les pièces sont tenues par du scotch, il faudra faire attention en retirant le scotch de ne pas casser les pièces fragiles.

Je numérote mes pièces avant de défaire, c’est moins cher que de faire des numéros au laser.

Ensuite on empile jusqu’à la fameuse pièce 33 qu’il faudra redécouper.

Tadaaaa

A propos de licences

J’ai fouillé pour trouver les licences attachées au modèle de base, les voici :

https://opengameart.org/content/tux

https://opengameart.org/sites/default/files/license_images/gpl.png

http://www.gnu.org/licenses/gpl-3.0.html

https://opengameart.org/sites/default/files/license_images/cc-by.png

http://creativecommons.org/licenses/by/3.0/Les fichiers

Voila les fichiers sources blender et le inkscape (piece 33 corrigée)

fichier blender

fichier svgCommentaires : voir le flux atom ouvrir dans le navigateur

-

Dogmazic a besoin de vous !

(Dépêches LinuxFR)

Bonjour à tous,

L'Association Musique Libre qui porte le site Dogmazic.net change de projet. Le développement de la version 3 du site est trop coûteux en temps, en énergies, et en finances. L'association a donc décidé de recentrer ses activités vers du concret. Fini l'attente d'une hypothétique version 3 du site (le développement est toujours disponible sous licence libre et maintenu par son développeur sur github ). Nous avons décidé de nous recentrer autour de nos actions principales : les nouvelles informations autour de la musique libre, le forum, la documentation et notre archive 2004-2012.

Pour cela, nous avons besoin de migrer vers un nouvel hébergeur nous correspondant mieux : Aquilenet. Malheureusement, nous avons beau être des musiciens, être sous diverses distributions Linux, et militants en faveur du libre depuis pas mal d'années, nous ne savons pas - encore - effectuer une migration de base de données et de sites complets.

C'est pourquoi nous sollicitons vos bonnes volontés afin de nous y aider.

Nous vous donnons rendez-vous sur notre chan IRC : irc.freenode.net #dogmazic (ou http://musique-libre.org:7778 )

Merci !

Aisyk pour l'Association Musique Libre !- lien n°1 : Musique Libre

-

Zet Uw Volgende Sigaret Into Your Last Met Deze Stoppen Met Roken Tips

(Laboratoire Linux SUPINFO)

e liquid ingredients. Als je een roker bent , is de kans groot dat u wilt stoppen en gewoon niet weten hoe dit te doen . Wees niet ontmoedigd , omdat de informatie en technieken die in dit artikel zijn bedoeld om mensen zoals jij te helpen . Gebruik de tips in dit artikel om u te helpen langs de weg om een niet-roker

Om uw kansen op succesvol stoppen met roken te stimuleren , denken zetten op papier alle potentiële voordelen en gevolgen van stoppen . Aanbrengen van de kwestie schriftelijk zal u helpen om het beter te kunnen zien . Dit kan u helpen gemotiveerd te blijven , en kunnen stoppen gemakkelijker te maken .

Om uw kansen op succesvol stoppen met roken te stimuleren , denken zetten op papier alle potentiële voordelen en gevolgen van stoppen . Aanbrengen van de kwestie schriftelijk zal u helpen om het beter te kunnen zien . Dit kan u helpen gemotiveerd te blijven , en kunnen stoppen gemakkelijker te maken .Als u rookt als een manier om stress te beheersen , wil je andere stress saneringstechnieken klaar hebben wanneer je besluit om te stoppen . Blijf uit situaties die je kan stress voor de eerste paar weken nadat je hebt gestopt . U kunt ook uw stress te beheren door middel van yoga , meditatie of door het krijgen van een massage .

Vergeet niet dat uw houding is alles. Wanneer u begint te voelen beneden , moet je proberen om jezelf er trots op dat je stoppen te maken. Roken is slecht voor je en elke keer dat je de drang om te roken te veroveren , moet je trots voelt als u het nemen van belangrijke stappen in de richting van een gezonder je .

Maak een studie van wat triggers uw roken en zoek manieren om je triggers te vermijden. Bijvoorbeeld zaken als roken tijdens het rijden of het lezen , zodat je niet automatisch denken over je rookgedrag te veranderen . Je nodig hebt om een afleiding te vinden, om na te denken over iets anders.

-

Dr. Geo 18.06

(Dépêches LinuxFR)

GNU Dr. Geo est un logiciel de géométrie interactive euclidienne du plan, pour une utilisation à l'école secondaire et primaire. Il permet d'organiser des activités pédagogiques dans l'enseignement de la géométrie, voire d'autres domaines liés des mathématiques.

Intégré à un environnement dynamique de programmation Smalltalk, il propose également une approche de la géométrie dynamique par la programmation, soit par l'utilisation de script(s) intégré(s) à une figure, soit par une description purement programmatique d'une construction géométrique. En outre, Dr. Geo est toujours modifiable depuis lui-même, fonctionnalité héritée de son environnement de développement.

La version 18.06 fait suite à la version 17.07 sortie en juillet 2017. Une grande partie de l'effort fut de porter le code de la version 3 à la version 7 de l'environnement Smalltalk Pharo avec lequel est développé Dr. Geo. Outre les corrections de bugs inhérentes à ce portage, quelques fonctionnalités nouvelles ont fait leur apparition.

- lien n°1 : GNU Dr. Geo

- lien n°2 : Article Wikipedia

Nouvelles fonctionalités

Navigateur de code dédié

Dans Dr. Geo, un script est défini par une classe Pharo. L'utilisateur insère alors une instance du script dans la figure géométrique ; il lui associe si nécessaire d'autres objets géométriques de la figure en paramètres. Un script effectue un traitement ad-hoc, calculs ou modifications sur d'autres objets de la figure tels que programmés dans les méthodes du script. Une fois défini, le script est facile à utiliser.

L'édition de script se fait maintenant à l'aide d'un outil d'édition de code dédié, et non plus par l'intermédiaire du navigateur de code de Pharo, qui est pour le moins impressionnant.

À noter que l'ajout d'attribut au script nécessite toujours l'utilisation du navigateur de code de Pharo. Ce besoin est nécessaire uniquement lorsque le script a un état dont il doit se souvenir tout au long du cycle de vie de la figure.

Le manuel utilisateur a une section dédiée au script.

Inspecteur sur code de figures programmées

Une figure programmée est l'autre forme d'utilisation de la programmation dans la géométrie dynamique. Dans cette approche la figure géométrique est entièrement définie par un code Smalltalk et l'utilisation de l'API dédiée.

Il est dorénavant plus aisé de gérer ses fichiers de figures programmées. Le nouvel inspecteur de Pharo — outre l'inspection d'attributs d'instance de classe — propose aussi de voir, d'exécuter, d'éditer et de créer les scripts de figures programmées.

Zoom positionnel

Pour zoomer dans une figure l'utilisateur dispose du widget de molette orange en haut à droite de chaque figure ou de la molette de la souris. Le zoom par la souris est maintenant positionnel, focalisé sur la position du curseur souris ; celui par le widget reste, lui, centré au milieu de la zone visible de la figure.

Détection de polygone sans surface

Lorsqu'un polygone est sans surface (vide), Dr. Geo ne détectera que ses lignes, et non plus sa surface intérieure puisqu'elle n'existe pas.

Tests unitaires basés sur figures programmées

Le petit corpus de figures programmées distribué avec Dr. Geo est également utilisé pour définir une série supplémentaire de tests unitaires.

Partage réseau

Dans le cadre d'une activité pédagogique en salle informatique, distribuer aux élèves des fichiers de figures est pratique. Dr. Geo propose maintenant une fonctionnalité de partage en réseau local, indépendante des services du réseau local (NFS, Samba, Windows, etc.). La marche à suivre est la suivante :

- L'enseignant sauve les documents à partager dans son dossier DrGeo.app/MyShares :

- L'enseignant active le partage réseau local depuis le navigateur de préférences de DrGeo (menu Système, Préférences) :

- L'élève, depuis l'outil habituel d'ouverture de figures, parcourt les figures partagées (bouton 'Partage enseignant') :

Cette fonctionnalité peut s'utiliser de façon croisée avec Linux, Mac et Windows.

Thèmes graphiques

Le navigateur de préférences (menu Système, Préférences) donne accès à deux thèmes graphiques, hérités de Pharo :

Thème sombre, par défaut, à privilégier lorsque Dr. Geo est utilisé de façon autonome sur un seul poste.

Thème clair, à utiliser en vidéo projection, par exemple, car le thème sombre manque de contraste.

Option plein écran

Depuis le menu système, l'utilisateur peut basculer en affichage plein écran ; le système hôte est alors complètement masqué. Pratique pour que les élèves se concentrent sur leur activité de géométrie dynamique.

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Pourquoi Jabber n'a pas plus de succès, même chez les informaticiens?

(Journaux LinuxFR)

Bonjour nal.

Aujourd'hui me suis demandé pourquoi Jabber n'a pas le succès qu'il mérite, même chez les informaticiens.

Il a pourtant de nombreux atouts:

- Simple d'utilisation

- Léger

- Fédéré

- Basé sur le protocole XMPP: un standard ouvert et bien documenté

- Format d'adresse similaire à l'e-mail

- Tout le monde peut fournir une adresse Jabber

- Comptes et/ou clients remplaçable sans perdre ses contacts

- Possibilité de créer un compte depuis le client (si le serveur choisi l'accepte)

- Supporté par des clients variés, adaptés à différents usages

- Supporte la connexion de multiples clients à un même compte

- En cas de multiples connections, on peut gérer leurs priorités

- Possibilité de recevoir une copie des messages reçus et envoyés sur tous ses clients connectés (cabron)

- Historique stocké coté serveur et synchronisé entre les clients (MAM)

- Discussions de groupe avec modérateurs et adresses cachées aux autres participants

- Statut personnel accompagné d'un message

- Statut des messages (envoyé, reçu et lu)

- Envoi de sa position géographique à un contact.

- Annuaire

- Partage de fichier simple (http-upload)

- Possibilité d'empaqueter la connexion dans de l'http (Bosh), pratique quand on est connecté depuis un réseau wifi pourri.

- Conversation audio et vidéo

- Signature et chiffrement de ses messages avec GPG et OTR

- Signature de son status avec GPG

- Possibilité pour le client de communiquer avec les bots, sans que l'utilisateur n'ai à taper de commandes

- Passerelles vers d'autres services de chat (IRC, Telegram, etc)

- Possibilité de découvrir, accéder et interagir avec les services proposés par le serveur et les contactes (bot ou pas)

Coté client libre, il y a du choix:

- Movim: Un client moderne, en version desktop, smartphone et web. Très complet, il propose même un système de "forums" via ce qu'il appelle les "communautés", un système d'actualités avec la possibilité de rédiger ses propres articles, le support de la syntaxe markdown. Les articles qu'on écrit sont même visiblex avec un simple navigateur web, pas besoin de compte Jabber.

- Conversations: Un client léger, pour Android, qui se concentre sur les communications texte. Points négatifs: Il est payant sur le Google Store et la gestion des statuts est cachées sans raison.

- Jitsi: Un client qui se concentre sur la vidéo-conférence, en version desktop, smartphone et web. Plutôt destiné à un usage pro.

- Gajim: Le vénérable client desktop. Très complet, mais son interface date un peu.

- D'autres que j'oublie.

Pour le développeur de bot et l'admin système il y a aussi des points forts:

- Jabber utilise le protocole XMPP: Du XML échangé par un socket TCP.

- XMPP est standard, ouvert et bien documenté

- De nombreuses bibliothèques implémentent ce protocole, certaines étant même tournées vers la création de bots

- Les bases du protocoles existent depuis assez longtemps pour avoir été éprouvées

- Le protocole est extensible, on peut le faire évoluer suivant les besoins

- Prosody fourni un serveur très simple et modulaire. Rapide à déployer. Idéal pour une association, une PME ou un usage personnel. Écrit en lua, c'est un très bon choix si on a besoin de faire du dév coté serveur.

- Ejabberd est quand à lui un serveur conçu pour les grosses infrastructures.

- Possibilité d'envoyer un message de bienvenu aux utilisateurs et de les prévenir en cas de maintenance de serveur.

Jabber est l'idéal pour une association libriste ou un hackerspace:

- Serveur facile à déployer, demande peut de travail pour être maintenu

- L'annuaire permet de retrouver rapidement un autre membre. On peut également pré-remplir la liste des contactes avec les autres utilisateurs du serveur.

- On peut héberger son propre serveur de salons de discussion sur son propre domaine.

- On profite de tous les avantages listés plus haut.

Je peux comprendre qu'il soit très difficile d'avoir du succès auprès du grand public en matière de service de messagerie instantanée. Mais pourquoi Jabber, avec tout ses avantages, n'est-il pas plus utilisé par les informaticiens ou au moins les libristes et les hackers? Pourquoi une solution moins libre comme Telegram, malgré tous ses points

négatifs, a-t-elle plus de succès? -

France Culture: que reste-t-il du logiciel libre ?

(Journaux LinuxFR)

Bon jour Nal !

L'émission Du grain à moudre d'hier, sur France Culture, posait cette question: « Que reste-t-il du logiciel libre ». Des représentants de Framasoft et de Microsoft tentaient de répondre à la question. On peut écouter l'émission en podcast.

J'écoutais vaguement en faisant la cuisine… J'en ai néanmoins déduit une conclusion:

- Le modèle économique du logiciel libre, qui consiste à vendre un service plutôt que le logiciel l'a emporté. C'est du moins le modèle économique que le représentant de Microsoft considère dorénavant le plus viable.

- Le logiciel libre, entendu comme 4 libertés, prospère dans les piles logicielles éloignées de l'utilisateur final, mais peine à s'imposer dans les logiciels plus proches de l'utilisateur final.

- L'éthique que certains (dont moi) associent au logiciel libre, de maîtrise de son outil de travail ou de ses données perd du terrain. Non seulement parce que le modèle du service (dans les nuages) s'est imposé, mais aussi parce que d'une manière générale, plus l'on s'approche de l'utilisateur final, moins on trouve de logiciel libre.

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Surface d'attaque des serveurs dans les nuages (cloud)

(Journaux LinuxFR)

Passionnant et très utile article sur le blog en anglais de James Bottomley (merci LWN.net pour le résumé) : il étudie la sécurité des solutions d'hébergement Cloud en se basant sur la solution retenue : serveurs dédiés, serveurs partagés, serveurs virtuels, conteneurs, et en comparant les profils d'attaques verticales et horizontales.

Comme vous aimez les conclusions rapides, sachez déjà que la solution conteneurs l'emporte haut la main.

Une attaque verticale c'est du code traversé : de la requête web à la base de donnée jusqu'à la réponse dans le navigateur ou l'application, et qui contient potentiellement des bugs, elle concerne uniquement votre hébergement :

all code that is traversed to provide a service all the way from input web request to database update to output response potentially contains bugs; the bug density is variable for the different components but the more code you traverse the higher your chance of exposure to exploitable vulnerabilities. We’ll call this the Vertical Attack Profile (VAP) of the stack.

Une attaque horizontale par contre peut se propager d'hébergement en hébergement :

In an IaaS cloud, part of the vertical profile belongs to the tenant (The guest kernel, guest OS and application) and part (the hypervisor and host OS) belong to the CSP. However, the CSP vertical has the additional problem that any exploit in this piece of the stack can be used to jump into either the host itself or any of the other tenant virtual machines running on the host. We’ll call this exploit causing a failure of containment the Horizontal Attack Profile (HAP).

La surveillance est répartie différemment selon l'hébergement, par exemble sur un serveur partagé l'hébergeur doit surveiller toute la pile : le matériel, le noyau, les librairies et le middleware, vous n'êtes responsable que de la couche applicative, tandis qu'avec un conteneur il surveille le matériel et le noyau hôte.

Mais les attaques sont aussi réparties différemment. Dans un hébergement partagé, si vous attaquez le noyau vous pouvez compromettre tout le système, donc tous les hébergements tandis qu'il est plus difficile de sortir d'un conteneur.

Compte tenu de quelques autres facteurs que je ne résume pas ici — veuillez lire cet article avant de commenter —, les équipes de sécurité de l'hébergeur bossent « mieux » avec des conteneurs, qui sont donc plus fiables, quoi qu'en dise votre contrat. Mais que ça ne vous dispense pas des opérations habituelles de base : backup, backup ET backup (sauvegarde, sauvegarde ET sauvegarde de leurs petits noms).

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Sortie de Sailfish OS 2.2.0

(Journaux LinuxFR)

Bien que n'étant pas propriétaire d'un téléphone fonctionnant avec Sailfish OS, je regarde régulièrement les avancées de ce système alternatif à Android et iOS.

Bonne nouvelle, j'ai découvert ce matin qu'une mise a jour a été publiée le 7 juin : la version 2.2.0

Celle-ci supporte (enfin) la version double SIM du Sony Xperia X (F5122) en plus la version simple SIM (F5121) qui était un prérequis pour moi pour ne pas avoir deux téléphones dans la poche. Le communiqué met en avant d'autres fonctions qui sont maintenant apportées comme le déverrouillage par empreinte, un meilleur autofocus de l'appareil photo et une refonte de l'application de galerie.

La note de publication détaille davantage les nouveautés et les anomalies identifiées, avec toujours quelques difficultés sur des équipements Bluetooth.

Est-ce que des lecteurs ont un téléphone qui fonctionne avec Sailfish pour obtenir leur avis et retour d'expérience ? J'utilise le téléphone de façon très basique (téléphone, mail, internet et GPS) pour le travail et un usage perso. Le partage de connexion internet avec le PC est néanmoins indispensable ! Éventuellement quelques mini jeux pour passer le temps mais c'est assez exceptionnel.

Merci

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Revue de presse de l'April pour la semaine 27 de l'année 2016

(Dépêches LinuxFR)

La revue de presse de l'April est régulièrement éditée par les membres de l'association. Elle couvre l'actualité de la presse en ligne, liée au logiciel libre. Il s'agit donc d'une sélection d'articles de presse et non de prises de position de l'association de promotion et de défense du logiciel libre.

Sommaire

- [Journal du Net] Contribuer à l’open source, un levier de croissance et de dynamisme pour l’entreprise

- [L'OBS] Chic, le gouvernement choisit le logiciel libre. Zut, c’est en Bulgarie

- [France Info] Un Wikipédia mondial du logiciel

- [Next INpact] Loi Numérique: pas de recours «prioritaire» aux logiciels libres pour l'administration

- lien n°1 : April

- lien n°2 : Revue de presse de l'April

- lien n°3 : Revue de presse de la semaine précédente

- lien n°4 : Podcast

[Journal du Net] Contribuer à l’open source, un levier de croissance et de dynamisme pour l’entreprise

Par Arnaud Breton, le jeudi 7 juillet 2016. Extrait:

La production en open source est extrêmement riche et présente de nombreux avantages pour les entreprises dès lors qu’elles souhaitent s’y investir de manière concrète et durable.

Lien vers l'article original: http://www.journaldunet.com/solutions/expert/64809/contribuer-a-l-open-source--un-levier-de-croissance-et-de-dynamisme-pour-l-entreprise.shtml

[L'OBS] Chic, le gouvernement choisit le logiciel libre. Zut, c’est en Bulgarie

Par Thierry Noisette, le mercredi 6 juillet 2016. Extrait:

Apprendre que le gouvernement choisit, pour tout développement logiciel sur mesure qu’il commandera, de privilégier les logiciels sous licences open source, voilà qui réjouit les partisans des logiciels libres et de leurs avantages (partage, économie, souveraineté…).

Lien vers l'article original: http://rue89.nouvelobs.com/2016/07/06/chic-gouvernement-choisit-logiciel-libre-zut-cest-bulgarie-264570

Et aussi:

[France Info] Un Wikipédia mondial du logiciel

Par Jérôme Colombain, le mercredi 6 juillet 2016. Extrait:

Les logiciels constituent aujourd’hui une part importante de notre savoir collectif mais ils peuvent se perdre. Pour éviter cela, des Français ont décidé de créer une sorte de bibliothèque mondiale du logiciel.

Lien vers l'article original: http://www.franceinfo.fr/emission/nouveau-monde/2015-2016/un-wikipedia-du-logiciel-06-07-2016-07-00

[Next INpact] Loi Numérique: pas de recours «prioritaire» aux logiciels libres pour l'administration

Par Xavier Berne, le lundi 4 juillet 2016. Extrait:

En dépit des avis émis par les participants à la consultation sur l'avant-projet de loi Numérique, le législateur n’a pas souhaité imposer aux administrations de recourir «en priorité» aux logiciels libres. Les fonctionnaires devront simplement s’en tenir à un vague «encouragement».

Lien vers l'article original: http://www.nextinpact.com/news/100503-loi-numerique-pas-recours-prioritaire-aux-logiciels-libres-pour-l-administration.htm

Voir aussi:

-

Montrez vos bobines

(Dépêches LinuxFR)

Même pour un circuit numérique, il y a une dose d’électronique d’analogique. « Malheureusement », penseront certain. Voyons les bobines, selves ou inductances.

Une bobine est un dipôle, qui n’a pas de sens de branchement. Sa grandeur principale se mesure en henry (H), dont le nom est hérité du physicien américain Joseph Henry. Elle va de quelques picohenry (pH), à quelques henry (H). La petite équation est

U = L × ∂i/∂t.- lien n°1 : Journal précédent sur les résistances

- lien n°2 : Jounal précédent sur les condensateurs

- lien n°3 : Dépêche précédente sur les diodes

Pour se rappeler de l’équation, il suffit de se souvenir que des personnes se sont amusées à brancher des bobines sur le secteur, par exemple, un transformateur 5 V mis à l’envers (un transformateur est composé de deux bobines ou plus, qui partagent leur champ magnétique). Ils sont morts en débranchant le système, ce qui provoque un énorme arc électrique. En effet, le courant passe d’une valeur fixe à zéro en une fraction de seconde, la dérivée du courant est très grande, ce qui produit une très grande tension qui fait « claquer » l’air, c’est‐à‐dire que, comme pour un éclair, l’air devient conducteur (à partir de 3,6 kV/mm sous air sec, moins avec de l’humidité ambiante).

On peut remarquer que si un condensateur « intègre », une bobine « dérive » le courant. Il y a une dualité entre les deux composants.

Les bobines sont composées d’enroulement d’un fil, autour d’un cœur. La valeur d’inductance dépend du nombre de spires (de tours de fils) et de la matière du cœur.

L’enroulement est fait en fils de cuivre, moins résistant électriquement que l’aluminium. Si le fil est fin et avec beaucoup de spires, la résistance série parasite n’est plus négligeable.

Le matériau magnétique permet d’augmenter L, l’inductance, sans augmenter le nombre de spires, par rapport à une bobine « à air ». Mais au contraire de l’air, ces matériaux « saturent ». Arrivé à un certain niveau de courant électrique, la valeur L s’écroule, et la bobine se comporte comme une simple résistance. Les bobines à air ne saturent pas, mais sont bien plus grandes, pour avoir la même valeur d’inductance et, évidemment, la résistance série parasite augmente avec la taille de la bobine.

Pour certains circuits de précision, il peut être utile d’utiliser une grosse bobine à air pour pouvoir comparer le résultat avec la bobine définitive plus petite.

Il existe deux formes physiques : le plot ou le tore. Le plot peut être plus facile à placer sur un circuit imprimé, mais il rayonne plus (produit plus de parasites) qu’un tore.

Seule

La self, comme on dit en anglais, de choc ou d’arrêt est un moyen de filtrage de parasites. Un moteur génère toujours des tensions parasites plus ou moins fortes. Même si les alimentations sont séparées, la masse est commune. Or les parasites peuvent aussi passer par là. Mettre une bobine de choc, pour relier les masses évitent d’avoir des réinitialisations intempestives d’un microcontrôleur, par exemple (vécu).La plus petite en dessous vaut environ 1 € et supporte jusqu’à un courant de 1 A :

Deux bobines dites « de chocs », utilisées comme anti‐parasites. (CC-BY 2.0 — auteur : Oskay)Sur certains câbles, comme les câbles USB, on peut voir un gros bloc plastique, qui a une fonction similaire.

Réservoir d’énergie

Le principe de certaines alimentations à découpage est de générer un signal carré, dont la valeur moyenne est la tension recherchée. Ce genre d’alimentation utilise le fait que les transistors MOS ne consomment presque pas d’énergie, quand ils sont passants ou saturés.Ensuite, il faut filtrer la sortie pour ne récupérer que cette moyenne, ou la « très basse fréquence », qui est la tension recherchée. Si l’on filtre avec un classique filtre RC, une grosse partie de l’énergie partira en chaleur dans la résistance. Un filtre LC filtre sans dissiper l’énergie (hors résistance série parasite). Les deux éléments L et C stockent l’énergie à des moments différents.

Il est question d’éléments de puissance, les fils de la bobine doivent être assez gros pour limiter les pertes ohmiques.

Bobine torique utilisée comme réserve d’énergie. (CC-BY 2.0 — auteur : Oskay)Sur l’image, le fil est doublé pour diminuer la résistance.

J’ai peu utilisé les bobines, en dehors des bobines de choc et d’une alimentation à découpage. C’est le seul composant qui peut se faire à la main, pour avoir le meilleur résultat. Il peut être compliqué de trouver des bons cœurs magnétiques, ou de trouver le câble de 2 mm, protégé par un vernis, typique des applications dans le domaine de puissance qui intéresse un hobbyiste (1 à 100 W). Mais il est plaisant d’avoir sa propre alimentation, à une tension peu commune, pour fournir 6 V sous 20 A pour des servomoteurs branchés sur une batterie 12 V, par exemple.

En conclusion, il faut se rappeler qu’il existe plusieurs sortes de bobines qui peuvent supporter un courant maximum, avant de se transformer en résistance.

Vous pouvez reprendre une activité normale (comme regarder les réseaux sociaux).

-

Lazy FPU state restore

(Dépêches LinuxFR)

Intel est de nouveau confronté à la découverte d'une faille, le

Lazy FPU State Restore flaw.

Cette fois, seule la famille des intel core serait concernée.- lien n°1 : Explication des inventeurs

- lien n°2 : La mécanique Lazy FPU state restore expliquée par les équipes NetBSD

- lien n°3 : Le message de Linus lors du passage en mode eager

Sommaire

Le FPU

L'unité de calculs flottants, le FPU, possède une série de registres qui lui permet de définir son état courant.

Lors du basculement d'une tâche à une autre ( context switch), cet état est alors restauré pour retrouver un contexte correspondant au processus en cours.Ces opérations peuvent être coûteuses car les registres sont plus gros que ceux du CPU, c'est pourquoi les FPU fournissent une option pour désactiver toute opération flottante (

CR0:TS) ; aussi, dès qu'un calcul flottant est appelé une exception est lancée pour réveiller le FPU avant de lancer l'opération normalement.

Lorsque cette exception (fpudna, FPU Device Not Available) se produit, un gestionnaire de contexte fpu vérifie quel processus a la main sur le FPU à ce moment-là.

S'il s'agit d'un autre processus, il procède à la sauvegarde puis restauration des registres, ou s'il s'agit d'un nouveau contexte, la sauvegarde puis nettoyage des registres ; sinon, il ne fait rien : c'est le mode «paresseux» (lazy). À la sortie du processus, il ne faut pas oublier de nettoyer ces tables et de (re)lever tous les drapeaux liés à cette exception.En mode

eager(zélé, volontaire), la sauvegarde/restauration des registres associés au FPU est effectuée quoiqu'il advienne, au moment du changement de tâche et non durant l'exécution de la tache qui vient de prendre la main.Le bâton

Au fil des années, les processeurs ont multiplié les registres pour prendre en charge les instructions de type SIMD, soit une instruction capable de procéder au même calcul sur un ensemble de paires de données.

Les registres

SSE,AVXetMMXrestent associés au FPU et seront donc intégrés au mécanisme de sauvegarde/restauration…

… et ils peuvent contenir jusqu'à 2Kb de données, rien que sur l'AVX.[ 0.000000] Linux version 4.14.48-intel-pk-standard (oe-user@oe-host) (icc version 18.0.2 (gcc version 7.3.0 compatibility)) #2 SMP PREEMPT Wed Jun 20 13:21:48 UTC 2018 [ 0.000000] x86/fpu: Supporting XSAVE feature 0x001: 'x87 floating point registers' [ 0.000000] x86/fpu: Supporting XSAVE feature 0x002: 'SSE registers' [ 0.000000] x86/fpu: Supporting XSAVE feature 0x008: 'MPX bounds registers' [ 0.000000] x86/fpu: Supporting XSAVE feature 0x010: 'MPX CSR' [ 0.000000] x86/fpu: xstate_offset[3]: 576, xstate_sizes[3]: 64 [ 0.000000] x86/fpu: xstate_offset[4]: 640, xstate_sizes[4]: 64 [ 0.000000] x86/fpu: Enabled xstate features 0x1b, context size is 704 bytes, using 'compacted' format.Pour se faire battre

Par le biais désormais connu de l’exécution spéculative puis de l'analyse de cache, un attaquant pourra lire ces registres depuis un autre processus, voire, depuis une machine virtuelle. En effet, en mode

lazyla sauvegarde des registres d'une tâche s'effectue au cours de l'exécution d'une autre tâche. La spéculation ignorant le drapeauCR0:TS, tout est alors possible.Ces registres peuvent contenir des informations sensibles comme des clefs de chiffrement (AES), par le biais des instructions d'accélération matérielle AES-NI.

Delivers Fast, Affordable Data Protection and Security. AHeum.

Colin Percival, ex membre de l'équipe sécurité de FreeBSD, a codé un exploit en quelques heures et note, dans un tweet :

You need to be able to execute code on the same CPU as the target process in order to steal cryptographic keys this way. You also need to perform a specific sequence of operations before the CPU pipeline completes, so there’s a narrow window for execution

Vous devez être en mesure d'exécuter le code [de l'exploit] sur le même CPU que celui de la cible pour voler les clefs de cette manière. Vous devrez en outre appliquer une suite précise d'opérations avant que la chaîne de traitement du CPU ne se termine ; de fait, la fenêtre de tir est très étroite.

Ce qui semble vouloir dire que, pour l'instant, coder le vol de données depuis un script venu du Web n'est pas simple à produire. Le temps nécessaire au vol des données des registres est la clef de l'attaque. Il faut le terminer avant que le séquenceur ne préempte la victime et que les valeurs des registres ne soient modifiées.

Pour y arriver, les chercheurs ont utilisé plusieurs méthodes:

- Exception

Il s'agit de coder la fuite de données à l'ombre d'une exception, sciemment provoquée, tel un