Linux (fr)

Dépêches LinuxFR

-

Agenda du Libre pour la semaine 26 de l'année 2018

Calendrier web, regroupant des événements liés au Libre (logiciel, salon, atelier, install party, conférence), annoncés par leurs organisateurs. Voici un récapitulatif de la semaine à venir. Le détail de chacun de ces 30 événements (1 en Belgique, 29 en France, 0 au Luxembourg, 0 au Québec 0 en Suisse et 0 en Tunisie) est en seconde partie de dépêche.

- lien n°1 : April

- lien n°2 : Agenda du Libre (Belgique, France, Luxembourg, Suisse et Tunisie)

- lien n°3 : Carte des événements

- lien n°4 : Proposer un événement

- lien n°5 : Annuaire des organisations

- lien n°6 : Agenda de la semaine précédente

- lien n°7 : Agenda du Libre du Québec

Sommaire

- [FR Nantes] Cycle café vie privée Protection de son trafic sur Internet (VPN) - Le lundi 25 juin 2018 de 18h00 à 21h00.

- [FR Grenoble] Contribuer à BANO, la base d’adresse nationale d’OSM - Le lundi 25 juin 2018 de 18h30 à 20h30.

- [FR Gaillac] Atelier informatique libre - Le lundi 25 juin 2018 de 19h30 à 23h00.

- [FR Marseille] PGDay France - Le mardi 26 juin 2018 de 08h30 à 17h30.

- [FR Aiglun] Après-midi « Open data » et « Cartopartie » - Fête de l'été - Le mardi 26 juin 2018 de 15h00 à 19h00.

- [FR Quetigny] Découvrir, tester, installer Linux et d’autres logiciels libres - Le mardi 26 juin 2018 de 20h30 à 23h30.

- [FR Le Mans] Permanence du mercredi après-midi - Le mercredi 27 juin 2018 de 12h00 à 17h00.

- [FR Rennes] Sécuriser son infrastructure - Le mercredi 27 juin 2018 de 18h30 à 21h00.

- [FR Montpellier] Rencontres des Groupes OpenStreetMap OSM - Le mercredi 27 juin 2018 de 19h00 à 22h00.

- [FR Toulouse] Rencontres Tetalab - Le mercredi 27 juin 2018 de 20h30 à 23h30.

- [FR Choisy-le-Roi] Pas Sage en Seine - Du jeudi 28 juin 2018 à 10h00 au dimanche 1 juillet 2018 à 20h00.

- [FR Rennes] Conseil d’administration de Gulliver - Le jeudi 28 juin 2018 de 12h00 à 14h00.

- [FR Martigues] Permanence du jeudi de l'ULLM - Le jeudi 28 juin 2018 de 16h30 à 18h30.

- [FR Challans] Permanence Linux - Le jeudi 28 juin 2018 de 18h00 à 20h00.

- [FR Bordeaux] Jeudi Giroll - Le jeudi 28 juin 2018 de 18h30 à 20h30.

- [FR Peymeinade] Install-Party GNU/Linux - Le jeudi 28 juin 2018 de 19h00 à 21h00.

- [FR Vesseaux] Projection-débat du film « Nothing to hide » - Le jeudi 28 juin 2018 de 19h00 à 22h00.

- [FR Paris] Soirée de Contribution au Libre - Le jeudi 28 juin 2018 de 19h30 à 22h30.

- [FR Montpellier] Atelier du Libre Ubuntu et Logiciels Libres - Le vendredi 29 juin 2018 de 18h00 à 23h00.

- [FR Paris] Apéro April - Le vendredi 29 juin 2018 de 19h00 à 22h00.

- [FR Dijon] Atelier de création numérique et électronique - Le vendredi 29 juin 2018 de 20h30 à 23h59.

- [FR Saint-Jean-de-Védas] Repair Café - Le samedi 30 juin 2018 de 09h00 à 13h00.

- [FR Casseneuil] Install Partie GNU/Linux - Le samedi 30 juin 2018 de 10h00 à 17h00.

- [FR Wintzenheim] Réunion du Club Linux - Le samedi 30 juin 2018 de 13h00 à 19h00.

- [FR Villefranche-sur-Saône] Repaircafé - Le samedi 30 juin 2018 de 13h30 à 17h30.

- [FR Marseille] Install Party GNU/Linux - Le samedi 30 juin 2018 de 14h00 à 19h00.

- [BE Liège] Linux Install Party - Le samedi 30 juin 2018 de 14h00 à 18h00.

- [FR Ivry sur Seine] Cours de l’Ecole du Logiciel Libre - Le samedi 30 juin 2018 de 14h30 à 18h30.

- [FR Courbevoie] Assemblée Générale annuelle de l'association StarinuX - Le samedi 30 juin 2018 de 14h30 à 17h00.

- [FR Poucharramet] Festival AgitaTerre - Le dimanche 1 juillet 2018 de 09h30 à 23h00.

[FR Nantes] Cycle café vie privée Protection de son trafic sur Internet (VPN) - Le lundi 25 juin 2018 de 18h00 à 21h00.

Protection de son trafic sur Internet

Pourquoi et comment chiffrer son trafic sur Internet avec un VPN (réseau privé virtuel) ?

Présentation du fonctionnement d’un VPN, de son intérêt et de sa mise en place.Au bar associatif La Dérive https://lajavadesbonsenfantsblog.wordpress.com/

- La Dérive, 1 rue du Gué Robert, Nantes, Pays de la Loire, France

- Adresse web https://cafevieprivee-nantes.fr/category/actualites

- Tags café-vie-privée, anonymat, vpn, tunnel

[FR Grenoble] Contribuer à BANO, la base d’adresse nationale d’OSM - Le lundi 25 juin 2018 de 18h30 à 20h30.

Le collectif OpenStreetMap Grenoble vous invite à son prochain atelier OSM, La Base Adresses Nationale Ouverte (BANO) est une initiative d’OpenStreetMap France.

Elle a pour objet la constitution d’une base la plus complète possible de points d’adresse à l’échelle de la France.

L’objectif est de proposer une couverture d’adresses la plus étendue possible et la plus homogène possible.

Cela doit permettre de réaliser sur le plus largement possible des opérations de géocodage (Quelle position correspond à cette adresse) et de géocodage inversé (Quelle adresse correspond à cette position).

Lors de ce mapathon, le collectif OpenStreetMap Grenoble vous propose d’apprendre à contribuer à la BANO.

À partir de 18h30 à La Coop-Infolab. 31 rue Gustave Eiffel – 38 000 Grenoble

BANO ou BAN

La BAN (Base Adresse Nationale) est la base de référence nationale issue d’une convention signée entre l’IGN, le Groupe La Poste, l’État et OpenStreetMap France.

BANO est un projet initié par OpenStreetMap France début 2014 et n’a pas encore intégré de données issues de la BAN (chantier en cours). Le contenu de la BAN est plus complet (plus de 20 millions d’adresses) que BANO (15. 5M d’adresses), mais n’intègre(ra) pas de contributions faites sur OpenStreetMap et encore très peu de données opendata diffusées par certaines collectivités.

C’est quoi OSM

OpenStreetMap (OSM) est un projet international fondé en 2004 dans le but de créer une carte libre du monde.

Nous collectons des données dans le monde entier sur les routes, voies ferrées, les rivières, les forêts, les bâtiments et bien plus encore

Les données cartographiques collectées sont ré-utilisables sous licence libre ODbL (depuis le 12 septembre 2012). Pour plus d’information inscrivez-vous à la liste locale OSM de Grenoble

- La Coop Infolab, 31 rue Gustave Eiffel, Grenoble, Auvergne-Rhône-Alpes, France

- Adresse web https://www.la-coop.net/evenement/atelier-osm-juin18

- Tags osm, openstreetmap, cartographie, atelier

[FR Gaillac] Atelier informatique libre - Le lundi 25 juin 2018 de 19h30 à 23h00.

Un atelier d’informatique libre voit le jour au sein du chinabulle, pour créer un espace temps d’échange autour des solutions informatiques libres.

- Au comptoir du Chinabulle, 47 rue du Chateau du Roi, Gaillac, Occitanie, France

- Adresse web https://www.chinabulle.org

- Tags échange, transmission, logiciels-libres, découverte, chinabulle, atelier

[FR Marseille] PGDay France - Le mardi 26 juin 2018 de 08h30 à 17h30.

Le PGDay France est un moment de rencontres et de conférences pour la communauté francophone de PostgreSQL.

Les conférences s’adressent à tous les utilisateurs du logiciel étudiants, administrateurs systèmes, DBA, développeurs, chefs de Projets, décideurs.

- Théâtre Joliette, 2 place Henri Verneuil, Marseille, Provence-Alpes-Côte d’Azur, France

- Adresse web http://pgday.fr

- Tags postgresqlfr, conference, pgday

[FR Aiglun] Après-midi « Open data » et « Cartopartie » - Fête de l'été - Le mardi 26 juin 2018 de 15h00 à 19h00.

Démarche participative et collaborative, il s’agit notamment de permettre aux associations, producteurs locaux, habitants et usagers de cartographier les services / activités qui constituent la richesse de notre territoire sur un outil libre (Openstreetmap).

Les données publiques communales mises en ligne et la création d’un agenda partagé (à destination des associations) seront également valorisées.

Les organisateurs du marché d’Aiglun proposeront de nombreuses animations à travers la fête l’été. Venez nombreux

Tout l’après-midi marché bio et des producteurs locaux, animation musicale, balades avec les ânes, jeux, atelier de cartographie libre

À 15 h, 16 h et 17 h visite du champ de lavande rendez-vous sur la place du marché

À partir de 17 h dégustations des produits du marché préparés par le restaurant Le Pressoir Gourmand et grillades d’agneau

À 18 h apéritif local offert par la mairie d’Aiglun, débat sur la cartographie et les données ouvertes

- Marché bio et des producteurs locaux d'Aiglun, place Edmond Jugy, Aiglun, Provence-Alpes-Côte d'Azur, France

- Adresse web https://wiki.openstreetmap.org/wiki/Cartopartie_et_opendata_-_aiglun

- Tags openstreetmap, osm, open-data, carto-partie

[FR Quetigny] Découvrir, tester, installer Linux et d’autres logiciels libres - Le mardi 26 juin 2018 de 20h30 à 23h30.

COAGUL est une association d’utilisateurs de logiciels libres et de GNU Linux en particulier.

Nous utilisons toutes sortes de distributions GNU / Linux (Ubuntu, CentOs, Fedora, Debian, Arch…) et toutes sortes de logiciels pourvu qu’ils soient libres (VLC, LibreOffice, Firefox, Thunderbird, GPG, Tor, OpenNebula, LXC, Apache…).

Nous partageons volontiers nos connaissances des logiciels libres et l’entraide est de mise dans nos réunions.

Les permanences servent à se rencontrer et à partager nos expériences et notre savoir sur le logiciel libre.

Vous souhaitez nous rencontrer nous vous accueillerons à notre permanence.

On adore les gâteaux et les chocolats, vous pouvez donc en apporter-)

- Centre Social et Culturel Léo Lagrange, 3 rue des Prairies, Quetigny, Bourgogne-Franche-Comté, France

- Adresse web https://www.coagul.org

- Tags permanence, coagul, logiciels-libres, linux

[FR Le Mans] Permanence du mercredi après-midi - Le mercredi 27 juin 2018 de 12h00 à 17h00.

Assistance technique et démonstration concernant les logiciels libres.

- Centre social, salle 220, 2ᵉ étage, Pôle associatif Coluche, 31 allée Claude Debussy, Le Mans, Pays de la Loire, France

- Adresse web https://linuxmaine.org

- Tags linuxmaine, permanence, assistance

[FR Rennes] Sécuriser son infrastructure - Le mercredi 27 juin 2018 de 18h30 à 21h00.

La sécurité informatique ne repose pas que sur la qualité du code et le chiffrement (même s’ils sont essentiels), c’est aussi une question d’architecture.

Vous (re)découvrirez quelques principes de sécurisation des infrastructures informatiques tels que la séparation des flux, la redondance et d’autres éléments pouvant améliorer la protection et la disponibilité des services.

La conférence sera présentée par

Thomas MICHEL

Esprit Libre

esprit-libre-conseil.com (link is external)mercredi 27 juin - 18h30

FrenchTech Rennes - Saint-Malo

2 rue de la Mabilais

Rennes- FrenchTech Rennes - Saint-Malo, 2 rue de la Mabilais, Rennes, Bretagne, France

- Adresse web https://caplibre.fr/actualites/securiser-son-infrastructure

- Tags caplibre, conférence, sécurité

[FR Montpellier] Rencontres des Groupes OpenStreetMap OSM - Le mercredi 27 juin 2018 de 19h00 à 22h00.

Ces rencontres mensuelles se veulent être des instants conviviaux pour faire un compte-rendu des activités du mois précédent, mais aussi pour présenter les opérations et rendez-vous à venir que proposent les groupes HérOSM et le Collectif des Garrigues. Naturellement, elles sont également ouvertes à tout public.

Si vous avez des propositions n’hésitez pas à compléter la page dédiée.

- En première partie de soirée, une initiation pour les débutants est prévue

- Possibilité d’initiation à la contribution pour les débutants qui le désire

- Préparation du dossier pour le budget de l’Opération Libre

- Préparation de l’Opération Libre à Jacou

- Travail sur les voies manquantes sur (enjeu évident de géocodage d’adresses, comme celles fournies par SIRENE ou FANTOIR par exemple

- Petit topo sur la saisie des noms de rues à partir des données cadastre/fantoir par département

-

Propositions au sujet du calcul d’itinéraire multimodal (auto, vélo, piéton) dans les futures discussions

- La pratique des cartoparties

- Faut-il prioriser la cartographie de certains endroits (gares et arrêts de tram, par exemple) ?

Contributions libres

Nous vous présenterons les projets en cours, nous vous vous proposerons de contribuer, faire de la production de données, puis nous passerons à un instant convivial sur la terrasse.

Comme d’habitude, chacun amène ce qu’il veut à manger et à boire pour un repas partagé.

N’oubliez pas vos ordinateurs portables pour la séance de saisieLe dernier mercredi de chaque mois

Mercredi 27 septembre 2017 de 19h00 à 22h00

Mercredi 25 octobre 2017 de 19h00 à 22h00

Mercredi 29 novembre 2017 de 19h00 à 22h00

Mercredi 20 décembre 2017 de 19h00 à 22h00

Mercredi 24 janvier 2018 de 19h00 à 22h00

Mercredi 28 février 2018 de 19h00 à 22h00

Mercredi 28 mars 2018 de 19h00 à 22h00

Mercredi 25 avril 2018 de 19h00 à 22h00

Mercredi 30 mai 2018 de 19h00 à 22h00

Mercredi 27 juin 2018 de 19h00 à 22h00Mercredi 27 septembre 2017 de 19h00 à 22h00

Le Faubourg - 15, rue du Faubourg de Nîmes, 34 000 MontpellierTramway lignes 1, 2 et 4 arrêt Corum

GPS Latitude 43.614186 | Longitude 3.881404

Carte OpenStreetMapLe dernier mercredi de chaque mois.

- Le Faubourg, 15 rue du Faubourg de Nîmes, Montpellier, Occitanie, France

- Adresse web http://montpel-libre.fr

- Tags osm, openstreetmap, cartographie, donnee, saisie, cartopartie, participative, rencontre, logiciels-libres, montpel-libre

[FR Toulouse] Rencontres Tetalab - Le mercredi 27 juin 2018 de 20h30 à 23h30.

Rencontre hebdomadaire des hackers et artistes libristes Toulousains.

Ouvert au public tous les mercredi soir.

Venez nombreux.

- Mix'Art Myrys, 12 rue Ferdinand Lassalle, Toulouse, Occitanie, France

- Adresse web https://www.tetalab.org

- Tags rencontre, hacker, artistes-libristes, tetalab

[FR Choisy-le-Roi] Pas Sage en Seine - Du jeudi 28 juin 2018 à 10h00 au dimanche 1 juillet 2018 à 20h00.

Le festival auto-organisé par vous et l’équipe de Pas Sage En Seine se tiendra du 28 juin au 1er juillet 2017 à Choisy-le-Roi dans et aux abords de la Médiathèque Louis Aragon.

Nous vous invitons à participer à PSES2018 et venir participer à ses ateliers et conférences bien sûr, mais aussi installations, discussions et autres formes d’interventions.

Des thèmes sont proposés, pas imposés, pour laisser place à la manifestation d’idées originales.

Le Festival sera un moment convivial et festif pour décrire nos modes d’organisation, nos outils, nos perspectives, évoquer les usages d’autodéfense numériques faces aux perpétuelles manipulations sécuritaires.

Le vendredi sera une journée spéciale consacrée au RGPD, et le samedi soir (lors de la micro-nocturne jusqu’à 21h30) vous pourrez assister à un concert de chiptune réalisé par le collectif Chip Bangers.

L’Hacktiviste naît de cette prise de conscience intégrale. Il ouvre, détourne, invente tous les possibles, ou presque… Être et faire politiquement ensemble sera notre prochaine étape

Le trajet depuis le centre de Paris prend une petite vingtaine de minutes uniquement (Gare du RER C Choisy-le-Roi).

- Médiathèque Louis Aragon, 17 rue Pierre Mendès France, Choisy-le-Roi, Île-de-France, France

- Adresse web https://passageenseine.fr

- Tags numérique, hacktivisme, communs, privacy, hacking, white, atelier, conference

[FR Rennes] Conseil d’administration de Gulliver - Le jeudi 28 juin 2018 de 12h00 à 14h00.

Gulliver tiendra son conseil d’administration à la Maison de la Consommation et de l’Environnement (MCE) le jeudi 28 juin 2018 à partir de 12 h. L’ordre du jour est donné dans le lien ci-dessous.

Ce conseil d’administration est ouvert à tous. Toute personne, membre ou non membre de Gulliver, peut y assister (sauf CA exceptionnel signalé à l’avance), voir comment fonctionne notre association et y donner son avis.

La MCE est située 42 bd Magenta à Rennes (plan d’accès). La salle réservée est celle de l’accueil.

- Maison de la Consommation et de l’Environnement, 48 bd Magenta, Rennes, Bretagne, France

- Adresse web http://gulliver.eu.org/conseil_dadministration_juin_2018

- Tags gulliver, conseil-administration

[FR Martigues] Permanence du jeudi de l'ULLM - Le jeudi 28 juin 2018 de 16h30 à 18h30.

Comment utiliser et les Logiciels Libres.

avec l’association des Utilisateurs de Logiciels Libres du Pays de Martégal (ULLM).

28 2018 de 16h30 à 18h30 à la (quai des Anglais).

Entrée Libre. Tout public.

- Médiathèque de Martigues, quai des Anglais, Martigues, Provence-Alpes-Côte d’Azur, France

- Adresse web http://www.ullm.org

- Tags ullm, logiciels-libres, linux, permanence, gnu-linux

[FR Challans] Permanence Linux - Le jeudi 28 juin 2018 de 18h00 à 20h00.

Chaque dernier jeudi du mois, Linux Challans vous donne rendez-vous à l’Albanera Café, 17 rue du Général Leclerc 85 300 Challans.

Nous vous proposons lors de ces rendez-vous mensuels d’échanger autour du Libre, des conseils ou une assistance technique.

Vous pouvez venir pour vous faire aider, ou aider, à installer et paramétrer une distribution GNU/Linux de votre choix ou des logiciels libres sur votre ordinateur.

Recommandations

- Sauvegardez vos données avant de venir.

- Libérez de la place sur le disque dur (20 Go minimum) et défragmentez Windows si vous voulez le conserver.

- Nous prévenir de votre passage via la messagerie.

Vous pouvez aussi venir pour une première prise d’informations et de contacts.

Nous vous attendons toujours plus nombreux

- Albanera Café, 17 rue du Général Leclerc, Challans, Pays de la Loire, France

- Adresse web http://linuxchallans.org

- Tags linux-challans, permanence, rencontre, mensuelle, soirée, logiciels-libres, gnu-linux

[FR Bordeaux] Jeudi Giroll - Le jeudi 28 juin 2018 de 18h30 à 20h30.

Les membres du collectif Giroll, GIROnde Logiciels Libres, se retrouvent une fois par semaine, pour partager leurs savoir-faire et expériences autour des logiciels libres.

Le collectif réalise aussi une webradio mensuelle, tous les second mardis du mois, à retrouver en direct sur le site de Giroll.

Ses rencontres sont ouvertes à tous.

- Centre d’animation Saint Pierre, 4 rue du mulet, Bordeaux, Nouvelle-Aquitaine, France

- Adresse web https://www.giroll.org

- Tags rencontre, install-partie, giroll, webradio, logiciels-libres, rencontre-hebdomadaire

[FR Peymeinade] Install-Party GNU/Linux - Le jeudi 28 juin 2018 de 19h00 à 21h00.

Désormais tous les 4ᵉˢ mercredi du mois, Clic Ordi et Linux Azur vous proposent une install-party ouverte à tous et gratuite.

- Découvrez un monde rempli de Papillons, licornes, mais surtout de manchots

- Plus besoin de se soucier des virus et autres logiciels malveillants.

- Le support de Windows Vista s’arrête dans un an, et les principaux logiciels ont déjà arrêté leurs mise à jour, réagissez

- Ramenez vos ordinateurs obsolètes et donnez leur une seconde vie.

Nous aimerions développer autour de Handy-Linux (et de sa future mouture avec Debian-Facile) afin de répondre à des besoins simples pour des personnes difficiles à former et pouvant se retrouver en fracture numérique).

Nous sommes ouverts à tout, y compris à la bidouille sur l’atelier avec le fer à souder.

Organisé conjointement par http://clic-ordi.com/fr et https://www.linux-azur.org

- Magasin Clic Ordi, 65 avenue de Boutiny, Peymeinade, Provence-Alpes-Côte d’Azur, France

- Adresse web https://www.linux-azur.org/ral/ral-peymeinade-clicordi

- Tags linux-azur, install-party, clic-ordi, bidouille, handy-linux

[FR Vesseaux] Projection-débat du film « Nothing to hide » - Le jeudi 28 juin 2018 de 19h00 à 22h00.

Ouverture des portes à 19h pour partager un moment de convivialité, discuter des choses et d’autres comme les logiciels libres, les données personnelles, la vie privée

Il y a une buvette sur place, et vous pouvez également apporter un plat à partager ou biscuits apéro

La projection du film documentaire Nothing to Hide aura lieu à 20h30, et sera suivie d’un débat pour répondre à vos questions

« Dire que votre droit à la vie privée importe peu, car vous n’avez rien à cacher revient à dire que votre liberté d’expression importe peu, car vous n’avez rien à dire. Car même si vous n’utilisez pas vos droits aujourd’hui, d’autres en ont besoin. Cela revient à dire les autres ne m’intéressent pas », Edward Snowden

Ce documentaire aborde le thème de la vie privée et des données personnelles.

L’entrée est à prix libre (adhésion à l’association Vesseaux-Mère).

- le Vesseaux-Mère, 23 chemin du Prieuré, place de l'Église, Vesseaux, Auvergne-Rhône-Alpes, France

- Adresse web https://ardechelibre.org/projection-debat-du-film-documentaire-nothing-to-hide/

- Tags vie-privée, projection, nothing-to-hide, débat

[FR Paris] Soirée de Contribution au Libre - Le jeudi 28 juin 2018 de 19h30 à 22h30.

Parinux propose aux utilisateurs de logiciels libres de se réunir régulièrement afin de contribuer à des projets libres. En effet, un logiciel libre est souvent porté par une communauté de bénévoles et dépend d’eux pour que le logiciel évolue.

Nous nous réunissons donc tous les dans un environnement propice au travail (pas de facebook, pas de télé, pas de jeux vidéos, pas de zombies).

Vous aurez très probablement besoin d’un ordinateur portable, mais électricité et réseau fournis.

En cas de difficulté, vous pouvez joindre un des responsables de la soirée, Emmanuel Seyman (emmanuel (at) seyman.fr), Paul Marques Mota mota (at) parinux.org, ou Magali Garnero (Bookynette) tresorier (at) parinux.org.

Pour obtenir le code d’entrée de la porte cochère, envoyez un mail au responsable.

On peut amener de quoi se restaurer (Franprix, 8 rue du Chemin Vert, ferme à 22h)

Regazouillez sur Twitter - Wiki des soirées

Programme non exhaustif

- Fedora (sa traduction)

- Parinux, ses bugs et son infrastructure

- April, … y a toujours quelque chose à faire

- Open Food Facts/ Open Beauty Facts, sa base de données, ses contributeurs, sa roadmap

- Schema racktables, son code

- Agenda du Libre, mise à jour et amélioration du code

- Ubuntu-Fr, son orga, ses événements

- En vente libre, maintenance et commandes

- Open street map, une fois par mois

- Linux-Fr sait faire

- en vente libre

- …

tout nouveau projet est le bienvenu.

- FPH, 38 rue Saint-Sabin, Paris, Île-de-France, France

- Adresse web http://www.parinux.org/

- Tags parinux, scl, soirée-de-contribution-au-libre, fph, logiciels-libres

[FR Montpellier] Atelier du Libre Ubuntu et Logiciels Libres - Le vendredi 29 juin 2018 de 18h00 à 23h00.

L’équipe de Montpel’libre vous propose une permanence Logiciels Libres, discussions libres et accompagnements techniques aux systèmes d’exploitation libres, pour vous aider à vous familiariser avec votre système GNU/Linux au quotidien.

Le contenu de l’atelier s’adapte aux problèmes des personnes présentes et permet ainsi l’acquisition de nouvelles compétences au rythme de chacun.

Vous pourrez y aborder plusieurs thèmes

- Discussions conviviales entre utilisateurs autour de Linux en général

- Préinscription aux prochains Cafés Numériques et Install-Party

- Premières explorations du système

- Installations et configurations complémentaires

- Mise à jour et installation de nouveaux logiciels

- Prise en main, découverte et approfondissement du système

Les Ateliers du Libre ont lieu à la Mpt Melina Mercouri de Montpellier, tous les derniers vendredis de chaque mois de 18h00 à 20h00, sauf période de vacances.

Entrée libre et gratuite sur inscription. Une simple adhésion à l’association est possible et auprès de la Mpt.

Cet événement est proposé par le partenariat qui lie la Mpt Melina Mercouri de Montpellier et Montpel’libre.

Toute une équipe de passionnés, vous propose l’animation de l’Atelier du Libre par les membres de Montpel’libre. Permanence Logiciels Libres, discussions libres et accompagnements des utilisateurs aux systèmes exploitation libres, Linux, sur le cyberespace de consultations libres.

En fin de soirée, l’atelier fera progressivement place à un instant très convivial, les RDVL sont des rendez-vous mensuels de discussions sur le thème des logiciels libres, des arts libres, de l’open source et plus généralement de la culture du libre et du numérique.

Cette soirée, très conviviale, se passe autour d’un repas partagé, chacun porte un plat, entrée, spécialité, dessert, boisson… Ordinateurs et réseaux disponibles.

Notre équipe vous attend pour répondre à vos questions et satisfaire votre curiosité.

Maison pour tous Mélina Mercouri 842, rue de la vieille poste, 34 000 Montpellier

Bus ligne 9, La Ronde arrêt Pinville

GPS Latitude 43.61354 Longitude 3.908768

Carte OpenStreetMapRendez-vous mensuel, tous les derniers vendredis, salle jamais le dimanche

- Maison pour tous Mélina Mercouri, 842 rue de la Vieille Poste, Montpellier, Occitanie, France

- Adresse web http://montpel-libre.fr

- Tags atelibre, accompagnement, initiation, gnu-linux, logiciels-libres, montpel-libre, ubuntu

[FR Paris] Apéro April - Le vendredi 29 juin 2018 de 19h00 à 22h00.

Un apéro April consiste à se réunir physiquement afin de se rencontrer, de faire plus ample connaissance, d’échanger, de partager un verre et manger mais aussi de discuter sur le logiciel libre, les libertés informatiques, fondamentales, l’actualité et les actions de l’April…

Un apéro April est ouvert à toute personne qui souhaite venir, membre de l’April ou pas.

N’hésitez pas à venir nous rencontrer.

Où et quand cela se passe-t-il

L’apéro parisien aura lieu vendredi 29 juin 2018 à partir de 19h00 dans les locaux de l’April.

L’adresse

April, 44/46 rue de l’Ouest, bâtiment 8, 75 014 Paris (entrée possible par la place de la Catalogne, à gauche de la Biocoop, au niveau des Autolib).

Métros Gaîté, Pernety, Montparnasse. Sonner à « April » sur l’interphone.

Le téléphone du local 01 78 76 92 80.L’Apéro a lieu à Paris notamment parce que le local s’y trouve ainsi que les permanents et de nombreux actifs. Pour les apéros dans les autres villes voir sur le pad plus bas.

En ouverture de l’apéro nous ferons un court point sur les dossiers/actions en cours.

Le glou et le miam

Vous pouvez apporter de quoi boire et manger afin de reprendre des forces régulièrement. Nous prévoirons bien sûr un minimum vital.

Vous pouvez vous inscrire sur le pad.

- Bâtiment 8, 44/46 rue de l’Ouest, Paris, Île-de-France, France

- Adresse web https://pad.april.org/p/aperosapriljuin2018

- Tags apéro, april, rencontre

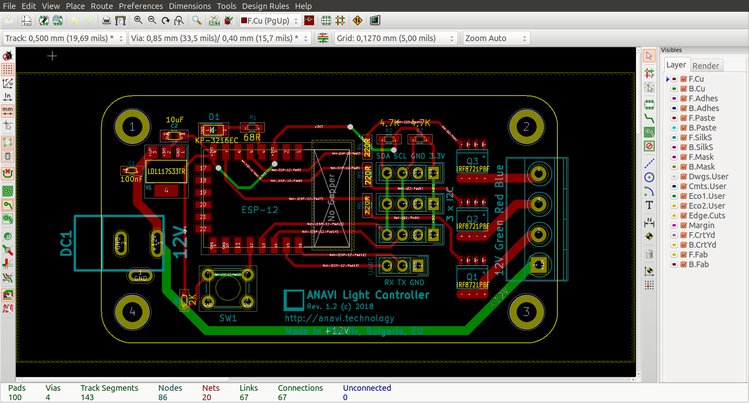

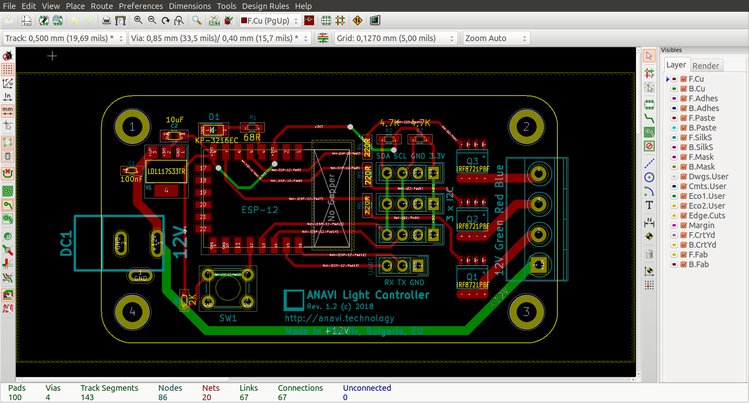

[FR Dijon] Atelier de création numérique et électronique - Le vendredi 29 juin 2018 de 20h30 à 23h59.

Le fablab et hackerspace l’abscisse vous propose comme tous les vendredis soir un atelier de création numérique et électronique.

L’atelier est équipé de différents outils perceuse, CNC, Arduino, Raspberry Pi, ordinateurs, oscilloscope, multimètre.

Une ressourcerie est à disposition, vous y trouverez des composants électroniques et des pièces détachées à prix libre.

Vous pouvez venir découvrir l’atelier et les usagers du fablab à partir de 20h30.

Vous pouvez aussi venir pour participer aux travaux numériques en cours, partager vos connaissances et vos savoir-faire.

Tous nos travaux sont libres et documentés sous licence libre.

- Fablab et hackerspace l’abscisse, 6 impasse Quentin, Dijon, Bourgogne-Franche-Comté, France

- Adresse web https://fablab.coagul.org

- Tags lab6, coagul, électronique, atelier, fablab

[FR Saint-Jean-de-Védas] Repair Café - Le samedi 30 juin 2018 de 09h00 à 13h00.

Nous vous proposons ce rendez-vous, où, bricoleurs, acteurs, bénévoles, associations, vous attendent pour vous aider à donner une deuxième vie à vos objets.

Réparer ensemble, c’est l’idée des Repair Cafés dont l’entrée est ouverte à tous. Outils et matériel sont disponibles à l’endroit où est organisé le Repair Café, pour faire toutes les réparations possibles et imaginables. Vêtements, meubles, appareils électriques, bicyclettes, vaisselle, objets utiles, jouets, et autres. D’autre part sont présents dans le Repair Café des experts bénévoles, qui ont une connaissance et une compétence de la réparation dans toutes sortes de domaines.

On y apporte des objets en mauvais état qu’on a chez soi. Et on se met à l’ouvrage avec les gens du métier. Il y a toujours quelque chose à apprendre au Repair Café. Ceux qui n’ont rien à réparer prennent un café ou un thé, ou aident à réparer un objet appartenant à un autre. On peut aussi toujours y trouver des idées à la table de lecture qui propose des ouvrages sur la réparation et le bricolage.

Repair Café est un atelier consacré à la réparation d’objets et organisé à un niveau local, entre des personnes qui habitent ou fréquentent un même endroit, par exemple un quartier ou un village. Ces personnes se rencontrent périodiquement en un lieu déterminé, dans un café, une salle des fêtes ou un local associatif où des outils sont mis à leur disposition et où ils peuvent réparer un objet qu’ils ont apporté, aidés par des volontaires.

Les objectifs de cette démarche alternative sont divers

- réduire les déchets

- préserver l’art de réparer des objets

- renforcer la cohésion sociale entre les habitants des environs

Seront présents

- Autour.com : On se rend des services entre voisins, on partage des infos, on prête, on loue, on donne…

- L’Accorderie : Est un système d’échange de services entre habitants d’un même quartier ou d’une même ville.

- La Gerbe : Contribuer à la formation de citoyens éveillés, engagés et solidaires en offrant aux enfants et aux jeunes un espace privilégié d’expression et d’épanouissement Crèche, Centre de loisirs, Scoutisme, Ateliers, chacun peut y trouver un cadre pour son développement grâce au travail d’une équipe de professionnels et de bénévoles.

- Les Compagnons Bâtisseurs : Prévoient d’amener des outils

- Les Petits Débrouillards : est un réseau national de culture scientifique et technique, ils viendront avec pleins de conseils et une imprimante 3D.

- Le Faubourg : Hébergera le Repear Café.

- Montpel’libre : Sera là avec des pièces informatiques, pour essayer de reconditionner des ordinateurs, dépanner ceux qui ne fonctionnent plus, expliquer comment ça marche, faire comprendre le choix judicieux du logiciel libre, contourner l’obsolescence programmée grâce à GNU/Linux, comment réparer et entretenir son matériel soi-même, nous porterons un jerry.

- TechLabLR : Accompagne les projets à composantes technologiques afin de les amener au pré-prototype, puis les guider vers les structures d’accompagnements.

- Violons Dingues : Passionnés de la vie, des autres, de la culture, de l’art, du sport, de la mécanique, de la moto, de la photo, de la musique, des animaux, des insectes, des plantes, de l’environnement, enfin de tout ce qui circule (au propre comme au figuré) sur notre planète.

Zéro Waste Montpellier : La démarche « Zéro Waste » est une démarche positive pour aller vers une société zéro déchet et zéro gaspillage.

Maison des Associations, 18 bis rue Fon de l’Hospital, Saint-Jean-de-Védas, Occitanie, France

Adresse web http://montpel-libre.fr

Tags

montpel-libre, repair-cafe, atelier

[FR Casseneuil] Install Partie GNU/Linux - Le samedi 30 juin 2018 de 10h00 à 17h00.

Le Samedi 30 Juin les bénévoles d’aGeNUx sont invités dans les locaux d’Avec 2L pour une Install-party.

Venez découvrir et partager le monde du logiciel libre en toute sérénité.

Animation Libre et non payante.

Auberge Espagnole le midi.

Avec 2L se situe derrière la poste de Casseneuil

- Avec 2L, chemin de la Tuilerie, Casseneuil, Nouvelle-Aquitaine, France

- Adresse web http://www.agenux.org

- Tags install-party, agenux, logiciels-libres, gnu-linux

[FR Wintzenheim] Réunion du Club Linux - Le samedi 30 juin 2018 de 13h00 à 19h00.

Comme tous les 3 samedis, le Club Linux de la MJC du Cheval Blanc se réunit et accueille toutes les personnes qui souhaitent découvrir ou approfondir Linux et les Logiciels Libres. Aucune compétence n’est demandée.

Pendant ces rencontres, informelles,

- nous accueillons celles et ceux qui cherchent une réponse ou souhaitent découvrir Linux et les Logiciels Libres,

- nous installons Linux sur des ordinateurs, la plupart des fois en « dual boot »(*), ce qui permet de conserver l’ancien système (par exemple Windows) et d’utiliser quand même, en choisissant au démarrage,

- nous partageons nos recherches et nos découvertes, les nouveautés.

Le Club Linux est également impliqué dans une démarche de libération des GAFAM (Google Apple Facebook Amazon Microsoft) et de promotion de solutions libres comme, entre autres, Wikipedia, Openstreetmap, les Framatrucs (*), les Chatons (*) et beaucoup d’autres.

(*) : mais on vous expliquera

- MJC du Cheval Blanc, 1 faubourg des Vosges, Wintzenheim, Grand Est, France

- Adresse web http://mjc-chevalblanc.fr/-club-linux-.html

- Tags linux, logiciel-libre, mjc-du-cheval-blanc, club-linux

[FR Villefranche-sur-Saône] Repaircafé - Le samedi 30 juin 2018 de 13h30 à 17h30.

Dernier Repaircafé caladois mensuel de la saison avant les vacances.

Avec la participation habituelle de la CAGULL.

- Caveau Jacques Higelin, 230 rue de la Quarantaine, Villefranche-sur-Saône, Auvergne-Rhône-Alpes, France

- Adresse web https://repaircafe.org/en/locations/repair-cafe-villefranche-sur-saone

- Tags cagull, repair-cafe, reparer, recyclage

[FR Marseille] Install Party GNU/Linux - Le samedi 30 juin 2018 de 14h00 à 19h00.

L’association (CercLL d’Entraide et Réseau Coopératif autour des Logiciels Libres) vous invite à une install party GNU/Linux, le, dans la salle du Foyer du Peuple 50 rue Brandis 13 005 Marseille.

Vous avez envie de découvrir un système d’exploitation libre, simple d’utilisation, stable, rapide et sécurisé. Une nouvelle façon d’utiliser votre ordinateur.

Vous vous sentez une affection naissante pour le Gnou et le, les mascottes de

Au programme

DÉCOUVERTE de l’univers des logiciels libres.

INSTALLATION d’un environnement GNU/ Linux, ainsi que le meilleur des logiciels libres.

Venez avec votre ordinateur, nous installerons ensemble une distribution avec un ensemble de et pour une utilisation quotidienne.

Ouvert à tous – accessible aux débutant-e-s

Une participation de 2 euros est demandée.

L’adhésion à l’association est de 20 euros annuelle.(L’adhésion n’est pas obligatoire).

- Foyer du Peuple, 50 rue Brandis, Marseille, Provence-Alpes-Côte d’Azur, France

- Adresse web https://cercll.wordpress.com/espace-evenement

- Tags cercll, foyer-du-peuple, install-party, logiciels-libres, gnu-linux, ubuntu, xubuntu, mageia, debian

[BE Liège] Linux Install Party - Le samedi 30 juin 2018 de 14h00 à 18h00.

Une Linux Install Party a lieu tous les derniers samedis du mois de septembre à juin, dans les locaux du Cyber Seniors Énéo de Grivegnée, où je suis animateur.

L’accès et la participation à l’Install Party est ouvert à tous et est gratuit.

Vous venez avec votre ordinateur et on y installe le Linux que vous désirez.

Les installations commencent à 14h et finissent à 18h.

Prévoyez de venir avant 17h, parfois ça peut durer longtemps.- Cyber Seniors Énéo, rue Fraischamps 74b, Liège, Liège, Belgique

- Adresse web http://www.jhc-info.be

- Tags linux, gnu-linux, install-party, installation, logiciels-libres

[FR Ivry sur Seine] Cours de l’Ecole du Logiciel Libre - Le samedi 30 juin 2018 de 14h30 à 18h30.

Présentation de l’E2L

Quel est le rôle de l’école du logiciel libre

Tout d’abord, ce n’est pas une école comme les autres. Elle n’a pas d’établissement fixe, pas de cours de récréation, pas de carte d’étudiant, ni de diplôme de fin d’année.

Comme toutes les écoles, son rôle est d’apprendre à ses élèves les logiciels libres, c’est-à-dire

- comment en trouver de bons parmi les nombreux sites qui en proposent,

- comment en prendre possession en fonction des licences,

- comment les installer en fonction de ses besoins,

- comment les tester et les utiliser,

- comment en comprendre le fonctionnement pour ensuite les modifier,

- comment écrire ses propres logiciels libres.

En fait, l’école du logiciel libre est une université populaire, comme celles qui ont vu le jour en France à partir du 19ᵉ siècle, et dont le but est de transmettre des connaissances théoriques ou pratiques à tous ceux qui le souhaitent. Et pour atteindre ce but, sa forme juridique est de type " association à but non lucratif ".

Comment fonctionne l’école

Cette école étant une association, elle possède, comme toutes les autres, un bureau, élu chaque année en assemblée générale, pour l’administrer. Mais elle a aussi des responsables pédagogiques dont le rôle est essentiel, car ce sont eux qui établissent les programmes des cours en fonction des souhaits des adhérents, valident les candidatures des enseignants et affectent les sessions.

Les membres du bureau et les responsables pédagogiques forment « l’encadrement de l’école ». Tous les membres « encadrants » doivent être membres de l’association.

Les locaux où se déroulent les cours seront ceux que l’on veut bien nous prêter une salle des fêtes, un théâtre, une salle de réunion publique, un amphi dans une école publique, ou autre.

Les thèmes des cours sont définis par les adhérents en fonction de leurs envies, de leurs besoins. Les cours sont ensuite décidés par les responsables pédagogiques de l’école en fonction des enseignants disponibles.

Afin de permettre au plus grand nombre de participer et d’assister aux cours, les sessions se tiennent essentiellement le samedi. Une première de 9h à 12h30, et une autre de 14h à 17h30.

Programme détaillé sur le site http://e2li.org

- Salle LCR, 79 avenue Danielle Casanova, Ivry sur Seine, Île-de-France, France

- Adresse web https://e2li.org

- Tags e2l, cours, ecole-du-logiciel-libre, logiciels-libres

[FR Courbevoie] Assemblée Générale annuelle de l'association StarinuX - Le samedi 30 juin 2018 de 14h30 à 17h00.

L'association GULL StarinuX vous invite à son

ASSEMBLÉE GÉNÉRALE annuelle

le samedi 30 juin 2018 à 14h30,

48 rue de Colombes 92 400 Courbevoie

(SNCF Gare de Courbevoie, Saint Lazare <=> La Défense).

Seuls les adhérent(e)s peuvent voter, mais les discussions restent ouvertes à tous les présents.

Un déjeuner facultatif aura lieu à 12h30.

Au plaisir de nous rencontrer à l’AG 2018

Le Bureau de StarinuX

- Bâtiment des associations, 48 rue de Colombes, Courbevoie, Île-de-France, France

- Adresse web https://www.starinux.org/ag-2018/index.php

- Tags starinux, assemblee-generale

[FR Poucharramet] Festival AgitaTerre - Le dimanche 1 juillet 2018 de 09h30 à 23h00.

L’association 3PA Formation vous invite à la cinquième édition du Festival AgitaTerre Nous vous donnons rendez-vous le dimanche 1er juillet au coeur du village de Poucharramet (31), entre la place des Marronniers et La Maison de la Terre

Venez découvrir des alternatives durables, locales et citoyennes qui font vivre notre territoire. Cette année, le festival investit le thème des Communs venez en apprendre plus

Un événement gratuit et tout public

9h30-18h

Marché de producteurs et artisans-créateurs locaux

Forum associatif & Village des CommunsConférences

Expositions « C’est quoi les Communs »

Ateliers tous publicsExpositions d’artistes sculpteurs sur bois

Mur d’expression libre

Vannerie géante collectiveConcerts

Spectacles et animationsBuvette & Restauration

Espace enfants20h30 Grand concert en plein air avec notre partenaire La Maison de la Terre

Programmation et exposants sur www.agitaterre.fr

Infos agitaterre@3paformation.fr // 3PA 05.61.08.11.30

Parking sur place

Adapté aux personnes à mobilité réduite- Place des Marronniers, Poucharramet, Occitanie, France

- Adresse web http://association3pa.wixsite.com/agitaterre

- Tags agitaterre, festival, alternatives, écologie, conférences

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Dr. Geo 18.06

GNU Dr. Geo est un logiciel de géométrie interactive euclidienne du plan, pour une utilisation à l'école secondaire et primaire. Il permet d'organiser des activités pédagogiques dans l'enseignement de la géométrie, voire d'autres domaines liés des mathématiques.

Intégré à un environnement dynamique de programmation Smalltalk, il propose également une approche de la géométrie dynamique par la programmation, soit par l'utilisation de script(s) intégré(s) à une figure, soit par une description purement programmatique d'une construction géométrique. En outre, Dr. Geo est toujours modifiable depuis lui-même, fonctionnalité héritée de son environnement de développement.

La version 18.06 fait suite à la version 17.07 sortie en juillet 2017. Une grande partie de l'effort fut de porter le code de la version 3 à la version 7 de l'environnement Smalltalk Pharo avec lequel est développé Dr. Geo. Outre les corrections de bugs inhérentes à ce portage, quelques fonctionnalités nouvelles ont fait leur apparition.

- lien n°1 : GNU Dr. Geo

- lien n°2 : Article Wikipedia

Nouvelles fonctionalités

Navigateur de code dédié

Dans Dr. Geo, un script est défini par une classe Pharo. L'utilisateur insère alors une instance du script dans la figure géométrique ; il lui associe si nécessaire d'autres objets géométriques de la figure en paramètres. Un script effectue un traitement ad-hoc, calculs ou modifications sur d'autres objets de la figure tels que programmés dans les méthodes du script. Une fois défini, le script est facile à utiliser.

L'édition de script se fait maintenant à l'aide d'un outil d'édition de code dédié, et non plus par l'intermédiaire du navigateur de code de Pharo, qui est pour le moins impressionnant.

À noter que l'ajout d'attribut au script nécessite toujours l'utilisation du navigateur de code de Pharo. Ce besoin est nécessaire uniquement lorsque le script a un état dont il doit se souvenir tout au long du cycle de vie de la figure.

Le manuel utilisateur a une section dédiée au script.

Inspecteur sur code de figures programmées

Une figure programmée est l'autre forme d'utilisation de la programmation dans la géométrie dynamique. Dans cette approche la figure géométrique est entièrement définie par un code Smalltalk et l'utilisation de l'API dédiée.

Il est dorénavant plus aisé de gérer ses fichiers de figures programmées. Le nouvel inspecteur de Pharo — outre l'inspection d'attributs d'instance de classe — propose aussi de voir, d'exécuter, d'éditer et de créer les scripts de figures programmées.

Zoom positionnel

Pour zoomer dans une figure l'utilisateur dispose du widget de molette orange en haut à droite de chaque figure ou de la molette de la souris. Le zoom par la souris est maintenant positionnel, focalisé sur la position du curseur souris ; celui par le widget reste, lui, centré au milieu de la zone visible de la figure.

Détection de polygone sans surface

Lorsqu'un polygone est sans surface (vide), Dr. Geo ne détectera que ses lignes, et non plus sa surface intérieure puisqu'elle n'existe pas.

Tests unitaires basés sur figures programmées

Le petit corpus de figures programmées distribué avec Dr. Geo est également utilisé pour définir une série supplémentaire de tests unitaires.

Partage réseau

Dans le cadre d'une activité pédagogique en salle informatique, distribuer aux élèves des fichiers de figures est pratique. Dr. Geo propose maintenant une fonctionnalité de partage en réseau local, indépendante des services du réseau local (NFS, Samba, Windows, etc.). La marche à suivre est la suivante :

- L'enseignant sauve les documents à partager dans son dossier DrGeo.app/MyShares :

- L'enseignant active le partage réseau local depuis le navigateur de préférences de DrGeo (menu Système, Préférences) :

- L'élève, depuis l'outil habituel d'ouverture de figures, parcourt les figures partagées (bouton 'Partage enseignant') :

Cette fonctionnalité peut s'utiliser de façon croisée avec Linux, Mac et Windows.

Thèmes graphiques

Le navigateur de préférences (menu Système, Préférences) donne accès à deux thèmes graphiques, hérités de Pharo :

Thème sombre, par défaut, à privilégier lorsque Dr. Geo est utilisé de façon autonome sur un seul poste.

Thème clair, à utiliser en vidéo projection, par exemple, car le thème sombre manque de contraste.

Option plein écran

Depuis le menu système, l'utilisateur peut basculer en affichage plein écran ; le système hôte est alors complètement masqué. Pratique pour que les élèves se concentrent sur leur activité de géométrie dynamique.

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Faille Lazy FPU state restore

Intel est de nouveau confronté à la découverte d’une faille, le Lazy FPU State Restore flaw.

Cette fois, seule la famille des Intel Core serait concernée.- lien n°1 : Explication des inventeurs

- lien n°2 : La mécanique Lazy FPU state restore expliquée par les équipes NetBSD

- lien n°3 : Le message de Linus lors du passage en mode eager

- lien n°4 : Annonce officielle de FreeBSD

Sommaire

Le FPU

Le FPU, c’est le bordel, par Ingo Molnar

L’unité de calcul en virgule flottante, le FPU, possède une série de registres qui lui permet de « définir » son état courant. Lors du basculement d’une tâche à une autre (context switching), cet état est alors restauré pour retrouver un contexte correspondant au processus en cours. Ces opérations peuvent être coûteuses car les registres du FPU sont plus gros que les autres, c’est pourquoi les FPU fournissent une option pour désactiver toute opération en virgule flottante (

CR0:TS). Aussi, dès qu’un calcul en virgule flottante est appelé, une exception est lancée pour « réveiller » le FPU avant de lancer l’opération normalement.

Lorsque cette exception (fpudna, FPU Device Not Available) se produit, un « gestionnaire de contexte FPU » vérifie quel processus a la main sur le FPU à ce moment‐là.

S’il s’agit d’un autre processus, il procède à la sauvegarde puis la restauration des registres, ou s’il s’agit d’un nouveau contexte, la sauvegarde puis le nettoyage des registres ; sinon, il ne fait rien : c’est le mode « paresseux » (lazy). À la sortie du processus, il ne faut pas oublier de « nettoyer » ces tables et de (re)lever tous les drapeaux liés à cette exception.En mode eager (zélé, volontaire), la sauvegarde et restauration des registres associés au FPU est effectuée quoiqu’il advienne, au moment du changement de tâche et non durant l’exécution de la tâche qui vient de prendre la main.

Le bâton

Au fil des années, les processeurs ont multiplié les registres pour prendre en charge les instructions de type SIMD, soit une instruction capable de procéder au même calcul sur un ensemble de paires de données.

Les registres

SSE,AVXetMMXrestent associés au FPU et seront donc intégrés au mécanisme de sauvegarde et restauration… et ils peuvent contenir jusqu’à 2 048 bits de données, rien que sur l’AVX.[ 0.000000] Linux version 4.14.48-intel-pk-standard (oe-user@oe-host) (icc version 18.0.2 (gcc version 7.3.0 compatibility)) #2 SMP PREEMPT Wed Jun 20 13:21:48 UTC 2018 [ 0.000000] x86/fpu: Supporting XSAVE feature 0x001: 'x87 floating point registers' [ 0.000000] x86/fpu: Supporting XSAVE feature 0x002: 'SSE registers' [ 0.000000] x86/fpu: Supporting XSAVE feature 0x008: 'MPX bounds registers' [ 0.000000] x86/fpu: Supporting XSAVE feature 0x010: 'MPX CSR' [ 0.000000] x86/fpu: xstate_offset[3]: 576, xstate_sizes[3]: 64 [ 0.000000] x86/fpu: xstate_offset[4]: 640, xstate_sizes[4]: 64 [ 0.000000] x86/fpu: Enabled xstate features 0x1b, context size is 704 bytes, using 'compacted' format.Pour se faire battre

Par le biais désormais connu de l’exécution spéculative puis de l’analyse de cache, un attaquant pourra lire ces registres depuis un autre processus, voire depuis une machine virtuelle. En effet, en mode lazy la sauvegarde des registres d’une tâche s’effectue au cours de l’exécution d’une autre tâche. La spéculation ignorant le drapeau

CR0:TS, tout est alors possible.Ces registres peuvent contenir des informations sensibles comme des clefs de chiffrement (AES), par le biais des instructions d’accélération matérielle AES-NI.

Delivers Fast, Affordable Data Protection and Security. AHeum.

Colin Percival, ex‐membre de l’équipe sécurité de FreeBSD, a codé un exploit en quelques heures et note, dans un tweet :

« You need to be able to execute code on the same CPU as the target process in order to steal cryptographic keys this way. You also need to perform a specific sequence of operations before the CPU pipeline completes, so there’s a narrow window for execution. »

« Vous devez être en mesure d’exécuter le code de [l’exploit] sur le même processeur que celui de la cible pour voler les clefs de cette manière. Vous devrez en outre appliquer une suite précise d’opérations avant que la chaîne de traitement du processeur ne se termine ; de fait, la fenêtre de tir est très étroite. »

Ce qui semble vouloir dire que, pour l’instant, coder le vol de données depuis un script venu du Web n’est pas simple à réaliser. Le temps nécessaire au vol des données des registres est la clef de l’attaque. Il faut le terminer avant que le séquenceur ne préempte la victime et que les valeurs des registres ne soient modifiées.

Pour y arriver, les chercheurs ont utilisé plusieurs méthodes :

Exception

Il s’agit de coder la fuite de données à l’ombre d’une exception, sciemment provoquée, tel un

page fault, par exemple. Mais il s’avère que cette solution est trop lente pour récupérer tout un jeu de registres.Intel TSX

Cette mécanique n’est disponible que sur les architectures récentes (à partir de Haswell), ce qui limite l’angle d’attaque. Cette technologie comporte un jeu d’instructions appelé RTM (Restricted Transactional Memory) qui permet d’annuler un bloc d’exécution en cas d’interruption ; il suffit d’y encadrer le code malicieux, qui va innocemment faire appel au FPU, pour lever l’exception

fpudna… Ce serait presque « étudié pour ».Retpoline

Il s’agit au départ d’une contre‐mesure pour Spectre. Elle vise à fourvoyer sciemment le processeur sur l’adresse de retour d’un

RETen plaçant une « fausse » boucle et donc le forcer à exécuter de manière spéculative un code innocent. Le code malicieux sera donc placé à cet endroit.Les correctifs

Le mode lazy semble moins pertinent aujourd’hui. Les gains en performance sont faibles avec les architectures récentes et, surtout, selon les usages actuels. Le FPU étant même beaucoup plus utilisé dans nos logiciels, son usage serait contre‐productif.

En effet, les compilateurs choisissent d’appeler les instructions SIMD (i.e.-sse) pour optimiser le code des logiciels. De fait, ceux‐ci auront de toute façon sauvegardé et restauré les registres du FPU à chaque changement de contexte. La gestion de l’exception sera inutile et va juste alourdir le processus. En outre, l’empreinte d’une sauvegarde et restauration serait moindre que celle de la gestion des drapeaux, des registres et de leurs états suite à l’interruption, le transfert de registres FPU en mémoire étant plus rapide car optimisé.Il est donc préconisé d’éviter le mode lazy au profit du mode eager.

- Linux propose le mode eager plutôt que le mode lazy depuis la version 3.7 et l’active par défaut depuis la version 4.9 ;

- ajoutez

eagerfpu=onsur la ligne de démarrage pour les versions antérieures à la 4.9 ; - FreeBSD a poussé un correctif pour la Release 11.2 ; c’est un FreeBSD 11.1 qui a servi de cobaye ;

- DragonFly BSD a poussé un correctif dans la version 5.2.2 ;

- Microsoft poussera un correctif en juillet ;

- OpenBSD a poussé un correctif le 14 juin pour la version 6.3 ;

- NetBSD a poussé un correctif le 16 juin sur

MAIN; - Illumos a poussé un correctif le 19 juin.

Conclusion

Ils ne sont pas à la fête cette année, chez Intel. Le point positif est que la correction de cette faille devrait conduire à une amélioration des performances, voire de la consommation d’énergie.

Theo de Raadt avait prévenu 11 ans auparavant que l’architecture Intel Core 2 promettait ce genre de faille :

« These processors are buggy as hell, and some of these bugs don’t just cause development/debugging problems, but will ASSUREDLY be exploitable from userland code. »

« Ces processeurs sont bogués comme jamais et nombre de ces bogues ne provoquent pas seulement des soucis de développement et d’analyse, mais ils vont assurément être exploitables depuis l’espace utilisateur. »

Pour la petite histoire, l’embargo s’est terminé le 6 juin. Colin Percival, qui assistait à une conférence de Théo de Raadt lors de la BSDCan 2018, a codé un exploit dans la foulée, qu’il n’a pas encore rendu public. Mais il a convaincu Intel de lever l’embargo au plus vite.

Il est notable qu’aucun des deux n’avait été mis dans la confidence ; OpenBSD signale même qu’ils en ont fait la demande (des rumeurs circulaient autour d’une énième version de Spectre), mais sans obtenir de réponse.Invitation to Embargo? No.

We asked.

No reply.Commentaires : voir le flux atom ouvrir dans le navigateur

-

Lazy FPU state restore

Intel est de nouveau confronté à la découverte d'une faille, le

Lazy FPU State Restore flaw.

Cette fois, seule la famille des intel core serait concernée.- lien n°1 : Explication des inventeurs

- lien n°2 : La mécanique Lazy FPU state restore expliquée par les équipes NetBSD

- lien n°3 : Le message de Linus lors du passage en mode eager

Sommaire

Le FPU

L'unité de calculs flottants, le FPU, possède une série de registres qui lui permet de définir son état courant.

Lors du basculement d'une tâche à une autre ( context switch), cet état est alors restauré pour retrouver un contexte correspondant au processus en cours.Ces opérations peuvent être coûteuses car les registres sont plus gros que ceux du CPU, c'est pourquoi les FPU fournissent une option pour désactiver toute opération flottante (

CR0:TS) ; aussi, dès qu'un calcul flottant est appelé une exception est lancée pour réveiller le FPU avant de lancer l'opération normalement.

Lorsque cette exception (fpudna, FPU Device Not Available) se produit, un gestionnaire de contexte fpu vérifie quel processus a la main sur le FPU à ce moment-là.

S'il s'agit d'un autre processus, il procède à la sauvegarde puis restauration des registres, ou s'il s'agit d'un nouveau contexte, la sauvegarde puis nettoyage des registres ; sinon, il ne fait rien : c'est le mode «paresseux» (lazy). À la sortie du processus, il ne faut pas oublier de nettoyer ces tables et de (re)lever tous les drapeaux liés à cette exception.En mode

eager(zélé, volontaire), la sauvegarde/restauration des registres associés au FPU est effectuée quoiqu'il advienne, au moment du changement de tâche et non durant l'exécution de la tache qui vient de prendre la main.Le bâton

Au fil des années, les processeurs ont multiplié les registres pour prendre en charge les instructions de type SIMD, soit une instruction capable de procéder au même calcul sur un ensemble de paires de données.

Les registres

SSE,AVXetMMXrestent associés au FPU et seront donc intégrés au mécanisme de sauvegarde/restauration…

… et ils peuvent contenir jusqu'à 2Kb de données, rien que sur l'AVX.[ 0.000000] Linux version 4.14.48-intel-pk-standard (oe-user@oe-host) (icc version 18.0.2 (gcc version 7.3.0 compatibility)) #2 SMP PREEMPT Wed Jun 20 13:21:48 UTC 2018 [ 0.000000] x86/fpu: Supporting XSAVE feature 0x001: 'x87 floating point registers' [ 0.000000] x86/fpu: Supporting XSAVE feature 0x002: 'SSE registers' [ 0.000000] x86/fpu: Supporting XSAVE feature 0x008: 'MPX bounds registers' [ 0.000000] x86/fpu: Supporting XSAVE feature 0x010: 'MPX CSR' [ 0.000000] x86/fpu: xstate_offset[3]: 576, xstate_sizes[3]: 64 [ 0.000000] x86/fpu: xstate_offset[4]: 640, xstate_sizes[4]: 64 [ 0.000000] x86/fpu: Enabled xstate features 0x1b, context size is 704 bytes, using 'compacted' format.Pour se faire battre

Par le biais désormais connu de l’exécution spéculative puis de l'analyse de cache, un attaquant pourra lire ces registres depuis un autre processus, voire, depuis une machine virtuelle. En effet, en mode

lazyla sauvegarde des registres d'une tâche s'effectue au cours de l'exécution d'une autre tâche. La spéculation ignorant le drapeauCR0:TS, tout est alors possible.Ces registres peuvent contenir des informations sensibles comme des clefs de chiffrement (AES), par le biais des instructions d'accélération matérielle AES-NI.

Delivers Fast, Affordable Data Protection and Security. AHeum.

Colin Percival, ex membre de l'équipe sécurité de FreeBSD, a codé un exploit en quelques heures et note, dans un tweet :

You need to be able to execute code on the same CPU as the target process in order to steal cryptographic keys this way. You also need to perform a specific sequence of operations before the CPU pipeline completes, so there’s a narrow window for execution

Vous devez être en mesure d'exécuter le code [de l'exploit] sur le même CPU que celui de la cible pour voler les clefs de cette manière. Vous devrez en outre appliquer une suite précise d'opérations avant que la chaîne de traitement du CPU ne se termine ; de fait, la fenêtre de tir est très étroite.

Ce qui semble vouloir dire que, pour l'instant, coder le vol de données depuis un script venu du Web n'est pas simple à produire. Le temps nécessaire au vol des données des registres est la clef de l'attaque. Il faut le terminer avant que le séquenceur ne préempte la victime et que les valeurs des registres ne soient modifiées.

Pour y arriver, les chercheurs ont utilisé plusieurs méthodes:

- Exception

Il s'agit de coder la fuite de données à l'ombre d'une exception, sciemment provoquée, tel un

page faultpar exemple. Mais il s'avère que cette solution est trop lente pour récupérer tout un jeu de registres.- Intel TSX

Cette mécanique n'est disponible que sur les architectures récentes (à partir de Haswell) ce qui limite l'angle d'attaque. Cette technologie comporte un jeu d'instructions appelé

RTM(Restricted Transactional Memory) qui permet d'annuler un bloc d'exécution en cas d'interruption ; il suffit d'y encadrer le code malicieux, qui va innocemment faire appel au FPU, pour lever l'exceptionfpudna… Ce serait presque « étudié pour ».- Retpoline

Il s'agit au départ d'une contre-mesure pour spectre.

Elle vise à fourvoyer sciemment le CPU sur l'adresse de retour d'unRETen plaçant une fausse boucle et donc le forcer à exécuter de manière spéculative un code innocent. Le code malicieux sera donc placé à cet endroit.Les correctifs

Le mode

lazysemble moins pertinent aujourd'hui. Les gains en performance sont faibles sous les architectures récentes et surtout selon les usages actuels ; voire, le FPU étant beaucoup plus utilisé dans nos logiciels, son usage serait contre-productif.

En effet, les compilateurs choisissent d'appeler les instructions SIMD (i.e.-sse) pour optimiser le code des logiciels. De fait, ceux-ci auront de toute façon sauvegardé et restauré les registres du FPU à chaque changement de contexte. La gestion de l'exception sera inutile et va juste alourdir le processus.

En outre, l'empreinte d'une sauvegarde/restauration serait moindre que celle de la gestion des drapeaux, des registres et de leurs états suite à l'interruption, le transfert de registres FPU en mémoire étant plus rapide car optimisé.Il est donc préconisé d'éviter le mode

lazyau profit du modeeager.-

Linux propose le mode

eagerplutôt que le modelazydepuis la version 3.7 et l'active par défaut depuis la version 4.9.- Ajoutez

eagerfpu=onsur la ligne de démarrage pour les versions antérieures à la 4.9.

- Ajoutez

FreeBSD a poussé un patch pour la Release 11.2. C'est un FreeBSD 11.1 qui a servi de cobaye ;

DragonFly BSD a poussé un patch dans la version 5.2.2 ;

Microsoft poussera un patch en juillet ;

OpenBSD a poussé un patch le 14 juin pour la version 6.3 ;

NetBSD a poussé un patch le 16 Juin sur

MAIN.

Conclusion

Ils ne sont pas à la fête cette année, chez Intel. Le point positif est que la correction de cette faille devrait conduire à une amélioration des performances, voire de la consommation d'énergie.

Theo de Raadt avait prévenu 11 ans auparavant que l'architecture Intel Core2 promettait ce genre de faille :

These processors are buggy as hell, and some of these bugs don't just

cause development/debugging problems, but will ASSUREDLY be

exploitable from userland code.Ces processeurs sont bugués comme jamais et nombre de ces bugs ne provoquent pas seulement des soucis de développement et d'analyse, mais ils vont assurément être exploitables depuis l'espace utilisateur.

Pour la petite histoire, l'embargo s'est terminé le 6 Juin.

Colin Percival, qui assistait à une conférence de Théo de Raadt lors de la BSDCan 2018, a codé un exploit dans la foulée, qu'il n'a pas encore rendu public. Mais il a convaincu Intel de lever l'embargo au plus vite.

Il est notable qu'aucun des deux n'avait été mis dans la confidence ; OpenBSD signale même qu'ils en ont fait la demande ( des rumeurs circulaient autour d'une énième version de spectre) mais sans obtenir de réponse.Invitation to Embargo? No.

We asked.

No reply.Commentaires : voir le flux atom ouvrir dans le navigateur

-

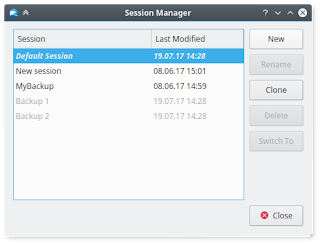

RyDroid Web Proxy (1.0) : outil de capture de sessions Web

Pendant l’année scolaire 2016-2017, j’étais en dernière année d’école d’ingénieurs

(l’ENSICAEN). J’ai donc fait un stage de fin d’études (à Orange, en France), avec le rapport qui va avec. J’ai fait un logiciel libre qui a été publié. En conséquence, il m’a paru logique de publier mon rapport, après avoir enlevé quelques parties (remerciements, présentation du collectif de production, conclusion personnelle, etc.) et fait de petites retouches pour qu’il soit cohérent avec ce nouveau format et la visibilité qui va avec. Cela permet de présenter plus largement ce que j’ai fait, tout en expliquant le pourquoi et comment, ce qui pourrait servir à d’autres personnes.- lien n°1 : Présentation de RyDroid Web Proxy sur mon site Web

- lien n°2 : Dépôt Git sur l’instance GitLab d’OW2

- lien n°3 : Dépôt Git sur GitLab.com

- lien n°4 : Site Web du projet CLIF

- lien n°5 : Paquet Debian

Sommaire

- Le sujet

- État de l’art

-

La réalisation du projet

- Les outils utilisés

-

Le résultat

- Comparaison avec un proxy classique

- « Proxifier » une URL

- Récupérer une ressource Web

- La gestion du HTML

- La gestion du CSS

- La gestion du HTTP

- Gérer les formulaires Web

- La gestion du JavaScript

- La configuration

- Enregistrement des données

- Conversion des données

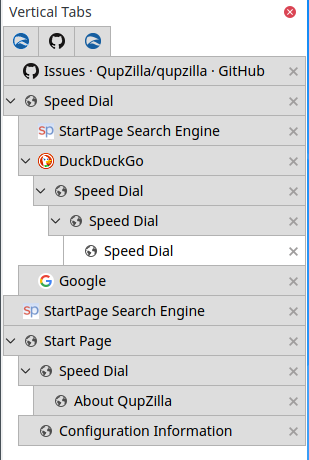

- L’API Web

- L’interface graphique

- L’installation facile

- Le paquet Debian

- Possibilités pour améliorer les performances

- Et après ?

- Pourquoi ce nom ?

- Conclusion

Le sujet

Celui qui a été mon tuteur de stage participe activement au développement d'un outil de test de performance à travers le réseau, qui s'appelle CLIF et qui est présenté plus loin dans cet article. Le cas le plus courant est le test pour le web, avec le protocole HTTP et sa version chiffrée HTTPS. Pour faciliter l'usage pour ce cas commun, il faut que créer un scénario de test pour ce dernier soit aisé.

Il existait déjà une solution : un proxy pouvait être configuré dans le navigateur web pour intercepter les flux réseaux et ainsi enregistrer les informations pertinentes dans le format adéquat (basé sur XML) pour rejouer une session web avec CLIF. Configurer un proxy dans un navigateur web peut être difficile pour certaines personnes ou perçu comme tel. De plus, le proxy ne gère pas le HTTPS (qui est de plus en plus courant), bien qu'il aurait été possible d'en ajouter la gestion, cela aurait nécessité d'ajouter un certificat dans le navigateur web. Mon tuteur voulait un outil plus simple à utiliser et qui gèrent le HTTPS, d'où ce stage.

Comme CLIF, l'outil réalisé devait être du logiciel libre sous licence GNU LGPL en version 3.

État de l’art

Outils de test de charge

La liste n'est pas exhaustive, mais il y a un article sur Wikipédia en anglais si on en désire une qui cherche à l'être. Cette partie a pour intérêt de présenter rapidement des outils cités plus loin dans l'article présent et de mettre en perspective le programme de mon tuteur de stage.

Apache JMeter

JMeter est un logiciel libre de la fondation Apache. Il est très populaire et packagé par au moins Debian et Trisquel GNU/Linux. Pour définir un test de charge, il faut lui soumettre un fichier XML. Il est extensible avec des modules complémentaires.

Gatling

Gatling est un logiciel de test de charge, avec un focus sur les applications web. Il est sous licence Apache 2.0, donc libre. Il est écrit en Scala. Il est packagé par au moins Debian et Trisquel GNU/Linux.

Selenium

Selenium est un logiciel pour automatiser la navigation web à travers un navigateur web. Il peut donc servir à faire des tests, mais aussi automatiser des tâches administratives se faisant via le Web. Il est libre via la licence Apache 2.0.

Tsung

Tsung est un logiciel de test de charge distribué. Il gère différents protocoles (dont HTTP, XMPP, LDAP, et MQTT). Il est libre sous licence GNU GPL version 2.0. Le langage de programmation utilisé est Erlang. Il prend en entrée un fichier XML. Il est disponible sous forme de paquet dans au moins Trisquel GNU/Linux et Debian.

Locust

Locust a la particularité d'utiliser des scripts en Python pour définir le comportement des utilisateurs virtuels, alors que les autres outils utilisent généralement du XML et/ou une interface graphique. C'est un logiciel libre sous licence "MIT".

The Grinder

The Grinder est un framework pour le test de charge. Il est adapté pour le test distribué sur plusieurs machines. Il est libre et écrit en langage Java.

Taurus

Taurus a pour but de cacher la complexité des tests fonctionnels et de performance. Il fait cela en étant une enveloppe pour JMeter, Gatling, Locust, Grinder, et Selenium WebDriver. Il prend en entrée un fichier au format YAML. C'est un logiciel libre sous licence Apache 2.0.

CLIF

CLIF est un logiciel libre initié, piloté, et maintenu par celui qui a été mon tuteur de stage (Bruno Dillenseger). C'est un acronyme récursif pour "CLIF is a Load Injection Framework". Ce projet est hébergé par le consortium OW2. Il est écrit dans le langage de programmation Java. Il a une interface en ligne de commande et une interface graphique sous forme de module complémentaire pour Eclipse. Il propose plusieurs manières de définir un test de charge, comme cela est expliqué dans une sous-sous-section (de cet article) partiellement dédiée. Il n'y a pas de paquet Debian, notamment à cause des nombreuses dépendances et d'au moins une dont les sources n'auraient pas été retrouvées.

CLIF permet de déployer des injecteurs de requêtes répartis pour mesurer les temps de réponse. Il permet également de déployer des sondes afin de mesurer la consommation des ressources (processeur, réseau, mémoire, disque, etc.). Son environnement de scénario ISAC offre une façon formelle de définir les scénarios sous forme de comportements d'utilisateurs virtuels et d'une spécification du nombre d'utilisateurs virtuels actifs de chaque comportement au cours du temps. CLIF a été spécialement conçu pour être rapidement adaptable à toute sorte de cas de test (un assistant Eclipse permet de définir ses propres modules complémentaires pour intégrer de nouveaux protocoles ou de nouveaux jeux de données), y compris des hauts niveaux de charge (comme des centaines d'injecteurs et des millions d'utilisateurs virtuels). En pratique, CLIF est utilisé pour des tests de tenue en charge, mais également pour des tests fonctionnels, des tests en intégration continue et de la supervision de qualité d'expérience utilisateur, notamment via son module complémentaire pour Jenkins.

Le code source est sur l'instance GitLab de OW2, à part le module complémentaire pour Jenkins qui est sur GitHub. CLIF est aussi disponible sur la forge historique de OW2 (qui propose des versions compilées).

Loads et Molotov

Loads et Molotov sont libres et écrits en langage Python. Ils permettent d'écrire des tests unitaires. Loads est développé et testé sur Python 2.6 et 2.7, tandis que Molotov nécessite Python 3.5 ou plus.

HPE LoadRunner

HPE LoadRunner est un logiciel privateur de test de charge, qui ne fonctionne complètement que sous Microsoft Windows. Il peut être étendu via des formats d'autres outils (comme JMeter) et des scripts dans différents langages (comme C et Java). Sa première version date de l'an 2000, il est depuis toujours amélioré, ce qu'il lui a permis d'acquérir une place importante dans le domaine du test de charge.

megaLOAD

megaLOAD est présenté comme étant une plateforme en ligne de test de charge qui serait facile à utiliser et capable de monter à l'échelle. Il aurait été spécialement créé pour tester les services de type back-end ayant vocation à être très robustes. Il est fait par Erlang Solutions. Il gère HTTP et serait suffisamment extensible pour gérer n'importe quel protocole. Il serait possible de l'utiliser via un navigateur web et/ou une interface de programmation RESTful. Il est disponible sur AWS (Amazon Web Services).

Siege

Siege est un outil libre pour tester la capacité de charge des implémentations des protocoles HTTP(S) (version 1.0 et 1.1) et FTP. Il est écrit en langage C et fonctionne sur divers systèmes d'exploitation POSIX (comme GNU/Linux et des BSD récents, mais pas Windows). Il est libre sous la licence GPL en version 3.0.

Outils de capture d’utilisation Internet

Différentes organisations proposent des services web pour l'injection de charge. Certaines d'entre elles proposent un outil pour facilement capturer une session d'usage du réseau, ce qui permet ensuite de la rejouer facilement.

On pourrait naïvement penser que tcpdump, Wireshark, ou Scapy sont de bons candidats sans rien faire. Ce serait vrai si les communications passaient toutes, ou au moins une vaste majorité, en clair sur les réseaux et que cela n'était pas amené à changer. En effet, elles sont de plus en plus chiffrées (avec une accélération depuis 2013 suite aux révélations d'Edward Snowden), ce qui permet de "garantir" (par les mathématiques) la confidentialité de ce qui est chiffré (il y aura toujours un minimum de méta-données non chiffrées). Il faut donc trouver un moyen de contourner le chiffrement quand il y en a, ce que tcpdump, Wireshark, et Scapy ne font pas automatiquement. De plus, ces derniers montrent une quantité de détails techniques inutiles pour l'individu (dans notre contexte) et qui pourraient le perturber (par peur de l'inconnu et/ou difficulté à percevoir ce qui est pertinent).

NeoLoad

NeoLoad Recorder est une application qui enregistre un parcours utilisateur fait à travers un proxy. Pour cela, il crée un proxy sur la machine sur laquelle il est exécuté. Ensuite, il génère un certificat X.509 qui va servir à déchiffrer les échanges chiffrés via TLS. Puis, il démarre Firefox dans lequel il faut configurer le proxy et ajouter le certificat si on souhaite enregistrer les communications chiffrées via TLS. Après cela, il n'y a plus qu'à naviguer. Une fois que l'on veut arrêter, il faut penser à enlever le proxy (mais on s'en rendra vite compte si on oublie), et ne plus faire confiance au certificat (ce qui ne sera rappelé par aucune erreur).

Cette solution technique est problématique si on doit passer par un proxy pour accéder à un réseau sur lequel le site web à tester est accessible. Techniquement, il est écrit en Java. Les données sont enregistrées dans un format inconnu et non trivial.

HPE StormRunner Load

HPE StormRunner Load est un service distant pour faire du test de charge et en analyser les résultats. Il est basé sur du logiciel privateur et se manipule via une interface web. Pour faciliter son usage, divers outils (non libres) sont mis à disposition.

Pour rendre aisé la capture de la navigation web, il propose 2 outils : TruClient Lite et TruClient Standalone. Ils ont pour but de capturer (directement) ce qui se passe dans un navigateur web (donc sans proxy externe et sans certificat pour le HTTPS). TruClient Lite est un module complémentaire pour Chromium (et donc son principal dérivé Google Chrome), qui utilise les paramètres de proxy du navigateur web. TruClient Standalone est un logiciel (fonctionnant uniquement sur Windows) qui peut au choix se baser sur les moteurs de Firefox (Gecko), Chromium, ou Internet Explorer, mais également simuler un mobile ou une tablette (en configurant correctement la résolution du navigateur web et son agent utilisateur), il prend les contrôles sur le proxy du navigateur web. L'absence de contrôle sur le proxy est problématique si on doit passer par un proxy pour quitter un réseau interne, mais il est possible de lui indiquer un proxy après que le script soit généré. Ils enregistrent les clics sur les boutons avec leurs intitulés (même s'ils ne sont pas des liens), et se basent sur l'intitulé des boutons pour naviguer et pas sur les URLs, ce qui est pratique si les références des liens changent. Ils permettent également de rejouer (automatiquement) un script enregistré avec une visualisation graphique, cependant ils sont perdus s'ils essayent de rejouer mais que le texte du bouton n'est pas le même (par exemple à cause de la langue par défaut différente en fonction du navigateur web).

BlazeMeter

BlazeMeter est une plateforme SaaSS web. Il peut réaliser des tests de charge et montrer des statistiques (en temps réel) qui en résultent. Il propose une API web pour automatiser les tests, par exemple dans le cadre de l'intégration continue (via Jenkins ou un autre outil similaire). Il utilise divers logiciel libres (dont JMeter, Gatling, et Taurus) et gère donc leurs formats de données.

Pour simplifier les tests web, un outil de capture de session web est proposé, BlazeMeter Proxy Recorder. C'est malheureusement du logiciel privateur. On peut le tester gratuitement pendant 1 mois. Pour l'utiliser, il faut s'inscrire et l'activer. Ensuite, il faut aller dans son interface, ce qui crée un proxy (sans intervention du testeur ou de la testeuse) et un certificat X.509 (souvent appelé d'une manière réductrice certificat TLS). Pour enregistrer ce que l'on fait via un client web, il faut activer le proxy (via un simple bouton) et configurer ce dernier dans notre client web. S'il l'on souhaite que les communications chiffrées soient enregistrées, il faut ajouter un certificat qui va permettre au proxy de déchiffrer avec une de ses clés privées (au lieu d'une clé privée du service web consulté). Au fur et à mesure de la navigation (via le proxy), l'interface graphique de BlazeMeter Recorder montre ce qu'il a capturé. Pour finaliser une session, il suffit de cliquer sur un bouton (de l'interface web). On peut ensuite avoir le résultat sous divers formes (URL pour BlazeMeter, fichier JMeter, fichier pour Selenium WebDriver, ou fichier pour Taurus).

SOASTA Cloud Test

SOASTA Cloud Test est un SaaSS web pour le test de charge et l'analyse des données (en temps réel) qui en sont issues. Parmi les analyses qu'il propose, il a l'originalité de proposer une comparaison du temps de chargement et du revenu généré sur une période. Il permet de choisir où seront géographiquement les utilisateurs virtuels d'un test. Il propose une interface en 3 dimensions avec les flux réseaux qu'il génère sur une carte de la Terre, dont l'intérêt est probablement discutable, mais cela peut être pertinent pour se faire payer le service par un·e commercial·e. Il peut importer des fichiers JMeter.

Contrairement à certains de ses concurrents, son outil de capture d'usage du réseau fonctionne sur plusieurs protocoles Internet (temps des connexions TCP, DNS, TLS, HTTP, etc.). C'est une machine virtuelle (sous CentOS) qui fonctionne avec VMware Player, ce qui est très lourd (en termes de puissance de calcul, de mémoire vive, et de place dans la mémoire persistante puisque le disque de la machine virtuelle fait 15Go). Ce choix technique le réserve à des informaticien·ne·s ayant du temps ou des personnes ne voulant pas se limiter au Web.

La réalisation du projet

Les outils utilisés

Les outils pour le développement lui-même

- Système d'exploitation : Debian GNU/Linux 9 "Stretch" (qui devenu stable pendant mon stage, inclut PHP 7, et est vastement utilisé)

- Éditeur de code : GNU Emacs (parce qu'il ne nécessite pas de souris et qu'il est beaucoup plus léger qu'un environnement de développement intégré)

- Langage de programmation : PHP 7 (qui a une librairie standard fourni pour le Web, permet la déclaration de type sur tous les types non objets, et a des avantages de facilité d'installation pour les applications se basant dessus comme cela est expliqué dans la partie qui est dédiée à ce sujet)

Les outils pour gérer le développement

- Gestionnaire de versions : git ("le gestionnaire de contenu stupide" (d’après son manuel) est un logiciel libre de gestion de versions décentralisé, libre, performant, et populaire)

- Forges logicielles :