Linux (fr)

-

Migrer Windows 10 d'un disque BIOS/MBR, vers un SSD en mode UEFI/GPT avec des logiciels libres

(Journaux LinuxFR)

Sommaire

- Introduction

- Prérequis

- Nomenclature

- Procédure de base

- Quelques pistes si ça ne fonctionne pas…

- Documentation, pour aller plus loin…

- Historique de révisions

Introduction

Ce tutoriel vous guide pas à pas pour migrer votre installation de

Windows qui est actuellement sur un disque dur de votre PC vers un

nouveau disque, en l'occurrence un SSD. A vrai dire, vous pouvez aussi

bien migrer vers un autre HDD.La spécificité de ce tutoriel est qu'elle utilise les outils fournis par

Microsoft avec Windows ainsi que des logiciels libres (Clonezilla

principalement, mais si quelque chose devait mal tourner vous pouvez avoir

besoin d'utiliser fdisk, gdisk ou testdisk pour ne citer qu'eux). Quand

j'ai voulu faire cette migration je n'ai pas trouvé de tutoriel

expliquant de bout en bout comment faire cette migration juste avec les

outils de Microsoft et des logiciels libres.Typiquement, vous pouvez avoir envie/besoin de faire cela car vous avez

acheté un nouveau disque pour remplacer l'ancien (par exemple car

l'ancien montre des signes de faiblesse, ou vous voulez améliorer la

réactivité de votre système).En plus de la migration du système d'exploitation, ce tutoriel vous

explique comment passer d'un démarrage en mode BIOS/MBR à un démarrage

en mode UEFI/GPT.Succinctement la démarche est la suivante, d'abord installer le nouveau

disque dans le PC, et initialiser la table de partition selon les normes

Microsoft. Puis cloner/dupliquer la partition contenant le système

d'exploitation à l'aide de Clonezilla. Ensuite et avant de redémarrer

dans le clone de Windows sur le SSD, faire quelques modifications dans

le registre pour que la lettre de lecteurC:pointe vers la bonne

partition et éventuellement modifier le mode SATA en AHCI si vous le

modifiez aussi dans le UEFI/BIOS. Après cela, on va préparer la

partition système EFI/ESP pour que le PC puisse démarrer dessus et qu'il

démarre sur le Windows du SSD. Finalement, une fois dans le Windows du

SSD, on va réactiver l'"environnement de récupération de Windows".Mise en garde : Faites une sauvegarde de vos données avant toute

opération. Personne n'est à l'abri d'une mauvaise manipulation ou d'une

erreur.Prérequis

Compétences

Niveau de difficulté : Difficile.

Vous devez être à l'aise au niveau de l'utilisation de la ligne de

commande dans Windows, mais aussi assez à l'aise pour gérer les

partitions de votre disque. Savoir modifier le paramétrage de votre

Firmware UEFI/BIOS et aussi nécessaire. Ce tutoriel guide pas à pas pour

la majorité des opérations. Certaines n'ont pas été détaillées par souci

de simplicité et d'efficacité.Matériel

Le PC où vous voulez installer le SSD. Il faut qu'il soit en état de

marche. De plus il doit avoir un firmware UEFI. S'il n'a que un BIOS

standard, sans UEFI, ce tutoriel n'est pas adapté.Clé(s) USB ou plusieurs CD/DVD sur lequel vous aurez mis

Clonezilla, System rescue

CD et un environnement de démarrage

Windows PE, ou Windows RE, ou le DVD/Disque d'installation de Windows.Le disque SSD (testé avec Samsung SSD 860 EVO 250GB). Il doit avoir une

taille suffisante pour contenir votre partition de Windows. Dans tous

les cas, la taille de la partition qui contiendra Windows sur le SSD

doit être au moins égale à la taille de la partition Windows du HDD que

vous voulez cloner. Au besoin, pour remplir ce critère, réduisez la

taille de votre partition Windows avec le gestionnaire de disque de

Windows par exemple (ou un autre outil de gestion de partition, comme

gparted, sur le System Rescue CD). Cherchez sur internet si vous ne

savez pas comment faire.Logiciel

Windows 10 installé (en version 64 bits) (testé avec Win10 v1709)

Windows 10 PE ou support d'installation de Windows 10 (clé USB ou DVD) -

En Version 64 bits (testé avec un support d'installation de Win10 v1804)System rescue CD (version 5.2.2 par

exemple)Clonezilla installé sur une clé ou un CD.

Bien vérifier avant que votre système arrive à démarrer dessus. (Testé

avec Clonezilla 2.5.5-38)Nomenclature

SSD : désigne le nouveau SSD

HDD : désigne votre disque actuel, sur lequel est installé Windows

WinPE : un environnement de démarrage Windows PE, ou Windows RE, ou le

DVD/Disque d'installation de Windows. Il doit être sur un support

amovible (USB, CD ou DVD)S: La lettre de lecteur affectée à la partition Système EFI qui sera sur

le nouveau SSD (parfois appelée ESP, EFI_System_Partition ou encore

SYSTEM, ou EFI)N: Le clone de Windows, sur le SSD

O: Le Windows cloné, sur le HDD

C: La partition dans laquelle est installée Windows, lorsqu'on est dans

Windows (que ce soit le windows cloné, ou le clone)Les commandes doivent être lancées en tant qu'administrateur.

Procédure de base

Fixer et brancher le SSD dans l’ordinateur

Désactiver Windows FastStart (cf votre moteur de recherche préféré)

-

Initialiser et partitionner le disque à l'aide de Windows

- Démarrer sur le Windows installé ou WinPE

- Pour initialiser le disque, d'abord créer une table de partition,

puis partitionner le disque. Pour ce faire :

- Suivre les instructions de partitionnement UEFI/GPT selon Microsoft. Ci-dessous mon exemple, mais peut-être avez-vous besoin d'une partition "recovery" aussi, ou votre configuration nécessite quelques aménagements. Dans ce cas, voir les instructions de Microsoft et adapter pour vos besoins.

- Par exemple: une partition EFI de 260Mo, une partition

Microsoft Reserved (MSR) de 16Mo, une partition pour Windows

(taille au moins égale à la taille de la partition de Windows

à cloner). Pour informations, dans diskpart, les tailles que

vous donnez en MB/Mo sont en réalité des MiB/Mio (220 =

10242 octets).

- Ouvrir une invite de commande en mode administrateur et

lancer

diskpart

. Et une fois dans diskpart :

- list disk pour lister les disques et connaître le n° du SSD.

- select disk # avec le numéro du SSD à la place de #

- clean Supprime le contenu du disque / l'initialise

- convert gpt Définit que le disque aura une table de partition GPT

- create partition efi size=260 Crée une partition EFI de 260MiB

- format quick fs=fat32 label="System" Formater la partition EFI au format FAT32

- assign letter="S" Lui donner la lettre S

- create partition msr size=16 Créer une partition Microsoft Reserved de 16MiB

- create partition primary

Créer la partition pour Windows (l'équivalent du

C:) - format quick fs=ntfs label="Windows" Formater la partition pour Windows au format NTFS

- assign letter="N" Lui donner la lettre N

- list volume Liste les volumes. Permet de voir la table de partition.

- exit Quitte diskpart

- Ouvrir une invite de commande en mode administrateur et

lancer

diskpart

. Et une fois dans diskpart :

-

Cloner le Windows installé sur le HDD. Ceci sera fait à l'aide de

Clonezilla- Redémarrer dans Clonezilla

- Une fois dans clonezilla, et si vous êtes confortable avec les

lignes de commande Linux, éventuellement supprimer de la partition

Windows du HDD les fichiers

pagefile.sys,hyberfil.sys(désactiver windows faststart avant),swapfile.sys. - Cloner la partition Windows du HDD vers le SSD (de préférence,

partition de même taille, et de toutes façons, la partition de

destination doit être plus grande que la source. Si ce n'est pas

le cas, réduisez d'abord la taille de votre partition Windows

depuis Windows). Dans clonezilla, utiliser le mode Partition vers

Partition, et en mode Export. Utiliser les options

-e1 auto(automatically adjust file system geometry for a ntfs boot partition if exists)-e2(sfdisk uses CHS of hard drive from EDD (for non grub loader)-r(resize filesystem to fit partition size of target)-m(do NOT clone boot loader)-v(verbose) - Optionnellement cacher la partition contenant le windows source de la table de partition du disque source (si vous ne savez pas à quoi ça sert, passez votre chemin). Pour cela modifier le type de partition de la partition NTFS de windows (en principe, NTFS a un id de « 7 ». On peut utiliser id 17 pour la partition cachée : 17 correspond à « IFS Hidden »). Utiliser cfdisk ou fdisk pour faire ce changement (ce sont des programmes linux).

Dans le Firmware UEFI (ou BIOS-UEFI), on peut en profiter pour passer

du mode SATA "IDE" vers "AHCI". Windows n'aime pas ce changement et

il faut donc faire une opération dans le registre qui est

détaillée ci-dessous. Tant que vous ne le faites pas, vous aurez un

écran de plantage bleu de windows au démarrage (BSOD).Si vous voulez être sûr de ne pas faire de bêtise dans le Windows que

vous venez de cloner, je vous conseille d'éteindre l’ordinateur & de

débrancher l’ancien disque. Ainsi vous ne risquez pas de modifier le

mauvais fichier de registre (en l'occurrence celui de votre Windows

sur le HDD)-

Effectuer quelques opérations sur le Windows de destination (celui

sur le SSD) avant qu'on ne démarre dessus. En particulier corriger le

registre pour affecter la lettre de lecteur C: à la bonne partition,

et si le paramétrage du Firmware UEFI (BIOS-UEFI) a été modifié pour

passer de SATA Mode PCI vers AHCI, on va aussi faire ce changement

pour que ca fonctionne.- Redémarrer dans WinPE (en Mode UEFI, pas MBR !)

- Tout d'abord déterminer la lettre de lecteur affectée au clone

de Windows, celui qui est sur le SSD. Ou, s'il n'y a pas de

lettre affectée, lui en donner une, par exemple

N:(lettre utilisée dans les exemples qui suivent)- Pour cela, lancer dans

diskpart

- list volume

Ce qui retourne la liste des volumes avec la lettre de lecteur qui a été affectée à chacun.

- list volume

- Si aucune lettre de lecteur n'est affectée, il faut alors

lui en affecter une. Pour cela, lancer dans

diskpart

- select volume # (avec # étant le numéro du volume qui contient le nouveau windows)

- assign letter=N

S'il n'est pas possible d'utiliser select volume alors faire comme ceci - list disk

- select disk # (# étant le numéro affecté au SSD)

- list partition

- select partition # (# étant le numéro affecté à la partition de Windows sur le SSD, probablement 3)

- assign letter=N

- Pour cela, lancer dans

diskpart

- Faire un CHKDSK /F sur la lettre du nouveau Win

- Pour que la partition

C:utilisée par Windows soit celle du SSD et pas celle de l’ancien disque, modifier une clé de registre du nouveau Windows :- Lancer

REGEDIT

et dans le registre HKEY_LOCAL_MACHINE monter la ruche

N:\Windows\System32\Config\SYSTEM. Lui donner le nom "NewWin" On s’intéresse àHKEY_LOCAL_MACHINE\NewWin\MountedDevices. Ce sont là les valeurs qui sont dans le registre "HKEY_LOCAL_MACHINE\SYSTEM\MountedDevices" lorsqu'on est dans l'installation de Windows.- Dans

HKEY_LOCAL_MACHINE\NewWin\MountedDevicesmodifier la lettre de lecteur C: en renommant \DosDevices\C: par \DosDevices\O: (car la valeur fait référence à la partition de l'ancien Windows sur le HDD et on ne veut pas, en démarrant, utiliser cette partition mais celle de son clone qui est sur le SSD). Ainsi, lorsqu'on démarrera dans le nouveau Windows, la partition contenant le Windows sur le HDD aura la lettre O:, et la partition contenant le Windows sur le SSD aura la lettre C: - Créer une nouvelle valeur binaire nommée \DosDevices\C:

et lui donner comme contenu celui de \DosDevices\N: qui

est renseignée dans le registre WinPE, c'est-à-dire là

HKEY_LOCAL_MACHINE\SYSTEM\MountedDevices(C:étant la lettre qu'utilisait le Windows du HDD comme partition où il y a le dossier \Windows ) - ATTENTION: Bien vérifier que la copie a fonctionné et qu'il y a les bonnes valeurs, car dans mes essais, j'ai du m'y reprendre à 2 fois car le 1er "coller" ne collait pas ce que je voulais.

- En principe c'est tout. Mais d'après certaines sources,

il y aurait une clé \\?\Volume{GUID} ayant le même

contenu que le \DosDevices\O: qu’on vient de modifier.

Chez moi ce n'était pas le cas. Si vous avez une telle

valeur, alors il faut lui donner le contenu de

\DosDevices\N: depuis le registre WinPE

- Dans

- Lancer

REGEDIT

et dans le registre HKEY_LOCAL_MACHINE monter la ruche

- Si en même temps que la migration on veut aussi passer du mode

SATA IDE vers AHCI alors il faut encore faire ceci. Cela a été

repris du site

tomshardware.co.uk

- Toujours dans

REGEDIT

avec la ruche montée en

HKEY_LOCAL_MACHINE\NewWin - Aller à

HKEY_LOCAL_MACHINE\NewWin\ControlSet000\Services\storahci\StartOverride - Changer la valeur DWORD de 3 à 0.

- Au redémarrage, si ça n'a pas été fait, changer la paramétrage du contrôleur SATA de IDE à AHCI. Au redémarrage, Windows devrait directement démarrer correctement et sans plantage (BSOD).

- Toujours dans

REGEDIT

avec la ruche montée en

- Rendre le disque bootable en installant les outils EFI de

microsoft et configurant le Magasin BCD (BCD Store)

- D'abord assigner une lettre de lecteur à la partition ESP

- MOUNTVOL S: /S

Si ca n'a pas fonctionné, faire comme ceci dans diskpart - list disk

- select disk # (# est le numero du SSD retourné par list disk)

- list partition

- select partition # (# est probablement 1)

- assign letter=S

- MOUNTVOL S: /S

- Puis lancer

bcdboot

N:\windows /l fr-fr /s S: /f UEFI- Où

N:\Windowsest le répertoire contenant le clone de Windows sur le SSD) - S: = partition EFI

- Où

- D'abord assigner une lettre de lecteur à la partition ESP

- Tout d'abord déterminer la lettre de lecteur affectée au clone

de Windows, celui qui est sur le SSD. Ou, s'il n'y a pas de

lettre affectée, lui en donner une, par exemple

- Redémarrer dans WinPE (en Mode UEFI, pas MBR !)

Redémarrer, et avant le lancement de Windows vérifier votre UEFI

(ou BIOS-UEFI). Il faut qu'il soit configuré pour démarrer par défaut

en mode UEFI et pas en mode BIOS. Penser aussi à corriger le

paramétrage SATA si cela a été modifié dans le registre de Windows.

Le paramétrage du démarrage avecbcdboot N:\windows /l fr-fr /s S: /f UEFIa normalement créé le

magasin BCD, mis tous les fichiers EFI sur la partition SYSTEME (ESP,

partiton EFI, la 1ère du SSD) et dit au firmware UEFI qu'il doit

automatiquement démarrer avec le gestionnaire de démarrage

(boot manager) de Windows.-

Une fois qu’on a réussi à démarrer dans la copie de Windows

- Réactiver le "FastBoot"

- Réactiver l'environnement de récupération de Windows

en lançant, depuis une ligne de commande avec les droits

administrateur, la commande

reagentc.exe /enable. Vérifier avecreagentc.exe /info. Et s'il y a une erreur essayer avecreagentc.exe /enable /setreimage /path C:\Recovery\WindowsREoùC:\Recovery\WindowsREest le dossier où se trouve le fichierWinre.wim - Vérifier que tout est en ordre. Eventuellement donner un nouveau

nom à votre partition

C:(pour la différencier de celle sur le HDD) en lançant:LABEL [drive:][label] - Redémarrer encore une fois en laissant le processus de démarrage se faire tout seul pour vérifier que tout est ok.

Réinsérer l'ancien disque dur.

Normalement, il devrait être possible de redémarrer dans l'ancien

Windows, du moment que vous savez comment booter en MBR, et sous

réserve de ne pas avoir modifié le mode SATA dans le UEFI/BIOS. SI

c'est le cas, vous pouvez envisager de modifier le registre du

Windows du HDD, ou de modifier le paramétrage du UEFI/BIOS.

Si vous avez aussi Linux d'installé sur le HDD, il devrait toujours

être possible de le démarrer en mode BIOSOn peut diminuer/augmenter la taille de la partition C: du SSD (Pour

un SSD TLC ou VNAND, on peut par exemple laisser de l’espace libre à

la fin ~10 % de la capacité du disque d'après le logiciel Samsung

Magician, pour un SSD 860 EVO)En principe, puisqu’on boot en EFI on peut enlever sur le clone

Windows sur le SSD les fichiers\bootmgret\Boot\BCDpuisque ce

sont ceux qui étaient utilisés pour un boot en mode BIOS/MBR et que

désormais on est en EFI. Vous pouvez d'abord les renommer et vérifier

que ca ne change rien au prochain boot, plutôt que de les supprimer

tout de suite.

Quelques pistes si ça ne fonctionne pas…

- Faire un chkdsk sur la nouvelle partition

- Recréer le bootsector du NTFS avec testdisk (dispo sur System Rescue CD, mais peut être aussi dans Clonezilla ? Je n'ai pas vérifié)

- Vérifier le BCD:

- On peut vérifier si le Magasin BCD est ok en lançant (en

tant qu'administrateur)

bcdedit /store s:\EFI\Boot\Microsoft\BCD /enum

(Si la partition système n'est pas montée sur S:, lancer

Mountvol s: /s

- Doc BCDEDIT (sur la page, il y a aussi les liens vers bcdboot (initialise BCD et copie fichiers de démarrage sur la partition systeme) et bootsect (pour basculer entre NTLDR et Bootmgr)

- https://msdn.microsoft.com/fr-fr/library/windows/hardware/mt450468(v=vs.85).aspx

- https://docs.microsoft.com/en-us/windows-hardware/manufacture/desktop/bcd-system-store-settings-for-uefi

- On peut vérifier si le Magasin BCD est ok en lançant (en

tant qu'administrateur)

bcdedit /store s:\EFI\Boot\Microsoft\BCD /enum

(Si la partition système n'est pas montée sur S:, lancer

Mountvol s: /s

- Vérifier que la partition EFI est bien initialisée (présence des

fichiers

\EFI,\EFI\Boot\,\EFI\Microsoft\…) Si ce n'est pas le cas, il y a eu un problème avec bcdbootN:\windows /l fr-fr /s S: /f UEFI - Vérifier le boot manager du bios (démarrage en UEFI ou MBR ? Gestionnaire de démarrage par défaut ? Présence du gestionnaire de démarrage de Windows ?)

- A priori, pas utile : Commandes à lancer dans WinPE

- Pour recréer le boot sector de la partition systeme (EFI):

bootrec

/fixboot - Pour chercher les OS sur le disque et les mettre dans le

bootloader

bootrec

/scanos

- Pour recréer le boot sector de la partition systeme (EFI):

bootrec

- Quelques commandes de bcdedit pour modiser la valeur de certains

éléments du magasin BCD. Inutile car le BCD Store qui est utilisé

lorsqu'on démarre en mode EFI n'est pas le même que celui utilisé

dans un démarrage en mode MBR. Donc, pas besoin de chercher à

modifier le BCD. Je garde pour info : les lettres sont celles telles

que définies dans le système où on est (WinPE par ex).

Doc BCDEDIT

- bcdedit /set {bootmgr} device \Device\HarddiskVolume1

- bcdedit /set {default} device \Device\HarddiskVolume3

- bcdedit /set {default} osdevice \Device\HarddiskVolume3

- Ou à la place de \Device\HarddiskVolume1 mettre les lettres de lecteur :

- bcdedit /set {bootmgr} device partition=S:

- bcdedit /set {default} device partition=C:

- bcdedit /set {default} osdevice partition=C:

Documentation, pour aller plus loin…

A propos du EFI/UEFI:

- La procédure de Boot en cas UEFI ou BIOS est bien décrite ici: https://www.boyans.net/RepairWindows/RepairWindowsBCD.html

- La partition Système EFI: https://wiki.archlinux.org/index.php/EFI\_System\_Partition

- Managing EFI Boot Loaders for Linux: http://www.rodsbooks.com/efi-bootloaders/principles.html

A propos de l'entrée MountedDevices du registre:

http://diddy.boot-land.net/firadisk/files/mounteddevices.htmSi on veut y accéder, par défaut les fichiers du BCD sont cachés. Pour

les rendre visibles:- attrib bcd -s -h -r

- mv bcd bcd.bak

- bootrec /rebuildbcd

Documentation bcdedit:

- http://diddy.boot-land.net/bcdedit/

- Concernant les valeurs possibles pour « device » ou « osdevice » dans bcdedit http://www.diddy.boot-land.net/bcdedit/files/device.htm

MBR Partition ID

- NB: Une partition Recovery Windows a un part_id de « 0x27 »: https://www.win.tue.nl/~aeb/partitions/partition\_types-1.html

A propos des disk ID (=Disk signatures):

- http://kb.macrium.com/KnowledgebaseArticle50152.aspx . En principe pas de pb, puisqu’on n’a pas cloné tout le disque mais juste une partition, et que le pb de signature du disque est lié à la copie du MBR (1er secteur du disque {et pas de la partition}). Cela concerne probabement aussi le clonage de la table de partition GPT puisqu'il y a aussi un id dedans…

- Fixing Disk Signature Collisions: https://blogs.technet.microsoft.com/markrussinovich/2011/11/06/fixing-disk-signature-collisions/

Si besoin de supprimer du registre les entrées de disques qui ne sont

pas connectés ou sans lettre assignée lancer:mountvol /R. Ce

programme permet aussi de lister les lettres de volumes avec leur GUID

(GUID pour ce système uniquement, il n’est pas stocké dans la partition,

ni ailleurs sur le disque, il est assigné par windows pour un couple

(signature de disque/partition offset) dans une instance de windows

alors que dans une autre instance de windows la même partition sur le

même disque aura ce GUID différent)Changer le label du volume: commande

LABEL [drive:][label]Historique de révisions

Vous trouverez la dernière version de ce tutoriel sur ma page perso

de tutoriels informatique.

Vous y trouverez aussi la version HTML, PDF et TXT.2018-06-17 : Ajout d'une note indiquant que ce tutoriel utilise des

logiciels libres2018-06-11 : Correction de la forme et de fautes d'orthographe

2018-05-28

Commentaires : voir le flux atom ouvrir dans le navigateur

-

LinuxFr.org : première quinzaine de juin 2018

(Journaux LinuxFR)

Nonante huitième épisode dans la communication entre les différents intervenants autour du site LinuxFr.org : l’idée est tenir tout le monde au courant de ce qui est fait par les rédacteurs, les admins, les modérateurs, les codeurs, les membres de l’association, etc.

L’actu résumée (

[*]signifie une modification du sujet du courriel) :Statistiques

Du 1er au 15 juin 2018

- 1528 commentaires publiés (dont 8 masqués depuis) ;

- 248 tags posés ;

- 80 comptes ouverts (dont 6 fermés depuis) ;

- 35 entrées de forums publiées (dont 0 masquée depuis) ;

- 20 liens publiés (dont 1 masqué depuis) ;

- 21 dépêches publiées ;

- 25 journaux publiés (dont 1 masqué depuis) ;

- 3 entrées nouvelles, 1 corrigée dans le système de suivi ;

- 1 sondage publié ;

- 0 pages wiki publiées (dont 0 masquée depuis).

Listes de diffusion (hors pourriel)

Liste webmaster@ - [restreint]

- R.A.S.

Liste linuxfr-membres@ — [restreint]

- [membres linuxfr] Bouffe des 20 ans le 28 juin à Paris

Liste meta@ - [restreint]

- [Meta] Incident du jour sur SSL/TLS

- [Meta] Quel avenir pour la tribune ?

Liste moderateurs@ - [restreint]

- [Modérateurs] certificat linuxfr expiré

- [Modérateurs] Incident du jour sur SSL/TLS

- [Modérateurs] Certificat SSL

- [Modérateurs] où se trouve les CSS de Linuxfr

- [Modérateurs] forum - bug pour s'inscrire ?

Liste prizes@ - [restreint]

- [Prizes] LinuxFr prizes recap du samedi 9 juin 2018, 13:35:23 (UTC+0200)

- [Prizes] J'ai gagné un livre!

Liste redacteurs@ - [public]

- [Rédacteurs] Incident du jour sur SSL/TLS

Liste team@ - [restreint]

- [team linuxfr] Certificat SSL du site linuxfr.org expiré

- [team linuxfr] Tweet de Laurent Jouanneau (@ljouanneau)

- [team linuxfr] Incident du jour sur SSL/TLS

- [team linuxfr] Purge du compte X

[*] - [team linuxfr] réouverture de compte

- [team linuxfr] Organisez des événements dans le cadre de la Fête des Possibles, du 15 au 30 septembre 2018

Liste webmaster@ — [restreint]

- R.A.S.

Canal IRC adminsys (résumé)

- certificat X.509 périmé (encore merci à tous ceux qui l'ont signalé), passage à Let's Encrypt et communication post-incident

- renouvellement du domaine (encore merci Yann)

- dernière version de Jessie (8.11) prévu le 23 juin, et ensuite passage en fin de vie

- question relative à la configuration DMARC de la liste Sympa des modérateurs qui change le From de l'émetteur dans certains cas

- rachat de GitHub par Microsoft et dépôts LinuxFr.org. Faut-il bouger et pourquoi.

- Let's Encrypt et HTTP en clair pour le renouvellement ? Voir par exemple la discussion

- discussion sur les aspects sécurité de l'affichage distant d'images sur la tribune

- « 20 ans le bel âge pour mourir », ah non ça parle de Yahoo Messenger, pas de nous

- 20 ans du site et POSS en décembre ?

- courriels envoyés pour préparer les entretiens des 20 ans

- peu de présents aux RMLL dans l'équipe. Snif. Me laissez pas tout seul.

- migration de alpha et main en Jessie

- travaux en cours pour nettoyer le dépôt git d'admin (avec des fichiers générés par ansible notamment). Sans oublier de finaliser la partie Let's Encrypt…

- toujours un conteneur à migrer en Jessie, et ensuite trois en Stretch. Et aussi un hôte Trusty à mettre à jour.

Tribune de rédaction (résumé)

Tribune de modération (résumé)

- peu de présents aux RMLL dans l'équipe. Snif. Me laissez pas tout seul.

- du spam

- améliorations de CSS proposées par voxdemonix

- les admins du site ont des facilités techniques pour traquer les spammeurs et les multis, par rapport aux modérateurs

- retour des Geek Faeries

Commits/pushs de code https://github.com/linuxfrorg/

- (springcleaning) admin-linuxfr.org en cours de conversion vers Ansible

- Allow users to choose the source for their tribune smileys in prefere…

- Add a border for missing title on images

- Fix max height for image on computer screen

Divers

- Geek Faëries, c'était du 1er au 3 juin : conférence « LinuxFr.org, 20 ans que ça geeke » et table ronde « Ces plates‐formes du Libre qui soutiennent les communautés » avec l'Agenda du Libre et En Vente Libre. Encore plein de mercis à Bookynette pour le Village du libre, à l'équipe organisatrice des GF, et à Marco et Marius pour l'hébergement.

- RMLL 2018 Strasbourg : conférence LinuxFr.org : les 20 ans d'un espace d'apprentissage, de communication et d'échange , table ronde Ces plateformes du Libre qui soutiennent les communautés (même thème que celle tenue aux Geek Faëries) et stand

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Exécution de commandes en parallèle avec ClusterShell

(Dépêches LinuxFR)

ClusterShell est une bibliothèque événementielle en Python qui permet d'exécuter en parallèle des commandes en local et à distance sur des noeuds d'un cluster, ferme de serveurs, stations de travail... Elle fournit également un ensemble de scripts utilitaires basés dessus (voir plus bas).

ClusterShell est développée et utilisée au CEA par les équipes système de plusieurs grands clusters Linux de stockage et de calcul (qui comptent parmi les plus puissants du monde -- dont Tera100), elle est disponible sous licence CeCILL-C (CEA - CNRS - INRIA Logiciel Libre, compatible LGPLv2+).

lien 1 : ClusterShell (avec documentation et exemples)

lien 2 : Plus d'infos sur la gestion des groupes de noeuds

(...) -

LinuxFr.org : première quinzaine de juin 2018

(Journaux LinuxFR)

Nonante-huitième épisode dans la communication entre les différents intervenants autour du site LinuxFr.org : l’idée est tenir tout le monde au courant de ce qui est fait par les rédacteurs, les admins, les modérateurs, les codeurs, les membres de l’association, etc.

L’actu résumée (

[*]signifie une modification du sujet du courriel) :Statistiques

Du 1er au 15 juin 2018

- 1528 commentaires publiés (dont 8 masqués depuis) ;

- 248 tags posés ;

- 80 comptes ouverts (dont 6 fermés depuis) ;

- 35 entrées de forums publiées (dont 0 masquée depuis) ;

- 20 liens publiés (dont 1 masqué depuis) ;

- 21 dépêches publiées ;

- 25 journaux publiés (dont 1 masqué depuis) ;

- 3 entrées nouvelles, 1 corrigée dans le système de suivi ;

- 1 sondage publié ;

- 0 pages wiki publiées (dont 0 masquée depuis).

Listes de diffusion (hors pourriel)

Liste webmaster@ - [restreint]

- R.A.S.

Liste linuxfr-membres@ — [restreint]

- [membres linuxfr] Bouffe des 20 ans le 28 juin à Paris

Liste meta@ - [restreint]

- [Meta] Incident du jour sur SSL/TLS

- [Meta] Quel avenir pour la tribune ?

Liste moderateurs@ - [restreint]

- [Modérateurs] certificat linuxfr expiré

- [Modérateurs] Incident du jour sur SSL/TLS

- [Modérateurs] Certificat SSL

- [Modérateurs] où se trouvent les CSS de Linuxfr

[*] - [Modérateurs] forum - bug pour s'inscrire ?

Liste prizes@ - [restreint]

- [Prizes] LinuxFr prizes recap du samedi 9 juin 2018, 13:35:23 (UTC+0200)

- [Prizes] J'ai gagné un livre!

Liste redacteurs@ - [public]

- [Rédacteurs] Incident du jour sur SSL/TLS

Liste team@ - [restreint]

- [team linuxfr] Certificat SSL du site linuxfr.org expiré

- [team linuxfr] Tweet de Laurent Jouanneau (@ljouanneau)

- [team linuxfr] Incident du jour sur SSL/TLS

- [team linuxfr] Purge du compte X

[*] - [team linuxfr] réouverture de compte

- [team linuxfr] Organisez des événements dans le cadre de la Fête des Possibles, du 15 au 30 septembre 2018

Liste webmaster@ — [restreint]

- R.A.S.

Canal IRC adminsys (résumé)

- certificat X.509 périmé (encore merci à tous ceux qui l'ont signalé), passage à Let's Encrypt et communication post-incident

- renouvellement du domaine (encore merci Yann)

- dernière version de Jessie (8.11) prévu le 23 juin, et ensuite passage en fin de vie

- question relative à la configuration DMARC de la liste Sympa des modérateurs qui change le From de l'émetteur dans certains cas

- rachat de GitHub par Microsoft et dépôts LinuxFr.org. Faut-il bouger et pourquoi.

- Let's Encrypt et HTTP en clair pour le renouvellement ? Voir par exemple la discussion

- discussion sur les aspects sécurité de l'affichage distant d'images sur la tribune

- « 20 ans le bel âge pour mourir », ah non ça parle de Yahoo Messenger, pas de nous

- 20 ans du site et POSS en décembre ?

- courriels envoyés pour préparer les entretiens des 20 ans

- peu de présents aux RMLL dans l'équipe. Snif. Me laissez pas tout seul.

- travaux en cours pour nettoyer le dépôt git d'admin (avec des fichiers générés par ansible notamment). Sans oublier de finaliser la partie Let's Encrypt…

- toujours un conteneur à migrer en Jessie, et ensuite trois en Stretch. Et aussi un hôte Trusty à mettre à jour.

Tribune de rédaction (résumé)

Tribune de modération (résumé)

- peu de présents aux RMLL dans l'équipe. Snif. Me laissez pas tout seul.

- du spam

- améliorations de CSS proposées par voxdemonix

- les admins du site ont des facilités techniques pour traquer les spammeurs et les multis, par rapport aux modérateurs

- retour des Geek Faeries

Commits/pushs de code https://github.com/linuxfrorg/

- (springcleaning) admin-linuxfr.org en cours de conversion vers Ansible

- Allow users to choose the source for their tribune smileys in prefere…

- Add a border for missing title on images

- Fix max height for image on computer screen

Divers

- Geek Faëries, c'était du 1er au 3 juin : conférence « LinuxFr.org, 20 ans que ça geeke » et table ronde « Ces plates‐formes du Libre qui soutiennent les communautés » avec l'Agenda du Libre et En Vente Libre. Encore plein de mercis à Bookynette pour le Village du libre, à l'équipe organisatrice des GF, et à Marco et Marius pour l'hébergement.

- RMLL 2018 Strasbourg : conférence LinuxFr.org : les 20 ans d'un espace d'apprentissage, de communication et d'échange, table ronde Ces plateformes du Libre qui soutiennent les communautés (même thème que celle tenue aux Geek Faëries) et stand

Commentaires : voir le flux atom ouvrir dans le navigateur

-

Une faille nommée « shellshock »

(Dépêches LinuxFR)

« ShellShock », une faille dans l'usage du shell Bash, est sous les projecteurs depuis quelques jours. Le terme est un jeu de mot entre la stupeur propre à l'obusite des combattants de la première guerre mondiale et l'interface système shell. Nous vous proposons des explications sur cet évènement particulier, son périmètre, les conditions de son exploitation, les surfaces d'attaques, et les solutions proposées, déjà mises en œuvre ou à venir. Enfin, une revue de presse sera dressée, cette faille s'étant transformée en évènement.

- lien n°1 : Redhat : Frequently Asked Questions about the Shellshock Bash flaws

- lien n°2 : Redhat : Bash specially-crafted environment variables code injection attack

- lien n°3 : Annonce initiale sur la liste Open Source Security

- lien n°4 : CERTFR-2014-ALE-006 : Vulnérabilité dans GNU bash

- lien n°5 : ShellShock.fr : explications et testeur en ligne

- lien n°6 : GitHub : Security vulnerability in bash addressed

- lien n°7 : Shellshock DHCP RCE Proof of Concept

- lien n°8 : Journal initial sur LinuxFr.org : Mets à jour ton bash. Maintenant.

- lien n°9 : Free Software Foundation statement on the GNU Bash "shellshock" vulnerability

- lien n°10 : 01Net : Interview exclusive: « J’ai découvert la faille Shellshock par hasard »

- lien n°11 : shellshocker.net : explications et testeur en ligne

Sommaire

- Contexte et histoire

- Quelques explications

- Surfaces d'attaques et exploitabilité

- Chronologie des évènements

-

Solutions mises en œuvre

-

Correctifs disponibles et annonces des distributions

- La faille, CVE-2014-6271

- Le second problème, CVE-2014-7169

- Les CVE-2014-6277, CVE-2014-7186 et CVE-2014-7187 ne sont pas publics à ce jour (infos chez Redhat 0, 1 et 2).

- mod_security, le filtrage

- Le cas FreeBSD

-

Correctifs disponibles et annonces des distributions

- Revue de presse

- Conclusion

Contexte et histoire

Bash est l'interpréteur par défaut du projet GNU, c'est une amélioration du Shell Bourne, reprenant des idées du Korn Shell (ksh). Il est développé depuis 1988 et n'a cessé de s'améliorer.

Bash est le shell par défaut d'un grand nombre de distributions GNU/Linux, mais pas toutes. Par exemple Ubuntu ne lance pas Bash avec son

/bin/sh, mais dash, Bash n'étant disponible que pour l'utilisateur en session interactive. Bash se retrouve également dans Apple Mac OS X et dans Microsoft Windows via Cygwin (SFU, Services for Unix, utilise csh ou ksh).Quelques explications

Il s'agit d'exploiter un bash-isme, une spécificité du shell Bash, permettant d'exporter une fonction et non seulement une variable. Les autres shells (ksh, zsh, dash, …) ne sont pas concernés par cette faille. Par ailleurs, Bash ne permet pas cet export de fonctions s'il est utilisé avec l'option

-p).Il est tout à fait normal de vouloir passer des variables d'environnement à un processus enfant.

Mais Bash permet en outre de passer des fonctions vers le processus enfant. Aucun autre shell ne permet cela. Dans ce cadre relativement strict, la sécurité ne pose pas de problème : les droits et contextes d'exécution sont identiques et l'utilisateur, système ou non, est le même. Ceci est documenté, il s'agit de l'option

-fde la commandeexportdans le shell Bash. « It is not a bug, it is a feature », le vieil adage prend ici tout son sens. Nous laissons le lecteur seul juge du bien-fondé de ce bashisme.Alors s'il n'y a pas de problème, où est le problème ? Le problème se situe dans l'usage de Bash par les autres programmes. Bash est devenu le shell par défaut de certaines distributions, et de nombreux programmes utilisent le shell par défaut pour passer des variables d'environnement entre leurs processus. Le contexte change donc : ce n'est plus un utilisateur local et de confiance qui utilise cela, mais une multitude de programmes, parfois distants.

Ces programmes ne valident pas eux mêmes les données qu'ils donnent à Bash, et ne font souvent que passe-plat. Dans ce contexte, ce qui était auparavant une fonctionnalité se transforme alors en faille. Ceci explique l'ancienneté du problème.

Explications techniques

Une fonction dans le shell bash

#!/bin/bash # déclaration de la fonction d'affichage du message "bonjour vous", nommée mafonction : mafonction() { echo "bonjour vous"; } # exécution de la fonction : mafonctionLa même chose, pour passer la fonction à un sous-shell

env mafonction='() { echo "bonjour vous"; }' bash -c 'mafonction;'On prefixe avec la commande

envpour faire tourner un programme dans un environnement modifié. Et à la fin on fait exécuter la fonction par un autre bash. OK ?La même chose, en détournant l'usage

env mafonction='() { echo "bonjour vous"; }; echo "voici shellshock"' bash -c "mafonction;"Ici, l'exécution de la fonction mafonction ne se limite pas à un écho "bonjour vous", mais exécute aussi le code echo "voici shellshock" On notera la place du délimiteur '

OK ?Et en fait il n'est même pas nécessaire d'exécuter la fonction définie :

env mafonction='() { echo "bonjour vous"; }; echo "voici shellshock"' bash -c "true" voici shellshockDonc, le simple

() { :;}suffit à résumer la situation.

OK !Surfaces d'attaques et exploitabilité

Les conditions de l'exploitation à distance de la faille sont relativement simples :

-

/bin/shpointe sur/bin/bash; - avoir SELinux désactivé ou non configuré ;

- avoir un service qui écoute le réseau et qui va exécuter

bash.

L'exploitation de cette faille est très simple, et de nombreux preuves de concepts et exploits circulent actuellement sur Internet. Voici une liste non-exhaustive des logiciels qui peuvent être utilisés en passe-plat :

- dhclient ;

- apache, via mod_cgi (et sans mod_security correctement configuré) ;

- exim ; postfix ; qmail ; procmail ;

- OpenVPN ;

- stunnel ;

- probablement de très nombreux logiciels privateurs …

- SIP, FTP, probablement d'autres …

Preuves de Concept

Un projet hébergé sur github rassemble une série de POC à cette adresseÀ noter que SELinux ne va pas bloquer un usage de « shellshock », il va cependant en réduire fortement les possibilités d'exploitation. Par exemple le contexte

httpd_sys_script_test attribué à tout CGI, contexte qui ne permet l'écriture que dans … /tmp! Le lecteur trouvera des explications complètes sur le blog de Dan Walsh à ce sujet.Ne sont donc pas concernées : toutes les distributions ayant un autre shell que Bash. Toutes les distributions ayant SELinux activé bénéficient d'une protection contre des exploitations de ce type. Mais également : tous les matériels embarqués et objets connectés, contrairement à ce que des articles de presse affirment, car ces matériels utilisent la plupart du temps busybox et son implémentation inline de Bash n'est pas vulnérable. Ne sont pas concernés non plus les téléphones portables (pas plus les Android que les iPhones). Les "box" internet ne le sont pas davantage, ni les télévisions, ni les lecteurs de salon, les autoradios, ni les avions, drones, missiles, sous-marins… Bref, nous avons eu le plaisir de lire un peu n'importe quoi sur le sujet et la revue de presse contient quelques jolies perles.

NdM : le fabriquant de NAS QNAP vient d'alerter ses utilisateurs (cf article Next INpact)

Chronologie des évènements

- Stéphane Chazelas rapporte le problème à Redhat (bug déclaré le 14 septembre) ;

- Le CVE-2014-6271 lui est attribué ;

- Le 24 septembre, ce CVE est rendu public et un premier correctif est mis à disposition ;

- Le jour même la communauté pointe l'insuffisance de ce correctif ;

- Le CVE-2014-7169 est alors ouvert et attribué à Tavis Ormandy ;

- Le 27 septembre le second correctif est publié

Solutions mises en œuvre

Correctifs disponibles et annonces des distributions

La faille, CVE-2014-6271

Le test :

env 'x=() { :;}; echo vulnerable' 'BASH_FUNC_x()=() { :;}; echo vulnerable' bash -c "echo test"Ne doit pas retourner le terme "vulnérable", quelque soit le formattage retour.-

Les annonces :

Le second problème, CVE-2014-7169

Le test :

cd /tmp; rm -f echo; env 'x=() { (a)=>\' bash -c "echo date"; cat echodoit retourner que le fichier "/tmp/echo" n'existe pas.-

Les annonces :

Les CVE-2014-6277, CVE-2014-7186 et CVE-2014-7187 ne sont pas publics à ce jour (infos chez Redhat 0, 1 et 2).

- D'autres correctifs sont à venir.

mod_security, le filtrage

Mod_security est un pare-feu applicatif pour le serveur Apache. Il peut être configuré pour filtrer certains caractères et expressions régulières. C'est donc un moyen efficace pour se prémunir contre le principal vecteur d'attaque : les scripts CGI. Si vous utilisez Redhat, vous pouvez l'installer ou le mettre à jour : il contient les règles tout prêtes pour filtrer « shellshock ». Ces règles sont de types :

SecRule REQUEST_HEADERS "^\(\) {"& request_line.Le cas FreeBSD

Le projet FreeBSD a décidé de désactiver la possibilité d'importation de fonction de Bash. Le système FreeBSD n'utilise pas Bash comme shell par défaut, mais tcsh, Bash n'étant même pas inclus dans une installation de base. Mais pour prémunir de tout problème lié à un changement de shell par défaut, le projet a décidé de supprimer la fonctionnalité incriminée, avec ce message laconique : « cela retire le risque de nouveaux problèmes conduisant à l’exécution de code, et le risque pour les scripts suid, aussi pour les applications mal écrites qui ne nettoient pas leurs environnements » Radical.

Revue de presse

Après les annonces sécurité et la réaction des projets (Bash, FSF - traduite en français par l'April), la presse spécialisée puis la presse généraliste ont multiplié les articles : pire que la faille Heartbleed ? (Slate.fr, LMI, Silicon.fr, L'Express, 20minutes, HuffingtonPost, New Zealand Herald), « panique » (Courrier International), « mégafaille » (01Net), « horrible » (ZdNet), « premières attaques » (01net), « plus grande menace de l'histoire du web » (ParisMatch, si si), « 500 millions de serveurs web vulnérables » (La Tribune, Washington Post), « Google et Amazon ont patchés » - super on est sauvés alors - (WallStreetJournal), d'autres failles Bash à prévoir (ArsTechnica), « ver fou ShellShock » (Wired ou le blog de R. Graham), « internet bâti sur de la glace fine » (Financial Times), etc.

Conclusion

D'une rencontre entre une fonctionnalité et des usages nait une faille qui fait grand bruit. Bruit généré par l'importance du problème, certes, mais également par le manque de discernement et le FUD autour. Ce qui met en valeur la place qu'ont pris les Logiciels Libres dans nos vies quotidiennes, sans que cela se voie. Il aura fallu moins de 4 jours entre la publication du problème (à ne pas confondre avec le signalement initial aux équipes sécurité) et sa résolution. Peu d'éditeurs peuvent se targuer d'être aussi rapides sur la résolution d'un problème de ce type et sur la transparence pour l'accès à l'information.

Dans le même temps, l'inquiétude de savoir que cette possibilité existe depuis de nombreuses années est légitime. Et elle renforce la nécessité de participation. Combien d'éditeurs de solutions s'appuient sur des briques libres sans jamais rien verser aux projets ?

Mettez et maintenez vos systèmes à jour! Et ne pensez pas qu'un programme qui n'a pas connu beaucoup de failles est forcément très sûr, peut-être que personne ne l'avait vraiment regardé jusque là.

-

Haskell et le tri

(Journaux LinuxFR)

Sommaire

Bonjour nal.

Introduction

Cela fait longtemps que je n'ai pas posté ici, cela me manquait. Je trouve que LinuxFR ne parle pas assez de Haskell, alors je vais en parler un peu aujourd'hui sur une digression totalement inintéressante et proche de la masturbation intellectuelle. On va partir de rien et discuter de la fonction de tri fournie dans la librairie standard (base) de GHC, le compilateur le plus connu / utilisé.

L'idée c'est de vous présenter un peu Haskell et sa syntaxe à partir d'un exemple simple à partir d'une fonction simple, le tri. Attention, on ne va pas implémenter de tri, mais on va voir comment utiliser les fonctions déjà existante pour construire une fonction de tri de plus haut niveau.

Sort

Cette fonction s'appelle sort et a comme signature :

sort :: Ord a => [a] -> [a]Dit autrement, c'est une fonction qui prend

[a], une liste de n'importe quel typeaet renvoie une liste de n'importe quel typea. Seule contrainte sura, ce type doit êtreOrdonable, c'est à dire que on doit pouvoir comparer les éléments deaentre eux. La liste est une liste simplement chaînées et elle est non modifiable, ainsi le tri ne se fait pas en place, mais crée une nouvelle liste.Cela ressemblerait un peu à cette fonction en c++ :

template<typename A> std::list<A> sort(const std::list<A> &l);Exemple d'usage dans l'invite de commande ghci :

> import Data.List > sort [1, 10, 3, 2, 0, -1] [-1,0,1,2,3,10]Sort By

Super ! Bon, il existe un autre variantes de cette fonction, sortBy.

sortBy :: (a -> a -> Ordering) -> [a] -> [a]sortByaccepte une fonction de comparaison en plus de type(a -> a -> Ordering), en gros, elle prend deux éléments et renvoi leur ordre. Exemple d'utilisation :> let compareName nameA nameB | | nameA == "Chuck Norris" = GT | | nameB == "Chuck Norris" = LT | | otherwise = compare nameA nameB | > sortBy compareName ["Chuck Norris", "Bruce Wayne", "Bruce Banner", "Zorro", "Denver"] ["Bruce Banner","Bruce Wayne","Denver","Zorro","Chuck Norris"]Notez comment j'écris une fonction de comparaison spécifique qui rend toute sa gloire à Chuck Norris.

Cette example de code est équivalent au code python suivant, qui ne marche plus qu'en python 2, l'attribut

cmpdesortedayant disparu en python 3, ce que je regrette. :>>> sorted([1, 10, 3, 2, 0, -1]) [-1, 0, 1, 2, 3, 10] >>> def compareName(nameA, nameB): ... if nameA == "Chuck Norris": return 1 ... if nameB == "Chuck Norris": return -1 ... return cmp(nameA, nameB) ... >>> sorted(["Chuck Norris", "Bruce Wayne", "Bruce Banner", "Zorro", "Denver"], cmp=compareName) ['Bruce Banner', 'Bruce Wayne', 'Denver', 'Zorro', 'Chuck Norris']Digression paresseuse

Petite digression sur Haskell, connaissez vous la complexité de cette opération :

> head (sort [1..100]) 1Naïvement on pourrait se dire, un tri, O(n log n). Mais non, Haskell est paresseux et rend le résultat en O(n) car il n'a pas besoin de calculer le tri entier avant d'obtenir le résultat. Super non ? En pratique cela aide rarement et souvent cela complexifie la réflexion.

Tri inversé

Revenons à nos fonctions de tri. Je veux pouvoir trier ma liste à l'envers. En python, rien de plus simple, il suffit d'utiliser le paramètre optionnel

reverse:>>> sorted(["Chuck Norris", "Bruce Wayne", "Bruce Banner", "Zorro", "Denver"], cmp=compareName, reverse=True) ['Chuck Norris', 'Zorro', 'Denver', 'Bruce Wayne', 'Bruce Banner']En Haskell, ce n'est pas si simple… On peut utiliser

reverse, mais cela va trier la liste dans un sens puis l'inverser, quelle perte de temps :reverse (sortBy compareName ["Chuck Norris", "Bruce Wayne", "Bruce Banner", "Zorro", "Denver"]) ["Chuck Norris","Zorro","Denver","Bruce Wayne","Bruce Banner"]Mais on peut aussi se dire que si on inversait les arguments de la fonction

compareNameavecflipalors cela fonctionnerait sans soucis :> (sortBy (flip compareName) ["Chuck Norris", "Bruce Wayne", "Bruce Banner", "Zorro", "Denver"]) ["Chuck Norris","Zorro","Denver","Bruce Wayne","Bruce Banner"]On peut donc facilement crée une fonction de plus haut niveau :

> let reverseSortBy f = sortBy (flip f) | > reverseSortBy compareName ["Chuck Norris", "Bruce Wayne", "Bruce Banner", "Zorro", "Denver"] ["Chuck Norris","Zorro","Denver","Bruce Wayne","Bruce Banner"]Règle de compilation

On peut même crée une règle de compilation qui va remplacer automatiquement

reverse (sortBy f l)parsortBy (flip f) l:{-# RULES "reverse/sortBy" forall f l. reverse (sortBy f l) = sortBy (flip f) l #-}C'est une chose que j’apprécie vraiment en Haskell, c'est que on peut écrire du code assez clair et plus tard le rendre efficace en transformant notre code automatiquement.

Tri multiple

Pour continuer, nous allons nous concentrer sur

sortByen Haskell ou l'attributcmpde la fonctionsortedde python.Je suis maintenant l'heureux utilisateur d'une liste de noms et de poids que je nommerais

l:> let l = [("Bruce Lee", 50), ("Batman", 100), ("Hulk", 200), ("La montagne", 100)]J'aimerais trier ces gens par poids décroissant et par nom croissant en cas d'égalité. Nous allons faire cela en python, puis en Haskell, puis en Haskell for WarLdOrZOrgCoderZZZ.

En python tout d'abord :

>>> l = [("Bruce Lee", 50), ("Batman", 100), ("Hulk", 200), ("La montagne", 100)] >>> def compare(t0, t1): ... c = cmp(t1[1], t0[1]) ... if c == 0: ... return cmp(t0[0], t1[0]) ... else: ... return c ... >>> sorted(l, cmp=compare) [('Hulk', 200), ('Batman', 100), ('La montagne', 100), ('Bruce Lee', 50)]Rien de bien dramatique. C'est pas forcement beau, mais cela fait le boulot. Ma fonction de comparaison commence par comparer les indices

[1](donc les poids), observez l'inversion des arguments de cmp où je passet1puist0pour l'ordre décroissant. Si les deux sont égaux (carcmprenvoie0) alors je regarde le nom, sinon je renvois le résultat de la comparaison.En Haskell maintenant :

> let compare' t0 t1 = case (compare (snd t1) (snd t0)) of | EQ -> compare (fst t0) (fst t1) | ltOrGt -> ltOrGt | > sortBy compare' l [("Hulk",200),("Batman",100),("La montagne",100),("Bruce Lee",50)]J'ai appelé ma fonction de comparaison

compare'pour ne pas la confondre avec celle du système qui s'appellecompare.sndetfstsont sensiblement équivalents aux[0]et[1]de python. Ce que j'aime en Haskell c'est que bien que je n'ai mis aucune annotation de type, ils existent et sont vérifiés. J'aime aussi le fait que compare me renvoiEQouGTouLTet non pas-0ou-1ou1comme le fait python. Bref, les avantages du typage statique sans les inconvénients.Un des défaut de cette méthode, c'est qu'elle va vite devenir complexe si j'ai plus de critères de tri. Nous allons régler ce problème.

Première factorisation

En premier lieu je n'aime pas la duplication de code qu'il y a sur

compare (snd t1) (snd t0)etcompare (fst t0) (fst t1). Je propose de factoriser cela dans une fonction que nous nommerons de façon malicieusecomparing, je ne me suis pas foulé, elle existe déjà avec ce nom la ;)> let comparing f a b = compare (f a) (f b) | > let compare' t0 t1 = case (comparing snd t1 t0) of | EQ -> comparing fst t0 t1 | ltOrGt -> ltOrGt | > sortBy compare' l [("Hulk",200),("Batman",100),("La montagne",100),("Bruce Lee",50)]C'est plus simple ;) Comme comparing existe déjà dans la librairie standard, je vais me contenter de l'importer avec

import Data.Ord (comparing).On va continuer à factoriser un peu. Je n'aime vraiment pas cette inversion des arguments de

comparing snd t1 t0. Cela ressemble à un bug, il manque un commentaire pour dire que je veux trier en ordre descendant. Bref, c'est peu agréables. Je vais écrire deux variantes decomparing:ascending f a b = comparing f a b descending f a b = flip (comparing f) a bApplication partielle

Petite digression sur l'application partielle. En Haskell, tout est fonction. Il y a les fonctions constantes de type

tet les fonctions unaires de type de typet -> t'. Par exemple,absqui donne la valeur absolue, est une fonction unaire deInt -> Int. Mais le type de retour d'une fonction unaire peut être aussi une fonction. On peut donc avoir une fonction du typea -> (b -> r)qui peut s'écrirea -> b -> c. En appliquant cette fonction une unique fois sur une valeur de typeaon obtient une fonction de typeb -> c. Bref. On se sert souvent de cette propriété pour créer des fonctions avancée à partir de fonction plus simples. Exemple, la fonction d'addition s'écrit(+), notez dans l'exemple suivant comment on peut l'utiliser en forme infix ou postfix, et comment on peut créer une fonction partiellement appliquéeinc:> (+) 1 2 3 > 1 + 2 3 > let inc = (+) 1 > inc 5 6De façon similaire, toutes ces notations sont équivalentes, seul changent le fait que les arguments sont explicitement présents ou pas :

let add x y = (+) x y let add x y = x + y let add x = (+) x let add = (+)Seconde factorisation

Revenons à nos fonctions

ascendingetdescending. Voici le code prenant en compte ces nouvelles fonctions. Notez que j'ai un peu simplifié l'écriture deascendingetdescendingafin d'utiliser l'application partielle :> let ascending = comparing > let descending = flip . comparing > let compare' t0 t1 = case (descending snd t0 t1) of | EQ -> ascending fst t0 t1 | ltOrGt -> ltOrGt | > sortBy compare' l [("Hulk",200),("Batman",100),("La montagne",100),("Bruce Lee",50)]Bon, les choses commencent à devenir intéressantes. Ma fonction

compare'commence à être bien claire, si ce n'est le case pour enchaîner sur le critère suivant si le premier critère est égale àEQ. On pourrait définir un opérateur binaire permettant de réaliser ce traitement, appelons cet opérateurblorkjuste parce que c'est marrant de lui donner ce nom et qu'aucun autre ne me vient à l'esprit là maintenant…> let blork a b | | a == EQ = b | | otherwise = aNotez la syntaxe de guard, qui permet de tester différentes équations afin de trouver la valeur de retour.

Réécrivons encore une fois notre code, notez que j'utilise

blorkcomme opérateur infix.> let compare' t0 t1 = descending snd t0 t1 `blork` ascending fst t0 t1 > sortBy compare' l [("Hulk",200),("Batman",100),("La montagne",100),("Bruce Lee",50)]On factorise encore plus

Cela va commencer à devenir plus simple de chaîner les prédicats puisqu'au lieu d'une cascade de

caseje peux simplement ajouter une composition avecblork. On pourrait même commencer à virercompare'et à mettre en place une fonction lambda anonyme :> sortBy (\t0 t1 -> descending snd t0 t1 `blork` ascending fst t0 t1) l [("Hulk",200),("Batman",100),("La montagne",100),("Bruce Lee",50)]Bon. Mais je ne suis encore pas satisfait par ça. Je n'aime pas cette fonction, la presence de

t0ett1de partout. Ce que j'aimerais c'est écrire une fonctionblirkqui permet de combiner deux fonctions de comparaison ensemble. On va l'écrire vite :> let blirk f0 f1 a b = f0 a b `blork` f1 a b > sortBy (descending snd `blirk` ascending fst) l [("Hulk",200),("Batman",100),("La montagne",100),("Bruce Lee",5)]Et voila, là je suis super content… J'ai une belle api, cela permet d'expliquer vraiment simplement ce que je veux. Mais il y a toujours ces deux fonctions

blirketblorkpour lesquels j'ai du mal à donner un nom.Monoids

Je rappel,

blorkretourne le premier terme qui n'est pasEQ, tel que :EQ `blork` GT `blork` LT == GT LT `blork` EQ `blork` GT = LTCela ne vous rappel rien ? :

True and True and True == True True and False and True == FalseC'est très proche de l’opérateur

andou de l’opérateurorlogique. En généralisant un peu, il s'agit d'un [Monoid]. Non, ce n'est pas une pub pour du shampoing, un monoid c'est un ensemble qui admet un élément neutre et une operation de réduction associative. Comme(+)et0ou(*)et1pour les entiers.Nos résultats d’égalité forment un monoid. L’élément neutre étant

EQet l'operation entre les éléments étantblork.On et bien avancé, oui ! Car ce concept est tellement courant qu'il y a une librairie standard dans Haskell qui gère les Monoids, Data.Monoid. Et coup de chance,

Ordering, le type deEQ,LTetGTest géré.En haskell, les Monoids ont deux fonctions utiles,

mappendetmempty. Regardons un peu celles-ci en action sur différents monoids.Tout d'abord les elements neutres, avec

mempty. Ici, c'est un peu tordu, carmemptyest une fonction constante polymorphique, c'est à dire que sa valeur dépend du type utilisé, d'où les annotation de type faites avec::que j'ai rajoutées.> mempty :: Sum Int Sum {getSum = 0} > mempty :: Product Int Product {getProduct = 1} > mempty :: Ordering EQ > mempty :: String "" > mempty :: [Int] []Puis la fonction de réduction,

mappend:> Sum 5 `mappend` Sum 12 Sum {getSum = 17} > Product 5 `mappend` Product 12 Product {getProduct = 60} > [1,2,3] `mappend` [4,5,6] [1,2,3,4,5,6] > "Hello" `mappend` "you" "Helloyou" > EQ `mappend` GT GT > EQ `mappend` LT LT > GT `mappend` LT GT > GT `mappend` LTApplication au critères de tri

Donc en fait, ici,

mappendc'est la fonctionblork. Et commemappendest super utilisée, il a un synonyme, l'operateur(<>). Nous pouvons donc dégagerblorket utiliser(<>)à la place.Qu'en est il de

blirk?. Rappel, cette fonction permettait de combiner ensemble plusieurs fonctions binaire retournant des monoids afin de crée une unique fonction binaire.Il se trouve que les fonctions sont aussi des monoids, voyons ce que cela implique.

Je reprend donc ma définition de

blirk:> let blirk f0 f1 a b = f0 a b `blork` f1 a bJe remplace

blorkpar<>comme vu dernièrement :> let blirk f0 f1 a b = f0 a b <> f1 a bAu lieu d'appliquer l’opérateur

<>entre les résultats def0etf1appliqués àaetb, je peux appliquer l’opérateur<>entre f0 et f1 :> let blirk f0 f1 a b = (f0 <> f1) a bBon… Super… Je vais nettoyer un peu en virant

aetbgrâce à l'application partielle :> let blirk f0 f1 = f0 <> f1C'est pas mal, blirk est bien plus simple maintenant, mais est toujours là… Juste pour la forme, je pourrais écrire

<>sous forme prefix :> let blirk f0 f1 = (<>) f0 f1Tient, mais je peux utiliser l'application partielle ici ! :

> let blirk = (<>)Et voila

blirkn'est autre que l’opérateur de réduction des monoids… Je n'ai donc plus besoin de mes fonctions blirk et blork. Voici maintenant une session de shell complète me permettant d'arriver à mon résultat :> import Data.List (sortBy) > import Data.Ord (comparing) > import Data.Monoid ((<>)) > let l = [("Bruce Lee", 50), ("Batman", 100), ("Hulk", 200), ("La montagne", 100)] > let ascending = comparing > let descending = flip . comparing > sortBy (descending snd <> ascending fst) l [("Hulk",200),("Batman",100),("La montagne",100),("Bruce Lee",50)]Voila. Grâce à trois fonctions de la librairie standard et deux définitions triviales pour

ascendingetdescending, j'ai réalisé un mini langage me permettant de paramétrer ma fonctionsortBypour réaliser n'importe quel type de tri.Définir ses propres types

Notez que dans la vraie vie, je n'aime pas les tuples anonymes, donc je ferais mon propre type super hero que j'exploiterais de cette manière :

> data Hero = Hero {name :: String, weight :: Int} deriving (Show) > let l = [Hero "Bruce Lee" 50, Hero "Batman" 100, Hero "Hulk" 200, Hero "La montagne" 100] > sortBy (descending weight <> ascending name) l [Hero {name = "Hulk", weight = 200},Hero {name = "Batman", weight = 100},Hero {name = "La montagne", weight = 100},Hero {name = "Bruce Lee", weight = 50}]Ceci afin de vous montrer la souplesse d'Haskell à ce niveau là. Je crois que

sortBy (descending weight <> ascending name)ne peut pas être plus clair et de façon intéressante, cela n'a demandé aucun boilerplate. L'annotationderiving (Show)permet de munir mon type "Hero" d'un affichage par défaut que nous voyons dans le résultat. C'est l'équivalent de la surcharge de__str__en python ou deostream &operator<<(ostream&)en C++, mais avec un comportement par défaut pas trop mal.Sort On

Je disais que je regrettais la disparition du paramètre

cmpde la fonctionsortedde python. Il est maintenant remplacé par le paramètrekeyqui s'utilise un peu comme notre fonctioncomparing. En python :>>> sorted(["Hello", "My", "Friend"], key=len) ['My', 'Hello', 'Friend'] >>> sorted(["Hello", "My", "Friend"], key=len, reverse=True) ['Friend', 'Hello', 'My']La difference étant que cette approche n'appelle la fonction

keyqu'une fois par élément de la liste contrairement à la version aveccmpqui appelle cette fonction en moyenne O(n log n) fois. Mais en pratique elle nécessite de stocker une liste temporaire en plus. C'est donc un compromis entre mémoire utilisée et efficacité de la fonction de comparaison.La fonction sortOn en Haskell fonctionne de façon similaire :

> sortOn length ["Hello", "My", "Friend"] ["My","Hello","Friend"]Mais qu'en est il du tri inversé. Encore une fois il n'y a pas de fonction de tri avec reverse. L'idée étant que la fonction attendue par

sortOn, icilengthtransforme nos éléments en une autre valeur qui est triable. Ici, Haskell propose un type, Down qui inverse les propriétés de tri du type interne. Exemple :> sortOn (Down . length) ["Hello", "My", "Friend"] ["Friend","Hello","My"]La différence en terme d'API avec python est faible, mais revenons à un example plus complexe comme celui du tri de notre liste de héros. Nous allons réaliser une fonction de tri qui transforme un hero en tuple (poids du hero descendant, nom du héro), les tuples étant triés dans l'ordre lexicographique, cela résous notre problème :

> sortOn (\hero -> (Down (weight hero), name hero)) l [Hero {name = "Hulk", weight = 200},Hero {name = "Batman", weight = 100},Hero {name = "La montagne", weight = 100},Hero {name = "Bruce Lee", weight = 50}]A ma connaissance il n'y a pas d'équivalent direct de

Downen python, alors nous allons l'écrire. J'en profite pour aussi crée le typeHeropour pouvoir facilement comparer :>>> class Hero: ... def __init__(self, name, weight): ... self.name = name ... self.weight = weight ... ... def __repr__(self): ... return "Hero(%r, %r)" % (self.name, self.weight) ... >>> l = [Hero("Bruce Lee", 50), Hero("Batman", 100), Hero("Hulk", 200), Hero("La montagne", 100)] >>> class Down: ... def __init__(self, obj): ... self._obj = obj ... def __lt__(self, other): ... return self._obj.__gt__(other._obj) ... def __gt__(self, other): ... return self._obj.__lt__(other._obj) ... def __eq__(self, other): ... return self._obj.__eq__(other._obj) ... >>> sorted(l, key=lambda hero: (Down(hero.weight), hero.name)) [Hero('Hulk', 200), Hero('Batman', 100), Hero('La montagne', 100), Hero('Bruce Lee', 50)]Voila, on peut faire la même chose, mais la lib standard Haskell propose ici des solutions déjà implémentées.

Conclusion

Voila, j'espère que cette introduction à Haskell vous aura fait plaisir, j'ai essayé d'aborder un problème simple, le tri, et en tirant un peu dessus, montrer quelques subtilités du langage.

A bientôt.

-

Tutorial Code_Aster

(Journaux LinuxFR)

Sommaire

Bonjour Nal', une fois n'est pas coutume, il pleut en Haute-Garonne ! Alors j'ai tué le temps jetant un œil à Code Aster. Je laisse ici mes notes.

Code_Aster, qu'est-ce c'est ?

Code_Aster est un code de calcul de structure thermo-mécanique par la méthode des éléments finis isoparamétriques.

Il est développé par EDF sous licence GNU/GPLv3.

Il permet de faire à peu près tout ce qui est imaginable en mécanique, voir à ce propos-là plaquette de présentationCe code de calcul est intégré à la suite de logiciels libres Salomé-Méca, qui contient un préprocesseur, Code_Aster, et un post-processeur/vieweur pour voir les résultats.

Aujourd'hui, nous allons utiliser le code en version stand_alone, et nous utiliserons notre éditeur de texte préferé, gmsh, astk, puis de nouveau gmsh pour voir les résultats de nos calculs.

Installation

Cela se passe ici.

Deux options:

1. Soit on compile code_aster

1. Soit on n'aime pas compiler et on télécharge le binaire de Salome-Méca qui contient code_aster de façon préinstallé, et quelques Gio d'outils dont ne nous servirons pas.La compilation se passe assez bien, et les paquets prérequis (voir les instructions de compilation sur leur site) se trouvent assez facilement.

Calcul de Poutre

Nous allons étudier le comportement mécanique d'une poutre encastrée d'un côté et soumise à un effort ponctuel de l'autre côté:

Nous allons le faire de 3 façons:

- En modélisation poutre 1D

- En modélisation plaque 2D

- En modélisation complète 3D

Création de la géométrie avec Gmsh

Pour fonctionner, Code_Aster a besoin d'un fichier de commande, et d'un fichier décrivant un maillage: une liste de nœuds et une liste d'éléments reliant ces nœuds. On pourrait lui fournir un fichier texte contenant les coordonnées géométriques de chaque nœud du maillage, mais vu qu'on a la flemme et que cela peut être assez ennuyeux pour des problèmes complexes, on va demander à Gmsh de le faire pour nous.

On crée tout d'abord la géométrie de notre problème à l'aides de points, de lignes, surfaces et volumes, on doit aussi définir des groupes d’intérêts (la poutre entière, la partie encastrée, et la partie sur laquelle on applique la force). On peut jouer 5 minutes avec la partie GUI de Gmsh pour lequel on trouvera de nombreux tutoriaux sur le web, mais on en revient vite à un fichier texte.

Voici donc poutre1d.geo:

//== parametres == //taille maillage autour des noeuds. 2.5mm entre deux noeuds. cl__1 = 2.5; // == geometrie == //points Point(1) = {0,0, 0, cl__1}; // extremite encastre de ma poutre Point(2) = {100,0, 0, cl__1}; // extremite libre de ma poutre, soumise à une force //lignes Line(1) = {1, 2}; // on cree la ligne entre Point1 et Point2 //== groupe == Physical Point("encastr") = {1}; // on encastrera le noeud correspondant à ce point Physical Point("force") = {2}; //on appliquera la force sur le noeud correspondant à ce point Physical Line ("poutre") = {1}; // notre poutre sera constitue des tous les noeuds et elements correspondant à cette ligneUne fois ce fichier poutre1d.geo crée, on l'ouvre avec gmsh (Terminal: gmsh poutre1d.geo)

On clique sur Mesh > 1D, le maillage est fait, mais on ne le voit pas car seul la géometrie est affichée ! Donc Tools > Options, Onglet Visibily de Géometrie, on décoche Points et Lines et dans Mesh, on coche Nodes and Lines. Cela donne ceci:

Notez qu'avec Tools > Options, dans l'onglet list bowser, on peut visualiser/désafficher (toucher enter du clavier une fois cliqué sur le nom du groupe dans la fenêtre) les groupes que nous avons crée et leurs affectations. C'est très pratique. On voit par exemple bien que notre groupe "poutre" est constitué de tous les éléments de la poutre.

Pour sauvegarder notre maillage, on fait File > Export et on choisit le format de maillage appelé .MED, on obtient donc un beau mesh1d.med. Surtout, on veille à ce que tout soit décoché dans la fenêtre pop-up qui apparaît et on clique rapidement sur OK.

De même, voici poutre2d.geo, qu'on maille en 2D avec gmsh:

//== parametres: == //taille maillage autour des noeuds. 2.5mm entre deux noeuds. cl__1 = 2.5; L=100; //longeur poutre de 100mm R=5; // ratio longueur/largeur l=L/R; //== geometrie == //points Point(1) = {0, 0, 0, cl__1}; Point(2) = {L, 0, 0, cl__1}; Point(3) = {L, l, 0, cl__1}; Point(4) = {0, l, 0, cl__1}; Point(5) = {L, l/2, 0, cl__1}; //lignes Line(1) = {1, 2}; Line(2) = {2, 5}; Line(3) = {5, 3}; Line(4) = {3, 4}; Line(5) = {4, 1}; //surface Line Loop(1) = {1, 2, 3, 4, 5}; //on cree une boucle de lignes Plane Surface(1) = {1}; // on crée une surface à partir de la boucle //== groupe == Physical Line("encastr") = {5}; // on encastrera cette ligne Physical Point("force") = {5}; // lieu application force Physical Surface("poutre") = {1}; // notre poutre 2d

Et poutre3d.geo qu'on mesh en 3D avec gmsh:

//== paramètres: == //taille maillage autour des noeuds. cl__1 = 5; L=100; //longeur poutre R=5; // ratio longueur/largeur l=L/5; //== geometrie == //points Point(1) = {0,0, 0, cl__1}; Point(2) = {L,0, 0, cl__1}; Point(3) = {L,l, 0, cl__1}; Point(4) = {0,l, 0, cl__1}; Point(5) = {L, l/2, 0, cl__1}; //lignes Line(1) = {1, 2}; Line(2) = {2, 3}; Line(3) = {3, 4}; Line(4) = {4, 1}; //surface Line Loop(1) = {1, 2, 3, 4}; Plane Surface(1) = {1}; Point{5} In Surface{1}; // pour que le point 5 soit contenu dans la surface //volume Extrude {0,0,-3}{Surface{1};Layers{3}; Recombine;} //on extdure la surface 1 de -3mm selon l''axe Z //en créant 3 éléments dans l''épaiseur avec l''aide de layers //== groupe == //on sait que c''est la surface 25 parce qu''on le visualise sous gmsh en affichant "surface label". //il peut y avoir une erreur lors de l''import si le numéro de la surface crée par l''extrusion n''est pas 25.' // C''est pas grave, on regarde à quoi correspond la surface à encastrer, on trouve son label, et mon modifie les lignes ci-dessous. Physical Surface("encastr") = {25}; // on encastrera cette surface Physical Point("force") = {5}; // lieu application force Physical Volume("poutre") = {1}; // notre poutre 3d //== mailage == Transfinite Line{1,3}=8*R+1; // 8*R élem dans la longueur = 41 noeuds entre lignes 1 et 3 Transfinite Line{4,2}=8+1; // 8 élem dans la largeur = 9 noeuds entre lignes 4 et 2 Transfinite Surface "*"; // on veut un maillage propre Recombine Surface "*"; // on veut un maillage quadra

Nous voici maintenant avec 3 maillages au format.med Il nous faut maitenant créer notre fichier de commande !

Fichier de commande

#U1.03.02 DEBUT(); #on charge le fichier de maillage .MED, unité logique 20 mesh=LIRE_MAILLAGE( INFO=2, INFO_MED=2, UNITE=20, FORMAT='MED', ); #on a importé le maillage et ses groupes, on crée d'autres groupes: mesh=DEFI_GROUP( reuse =mesh, INFO=2, MAILLAGE=mesh, #on crée un groupe nommé TOUT qui contient toutes les mailles du maillage. #on ne va pas s'en servir, mais ça peut être utile CREA_GROUP_MA=_F(NOM='TOUT',TOUT='OUI',), #on grée un groupe de noeud qui contient tous les noeuds de toutes les mailles. # Il faut le faire quand le maillage provient de Gmsh, car Gmsh transforme les noeuds en maille, on les retransforme ici en noeud CREA_GROUP_NO=_F(TOUT_GROUP_MA='OUI',), ); #on affecte au groupe de maille 'poutre' crée avec gmsh, # des éléments finis de types Poutre, ici POU_D_T model=AFFE_MODELE( MAILLAGE=mesh, AFFE=( _F( GROUP_MA=('poutre',), PHENOMENE='MECANIQUE', MODELISATION='POU_D_T', ), ), ); #on définit un matériaux, ici de l''acier: # Module d'Young' E = 210000 N/mm2 # Coefficient de Poisson, nu = 0.3 # masse volumique = 8e-9 tonne/mm3 steel=DEFI_MATERIAU(ELAS=_F(E=210000.,NU=0.3,RHO=8e-9),); #U4.43.03 #on assigne notre matériaux à nos mailles du groupe 'poutre' material=AFFE_MATERIAU( MAILLAGE=mesh, AFFE=_F(GROUP_MA=('poutre',), MATER=steel,), ); #U4.42.01 #On assigne à nos éléments poutre POU_D_T une section rectangulaire de largeur 20mm et d'épaisseur 3mm elemcar=AFFE_CARA_ELEM( MODELE=model, INFO=2, POUTRE=( _F( GROUP_MA=('poutre',), SECTION='RECTANGLE', CARA=('HY','HZ',), VALE=(3,20), ), ), ); #on interdit toutes rotations et translations aux noeuds du groupe 'encastr' (1 seul noeud ici). # cela simule l'encastrement encast=AFFE_CHAR_MECA( MODELE=model, DDL_IMPO=( _F( GROUP_NO=('encastr',), DX=0,DY=0,DZ=0,DRX=0,DRY=0,DRZ=0, ), ), INFO=1, ); # on applique 500N selon la direction -Z au noeud de notre groupe 'force' force_f=AFFE_CHAR_MECA( MODELE=model, FORCE_NODALE=_F( GROUP_NO=('force',), FZ=-500, ), INFO=2, ); #U4.51.01 #on compile les précédents concepts pour le calcul stat=MECA_STATIQUE( MODELE=model, CHAM_MATER=material, CARA_ELEM=elemcar, EXCIT=( _F(CHARGE=encast,), _F(CHARGE=force_f,), ), ); # Par défaut, sont calculés uniquement les déplacements et les réactions nodales aux points de gauss des éléments, je crois. # du coup on enrichit le concept "stat" pour lui demander d'autres choses. # SIEF_ELNO: ici, efforts théorie des poutres au niveau des nœuds des éléments # SIPO_ELNO: ici, contraintes dans la poutre, au niveau des nœuds des éléments # SIPM_ELNO: ici, contrainte max dans la poutre # REAC_NODA: forces/moments aux nœuds limites stat=CALC_CHAMP( reuse =stat, RESULTAT=stat, CONTRAINTE=( 'SIEF_ELNO','SIPO_ELNO','SIPM_ELNO', ), FORCE=('REAC_NODA',), ); #on imprime ça dans un fichier de sortie .med, unité logique 80. #on n'imprime que les déplacements et les contraintes # (on n'affiche pas tout ce qu'on a calculé, genre SIPM_ELNO ou REAC_NODA pourquoi pas !) IMPR_RESU( FORMAT='MED', UNITE=80, RESU=_F( RESULTAT=stat, NOM_CHAM=( 'DEPL', 'SIPO_ELNO', 'SIPM_ELNO', ), ), ); FIN();(Notez que les #U4.51.01 ou autres renvoient à la documentation )

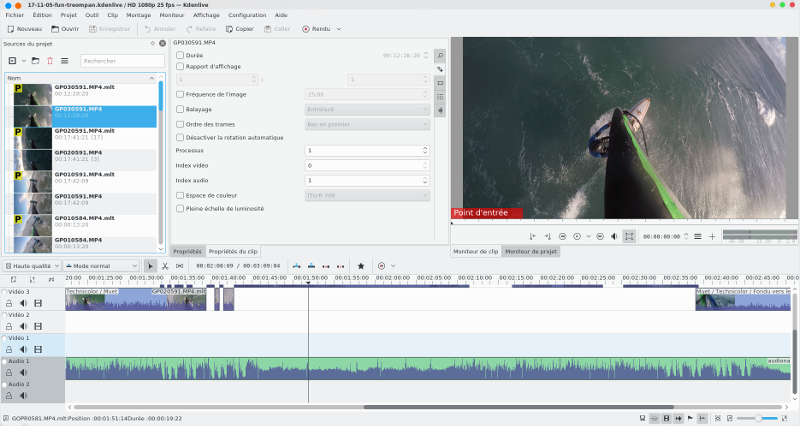

On enregistre ce fichier texte en 1d.comm par exemple, et nous allons lancer le calcul à l'aider d'astk.Astk

Astk est l'outil permettant de mener à bien un calcul, on le lance via /opt/code_aster/bin/astk (si vous avez installé code_aster dans /opt/).

On cherche à obtenir une fenêtre qui a cette allure :

Ensuite :

- File -> New

- on choisit notre path / dossier de travail

- dans la colonne d'icônes au milieu à droite, on clique sur l’icône en forme de dossier bleu, pour aller chercher son mesh1d.med et son 1d.comm

- on clique sur l’icône du dessus pour ajouter deux lignes, puis dans type pour la ligne, on choisit mess et rmed, dans name on les appels ./log1d.mess et ./resu1d.rmed

- File -> Save_As -> 1d.astkLa colonne LU correspond à Logique Unité, c'est l'endroit de la mémoire où je ne sais quoi où on s'attend à trouver le fichier, dans le fichier.comm on a précisé que l'unité logique était 20 pour le maillage .med et 80 pour le résultat .med

Les colonnes DRC veulent dire Datas, Récrire, Compressé.Une fois que cela est fait on clique sur Run ! Le calcul est lancé, il se termine, on va voir le log1d.mess qui a était crée, il contient toutes les infos relatives au calcul.

L'information la plus importante étant la dernière ligne.Chez moi j'ai: EXECUTION_CODE_ASTER_EXIT_13223-localhost=0

Si le code renvoit 0, c'est que cela a fonctionné ! S'il renvoit 1, c'est que ça a planté et qu'il faut débuger…Résultat

Normalement tout a fonctionné, nous avons un beau resu1d.rmed que nous ouvrons aves gmsh (Terminal gmsh resu1d.rmed)

On peut donc voir les déplacements et la contrainte, tout ce dont a besoin un mécanicien pour dimenssionner des systèmes mécaniques !

Voici les paramètres sur lequels agir pour afficher le déplacement multiplié par 10. Il faut afficher des Vectors et non pas l'Original Field. Comme ci-dessous:

Pour les contraintes, SIPO_ELNO contient la contribution de chaque force/moment aux contraintes de la poutre.

C'est grossomodo un vecteur de 6 composantes que voici:

Pour les afficher une par une, on se place dans Options > Visibility > et, en bas, la première case à droite de la liste déroulante Original Field/Scalar Force/Vector/Tensor. 0 Correspond à SN et 5 correspond à SNT, par rapport au tableau ci-dessus. (Je ne sais pas trop ce que présente SIPO_ELNO par défaut)

SIPM_ELNO quant à lui présente par défaut la contrainte maximum selon XX.

Voici d'autre visu avec les modèles 2D et 3D:

Aller plus loin

Code_Aster est très vaste, il contient près de 400 types d'éléments finis ! Pour aller plus loin, n'hésitez pas à lire la doc, qui contient aussi des exemples de calcul qui sont livrés avec le code.

Je vous conseille aussi notamment l'excellent livre sous licence libre de Jean-Pierre Aubry, qui est un passage obligatoire pour prendre en main le code ! (Le code date par contre de la version 11 de Code_Aster, mais une nouvelle version est en cours d'écriture !)

On y fait notamment des analyses non-linéaires avec du contact entre pièces et du frottement.

Aster Study vient aussi de faire son apparition.Voilou cher journal, n'hésite pas à t'amuser !

Je poste en commentaire à ce journal les fichiers .comm de calcul en 2D et 3D.

-

LinuxFr.org : seconde quinzaine de mai 2018

(Journaux LinuxFR)

Nonante-septième épisode dans la communication entre les différents intervenants autour du site LinuxFr.org : l’idée est tenir tout le monde au courant de ce qui est fait par les rédacteurs, les admins, les modérateurs, les codeurs, les membres de l’association, etc.

L’actu résumée (

[*]signifie une modification du sujet du courriel) :Avertissement

Ceci est un second message pour prévenir certains de nos visiteurs qui nous transmettent inutilement des infos sensibles via leur lecteur de flux RSS/Atom, infos qui se retrouvent stockées dans nos logs web.

Format par défaut d'un log du serveur web Nginx (source) :

log_format combined '$remote_addr - $remote_user [$time_local] ' '"$request" $status $body_bytes_sent ' '"$http_referer" "$http_user_agent"';Certains utilisateurs nous transmettent leur nom d'utilisateur distant (pas forcément gênant, mais inutile).

Par contre, certains nous transmettent leur nom d'utilisateur ET leur mot de passe. On a ainsi leur nom d'utilisateur dans le champ

remote_usermais aussi leur nom d'utilisateur et leur mot de passe en clair dans le champhttp_referer, sous la formehttp://login:pass@linuxfr.org/journaux.atomouhttps://login:pass@linuxfr.org/news.atom. Cela concerne 6 utilisateurs différents (tous utilisateurs de FreshRSS), dont 1 a été identifié et contacté en privé. Pour les cinq autres, à savoirJeoffrey,jm,lionel,SVNETettitoko, je vous suggère d'arrêter de nous envoyer votre mot de passe, puis de changer de mot de passe étant donné qu'il a fuité, et aussi d'utiliser préférentiellement la version HTTPS du flux souhaité. N'hésitez pas à me contacter en privé si vous avez des questions (oumph CHEZ linuxfr.org).La version FreshRSS 1.11.0 du 2018-06-03 corrige ce problème Strip HTTP credentials from HTTP Referer in SimplePie #1891.

Statistiques

Du 16 au 31 mai 2018

- 1371 commentaires publiés (dont 11 masqués depuis) ;

- 344 tags posés ;

- 99 comptes ouverts (dont 9 fermés depuis) ;

- 33 entrées de forums publiées (dont 1 masquée depuis) ;

- 32 liens publiés (dont 1 masqué depuis) ;

- 26 dépêches publiées ;

- 30 journaux publiés (dont 1 masqué depuis) ;

- 3 entrées nouvelles, 1 corrigée dans le système de suivi ;

- 0 sondage publié ;

- 2 pages wiki publiées (dont 1 masquée depuis).